- 1. Java

- 1.1 java基础

- 1.2 并发编程 @@@@@

- 1.3 jvm @@@@@

- 1.4 Java EE @@@@@

- 1.5 liteSpring相关知识 @@@@@

- 2. 数据结构与算法

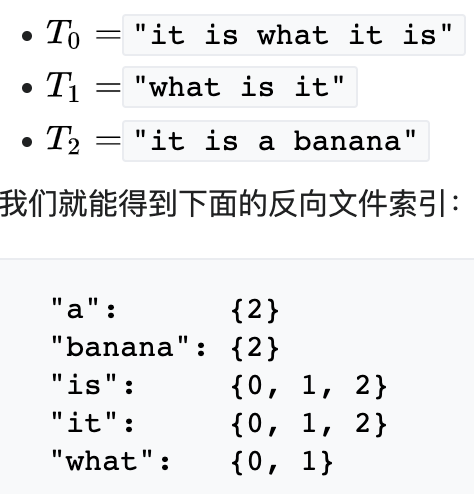

- 3. mysql

- 4. 计算机网络

- 5. 操作系统

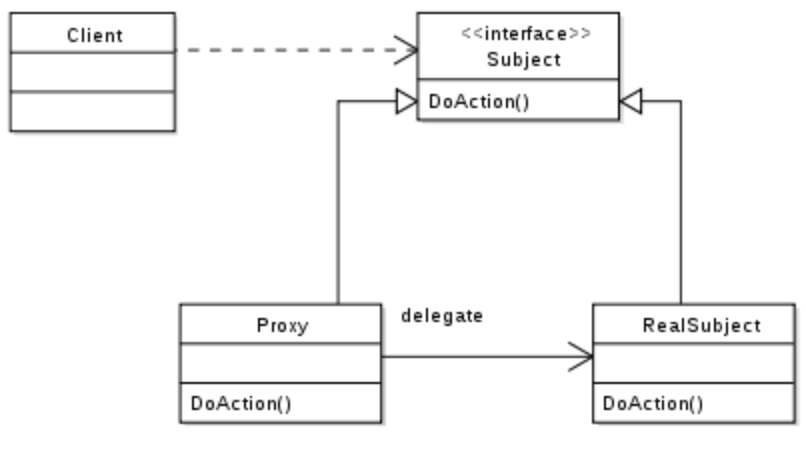

- 6. 设计模式

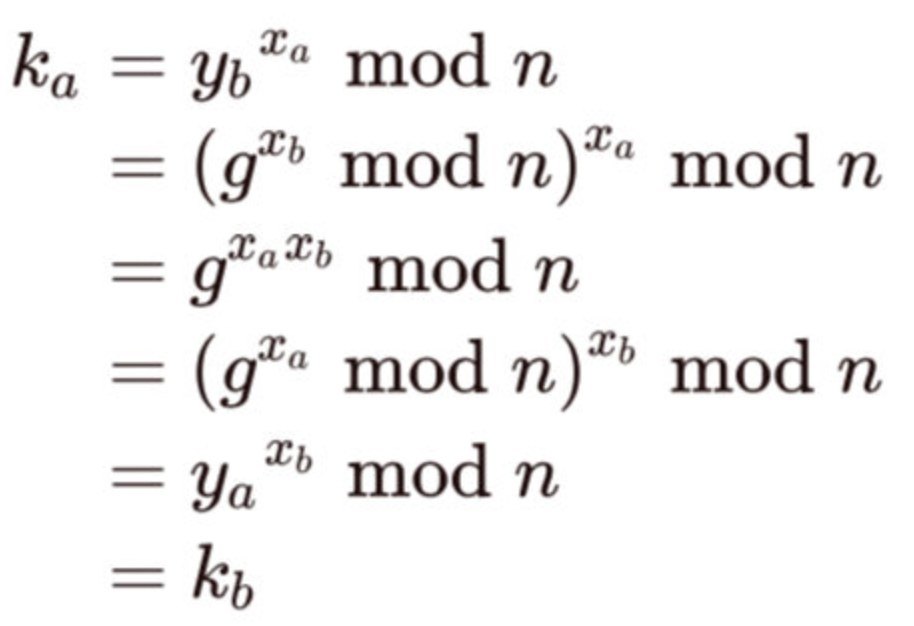

- 7. 分布式算法

- 8. 密码学算法

- 9. 项目

- 10. 其他

1. Java

1.1 java基础

1.1.1 面向对象

1.1.1.1 什么是面向对象?@@@

- 什么是面向过程:把问题分解成一个一个步骤,每个步骤都是函数或者表达式,这样的编程思想就是面向过程。

- 什么是面向对象:对象是属性和行为的集合体。把问题分解成一个一个步骤,每个步骤都是对象及对象的行为调用,这样的编程思想就是面向对象。

- 二者区别:面向过程以过程为中心,关注问题的解决过程顺序,而面向对象以对象为中心,将问题分解并抽象成多个对象,关注对象及对象之间的关系。

- 三大基本特征:

- 封装:把客观事物封装成抽象的类,并且类可以把自己的数据和方法只让可信的类或者对象操作。封装是面向对象的特征之一,是对象和类概念的主要特性。通过这种方式,对象对内部数据提供了不同级别的保护,以防止程序中无关的部分意外的改变或错误的使用了对象的私有部分。

- 继承:可以使用现有类的所有功能,并在无需重新编写原来的类的情况下对这些功能进行扩展。继承的过程,就是从一般到特殊的过程。

- 多态:所谓多态就是指一个类实例的相同方法在不同情形有不同表现形式。多态机制使具有不同内部结构的对象可以共享相同的外部接口。这意味着,虽然针对不同对象的具体操作不同,但通过一个公共的类,它们可以通过相同的方式予以调用。最常见的多态就是将子类传入父类参数中,运行时调用父类方法时通过传入的子类决定具体的内部结构或行为。

- 重载(Overload):同一个类,签名不一样,编译期。函数的返回值不同不可以构成重载。

- 重写(override):子类重写父类,签名一样,运行期。

- 五大原则:

- S:单一职责原则:一个类,最好只做一件事,只有一个引起它的变化。

- O:开放封闭原则:软件实体应该是可扩展的,而不可修改的。也就是,对扩展开放,对修改封闭的。

- L:里氏替换原则:子类必须能够替换其基类。

- I:接口隔离原则:我们在进行类和接口设计时,如果在一个接口里定义了太多方法,其子类很可能面临两难,就是只有部分方法对它是有意义的,这就破坏了程序的内聚性。

- D:依赖倒置原则:实体应该依赖于抽象而不是实现。也就是说高层次模块,不应该依赖于低层次模块,而是应该基于抽象。实践这一原则是保证产品代码之间适当耦合度的法宝。

1.1.1.2 值传递

Java中只有值传递。

- 形参和实参:前者是用于接收实参内容的参数,后者是真正传递的内容。

- 值传递和引用传递的区别在于:传递后会不会影响实参的值,前者会创建副本,后者不会创建副本。

1.1.1.3 组合和继承 @@@

- 组合是has-a,继承是is-a;多用组合,少用继承;只有需要从新类向基类进行向上转型的时候,才使用继承。

| 组 合 关 系 | 继 承 关 系 |

|---|---|

| 优点:不破坏封装,整体类与局部类之间松耦合,彼此相对独立 | 缺点:破坏封装,子类与父类之间紧密耦合,子类依赖于父类的实现,子类缺乏独立性 |

| 优点:具有较好的可扩展性 | 缺点:支持扩展,但是往往以增加系统结构的复杂度为代价 |

| 优点:支持动态组合。在运行时,整体对象可以选择不同类型的局部对象 | 缺点:不支持动态继承。在运行时,子类无法选择不同的父类 |

| 优点:整体类可以对局部类进行包装,封装局部类的接口,提供新的接口 | 缺点:子类不能改变父类的接口 |

| 缺点:整体类不能自动获得和局部类同样的接口 | 优点:子类能自动继承父类的接口 |

| 缺点:创建整体类的对象时,需要创建所有局部类的对象 | 优点:创建子类的对象时,无须创建父类的对象 |

1.1.1.4 成员变量和方法的作用域

- public :表明该成员变量或者方法是对所有类或者对象都是可见的,所有类或者对象都可以直接访问

- protected:表明成员变量或者方法对类自身,与同在一个包中的其他类可见,其他包下的类不可访问,除非是他的子类

- default:表明该成员变量或者方法只有自己和其位于同一个包的内可见,其他包内的类不能访问,即便是它的子类。

- private:表明该成员变量或者方法是私有的,只有当前类对其具有访问权限,除此之外其他类或者对象都没有访问权限.子类也没有访问权限。

外部类的作用域只有public和default。因为如果是private,那么别的类就无法对其进行实例化,毫无意义。对于protected,类B继承类A的前提又是类B可以访问到类A。继承的核心是继承属性和方法,在说一句,只有可以访问到,才有继承。所以类的修饰符只有public和default。

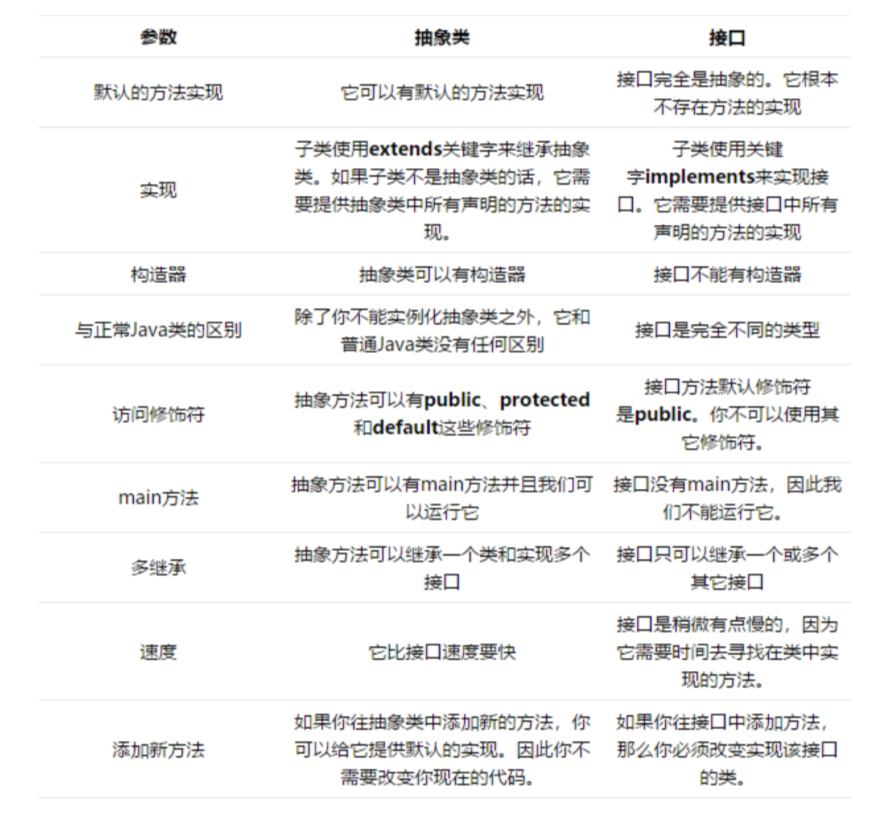

1.1.1.5 抽象类和接口

- 抽象类是不能实例化的类,用abstract关键字修饰class,其目的主要是代码重用。除了不能实例化,形式上和一般的Java类并没有太大区别,可以有一个或者多个抽象方法,也可 以没有抽象方法。抽象类大多用于抽取相关Java类的共用方法实现或者是共同成员变量,然后通过继承的方式达到代码复用的目的。Java标准库中,比如collection框架,很多通用 部分就被抽取成为抽象类,例如java.util.AbstractList。

- 接口:对行为进行抽象。是抽象方法的集合,利用接口可以达到API定义和实现分离的目的。接口,不能实例化;不能包含任何非常量成员,任何feld都是隐含着public static final的意义;同时,没有非静态方法实现,也就是说要么是抽象方法,要么是静态方法。Java标准类库中,定义了非常多的接口,比如java.util.List。

如何选择:

- 如果要创建不带任何方法定义和成员变量的基类,那么就应该选择接口而不是抽象类。

- 如果知道某个类应该是基类,那么第一个选择的应该是让它成为一个接口,只有在必须要有方法定义和成员变量的时候,才应该选择抽象类。因为抽象类中允许存在一个或多个被具体实现的方法,只要方法没有被全部实现该类就仍是抽象类。

1.1.1.6 内部类

- 每个内部类都能独立地继承一个实现,所以无论外围类是否已经继承了某个实现,对于内部类都没有影响,解决多重继承问题。

- 内部类可以用多个实例,每个实例都有自己的状态信息,并且与其他外围对象的信息相互独立。

- 在单个外围类中,可以让多个内部类以不同的方式实现同一个接口,或者继承同一个类。

- 创建内部类对象的时刻并不依赖于外围类对象的创建。

- 内部类并没有令人迷惑的“is-a”关系,他就是一个独立的实体。

- 内部类提供了更好的封装,除了该外围类,其他类都不能访问。

- 匿名内部类无显示引用。

1.1.1.7 Object类相关题目 @@@@@

public final native Class<?> getClass()//native方法,用于返回当前运行时对象的Class对象,使用了 final关键字修饰,故不允许子类重写。

public native int hashCode() //native方法,用于返回对象的哈希码,主要使用在哈希表中,比如JDK中的 HashMap。

public boolean equals(Object obj)//用于比较2个对象的内存地址是否相等,String类对该方法进行了重写用户比较字符串的值是否相等。

protected native Object clone() throws CloneNotSupportedException//naitive方法,用于创建并返回 当前对象的一份拷贝。一般情况下,对于任何对象 x,表达式 x.clone() != x 为true,x.clone().getClass() == x.getClass() 为true。Object本身没有实现Cloneable接口,所以不重写clone方法并且进行调用的话会发生 CloneNotSupportedException异常。

public String toString()//返回类的名字@实例的哈希码的16进制的字符串。建议Object所有的子类都重写这个方 法。

public final native void notify()//native方法,并且不能重写。唤醒一个在此对象监视器上等待的线程(监视 器相当于就是锁的概念)。如果有多个线程在等待只会任意唤醒一个。

public final native void notifyAll()//native方法,并且不能重写。跟notify一样,唯一的区别就是会唤醒 在此对象监视器上等待的所有线程,而不是一个线程。

public final native void wait(long timeout) throws InterruptedException//native方法,并且不能 重写。暂停线程的执行。注意:sleep方法没有释放锁,而wait方法释放了锁 。timeout是等待时间。

public final void wait(long timeout, int nanos) throws InterruptedException//多了nanos参数, 这个参数表示额外时间(以毫微秒为单位,范围是 0-999999)。 所以超时的时间还需要加上nanos毫秒。

public final void wait() throws InterruptedException//跟之前的2个wait方法一样,只不过该方法一直等 待,没有超时时间这个概念

protected void finalize() throws Throwable { }//实例被垃圾回收器回收的时候触发的操作

- hashCode()与equals()的相关规定

-

如果两个对象相等,则hashcode一定也是相同的

- 两个对象有相同的hashcode值,它们也不一定是相等的。因为hashCode() 所使用的杂凑算法也许刚好会让多个对象传回相同的杂凑值

- equals方法被覆盖过,则hashCode方法也必须被覆盖。

速度的考量。因为相同对象的hash值必然相等,hashcode用来把对象的地址映射为一个整数,用来定位一个对象。如果不重写,那么两个对象的hash值大概率是不相等的,所以必须重写。

- 为什么要有hashCode

先判断hashcode,如果不相等,可以立即返回。这样我们可以大大减少equals的次数,相应就大大提高了执行速度。

- ==与equals

== : 它的作用是判断两个对象的地址是不是相等。即,判断两个对象是不是同一个对象。(基本数据类型==比较的是值,引用数据类型==比较的是内存地址)

equals() : 它的作用也是判断两个对象是否相等。但它一般有两种使用情况:

-

类没有覆盖equals()方法。则通过equals()比较该类的两个对象时,等价于通过“==”比较这两个对象。

-

类覆盖了equals()方法。一般,我们都覆盖equals()方法来两个对象的内容相等;若它们的内容相等, 则返回true(即,认为这两个对象相等)。

1.1.2 基础知识

1.1.2.1 自动拆装箱 @@@

-

WHY:为什么需要自动拆装箱?因为需要在基本数据类型和包装类之类进行转换。

为什么需要包装类? 1. 基本类型无法表示null。2. java是面向对象的,很多地方必须使用对象,比如集合,需要使用泛型。

-

WHAT:什么是自动拆装箱? 就是将包装类自动转换成对应的基本数据类型。

-

HOW:自动拆装箱是如何实现的? 自动装箱:

***.valueOf();自动拆箱:xxxValue() -

WHERE:什么地方可能会自动进行自动拆装箱

- 三目运算符;基本数据类型放到集合类;包装类型和基本类型的大小比较;

-

OTHER:自动拆装箱可能会带来那些问题?

- Interger的缓存问题:缓存支持-128到127之间的自动装箱过程

- 包装对象的数值比较,不能简单的使用

==,虽然-128到127之间的数字可以,但是这个范围之外还是需要使用equals比较。 - 由于自动拆箱,如果包装类对象为null,那么自动拆箱时就有可能抛出NPE。

- 如果一个增强for循环中有大量拆装箱操作,会浪费很多资源。

1.1.2.3 String相关 @@@@@

-

字符串的不可变性(String是用final数组实现的)

-

- jdk6仍然指向原字符串,会造成内存泄露的问题;jdk7会创建一个新的字符串;

- String对“+”的重载、字符串拼接的几种方式和区别

- +是唯一重载的运算符。每次都会new StringBuilder,使用了StringBuilder以及他的append、toString两个方法。

- “a”+”b”是在编译期完成的,s1+”b”和s1+s2是在运行期完成的。

-

字符串池、常量池(运行时常量池、Class常量池)、intern

- class常量池是编译期生成的,”a”+”b”这种会在编译期直接优化为”ab”,但是s1+s2在运行期才知道

- 运行时常量池:class常量池在运行期的,不同的jdk位置也不同

- 字符串常量池:1.6之后,只存储字面量的引用

- intern:如果已经有缓存的字符串,就会返回缓存里的实例,否则将其缓存起来。使用intern后直接指向字面量所在的位置。1.6之前是在永久代中的。7放到了堆中,jdk8本地内存元数据区。

- 直接使用双引号声明出来的 String 对象会直接存储在常量池中。

String str1 = "abcd";//先检查字符串常量池中有没有"abcd",如果字符串常量池中没有,则创建一个,然后 str1 指向字符串常量池中的对象,如果有,则直接将 str1 指向"abcd"";

String str2 = new String("abcd");//堆中创建一个新的对象

String str3 = new String("abcd");//堆中创建一个新的对象

String str4 = new String("abcd").intern();

System.out.println(str1==str2);//false

System.out.println(str2==str3);//false

System.out.ptrintln(str1==str4);//true

第一种方式是在常量池中拿对象;第二种方式是直接在堆内存空间创建一个新的对象。

String s1 = new String(“abc”);创建几个对象。将创建 1 或 2 个。如果池中已存在字符串常量“abc”,则只会在堆空间创建一个字符串常量“abc”。如果池中没有字符串常量“abc”,那么它将首先在池中创建,然后在堆空间中创建,因此将创建总共 2 个字符串对象。

-

String、StringBuffer、StringBuilder区别

-

String StringBuffer StringBuilder 可变 否,final数组 是 是 线程安全 是 是 否 修改创建新对象 是 否 否

-

1.1.2.4 java关键字

1.1.2.4.1 transient

禁止某个变量序列化。

1)一旦变量被transient修饰,变量将不再是对象持久化的一部分,该变量内容在序列化后无法获得访问。

2)transient关键字只能修饰变量,而不能修饰方法和类。

3)被transient关键字修饰的变量不再能被序列化,一个静态变量不管是否被transient修饰,均不能被序列化。

序列化的本质是序列化对象,而不是类相关的信息。 Arraylist会用到。

1.1.2.4.2 staic @@@@

- static变量

- 静态变量是随着类加载时被完成初始化的,它在内存中仅有一个,且JVM也只会为它分配一次内存,同时类所有的实例都共享静态变量,可以直接通过类名来访问它。

- 实例变量则不同,它是伴随着实例的,每创建一个实例就会产生一个实例变量,它与该实例同生共死。

- static方法: 通过类名对其进行直接调用

- static代码块:被static修饰的代码块,我们称之为静态代码块,静态代码块会随着类的加载一块执行,而且他可以随意放,可以存在于的任何地方。

- 执行顺序: 静态代码块 > 构造代码块(指的是{}括起来的代码块) > 构造函数

1.1.2.4.3 final vs finally vs finalize @@@@

不想被改变的原因有两个:效率、设计。

- final常量

- 编译期常量,永远不可改变。只能使用基本类型,而且必须要在定义时进行初始化。

- 运行期初始化时,我们希望它不会被改变。希望它可以根据对象的不同而表现不同,但同时又不希望它被改变,这个时候我们就可以使用运行期常量。对于运行期常量,它既可是基本数据类型,也可是引用数据类型。基本数据类型不可变的是其内容,而引用数据类型不可变的是其引用,引用所指定的对象内容是可变的。

- 在并发编程中,可以用来保护只读数据,减少了同步开销。

- final方法:所有被final标注的方法都是不能被继承、更改的。不可以重写的(override)。

- final类:该类是最终类,它不希望也不允许其他来继承它。

- final参数:代表了该参数是不可改变的(指向不变,但指向的内容本身可以变化)

- final & static

- final强调的是不可改变的量

- static强调的生命周期

fnally则是Java保证重点代码一定要被执行的一种机制。我们可以使用try-fnally或者try-catch-fnally来进行类似关闭JDBC连接、保证unlock锁等动作。

finalize是基础类java.lang.Object的一个方法,它的设计目的是保证对象在被垃圾收集前完成特定资源的回收。fnalize机制现在已经不推荐使用,并且在JDK 9开始被标记 为deprecated。fnalize本质上成为了快速回收的阻碍者,可能 导致你的对象经过多个垃圾收集周期才能被回收。拖慢垃圾收集,导致大量对象堆积。

1.1.2.4.4 swith

switch:其实swich只支持一种数据类型,那就是整型,其他数据类型都是转换成整型之后在使用switch的。

整型:直接比较整数的值; 字符:比较ASCII码 ;字符串:equals和hashcode

1.1.2.4.5 java中的深拷贝和浅拷贝

一个拷贝引用,另外一个重新分配空间。

- 浅拷贝:对基本数据类型进行值传递,对引用数据类型进行引用传递般的拷贝,此为浅拷贝。

- 深拷贝:对基本数据类型进行值传递,对引用数据类型,创建一个新的对象,并复制其内容,此为深拷贝。

1.1.2.5 其他

- 泛型。java中的泛型是假的,因为编译的时候会进行擦除。可以通过反射的方法绕过泛型。例子:

List<Integer> list = new ArrayList<>();

list.add(1);

//list.add("a"); // 这样直接添加肯定是不允许的

//下面通过java的反射,绕过泛型 来给添加字符串

Method add = list.getClass().getMethod("add", Object.class);

add.invoke(list,"a");

导致问题:通过反射来封装的框架,如MyBatis,SpringMVC等会遇到该问题。

- 浮点型在内存中的表示

float :1位符号位, 8位指数位,23位尾数位;double:1位符号位,11位指数位,52位尾数位。

1.1.3 集合@@@@@

1.1.3.1 常用集合类的使用

-

数组:数组是将数字和对象联系起来,它保存明确的对象。(固定大小)

-

Collection:保存单一的元素(可扩容)

-

list:有序可重复的Collection,有序指的是放入顺序,而不是大小顺序。

ArrayList LinkedList Vector Stack SynchronizedList 实现方式 Object数组 1.6之前是循环链表,之后是双向链表,deque 数组 继承自Vector,实现一个后进先出的堆栈 线程安全 否 否 是 是 是,同步代码块,遍历需要手动同步,可以锁定指定对象 扩容 初始容量是10,1.5倍 2倍 1.5

-

- ArrayList的扩容机制:add方法会调用ensureCapacityInternal(size + 1)方法,然后会调用ensureExplicitCapacity(minCapacity)方法,当需要扩容的时候,调用grow(minCapacity)方法,会计算新的容量(原来的1.5倍),然后会调用Arrays.copyOf进行拷贝。

Arrays.copyOf()调用了System.arraycopy()方法。

- Arrays.copyOf(T[] original, int newLength):系统自动在内部新建一个数组,并返回该数组。

- System.arraycopy(Object src, int srcPos, Object dest, int destPos, int length):需要目标数组,将原数组拷贝到你自己定义的数组里或者原数组,而且可以选择拷贝的起点和长度以及放入新数组中的位置。

ArrayList本身不提供自动缩容的方法(remove方法并没有提供),但是提供了trimToSize手动缩容的方法(只保留有效的元素)。

- ArrayList是怎么实现序列化和反序列化的

把elementData定义为transient,然后重写writeObject和readObject方法,优势在于自己根据size序列化真实的元素,而不是根据数组的长度序列化元素,减少了空间占用。

- PriorityQueue(优先队列)

Queue常见方法比较:

add vs offer:添加元素。如果队列满,add会抛异常,offer会返回false;

remove vs poll:删除元素。如果队列空,前者抛异常,后者返回null;

element vs peek:查看第一个。前者抛异常,后者返回null。

-

set无序不可重复

HashSet 初始容量 16 加载因子 0.75 扩容 2倍 List,Set都是继承自Collection接口。都是用来存储一组相同类型的元素的。

List Set 顺序 有 无 重复 可以 不可

HashSet基于HashMap。

-

Set怎么保证添加元素不重复?

在Java的Set体系中,根据实现方式不同主要分为两大类。HashSet和TreeSet。

1)TreeSet 是二叉树实现的,Treeset中的数据是自动排好序的,不允许放入null值 ,TreeMap红黑树(自平衡的排序二叉树)。

2)HashSet 是哈希表实现的,HashSet中的数据是无序的,可以放入null,但只能放入一个null。

HashSet内部使用HashMap的key存储元素,以此来保证元素不重复;当你把对象加入

HashSet时,HashSet会先计算对象的hashcode值来判断对象加入的位置,同时也会与其他加入的对象的hashcode值作比较,如果没有相符的hashcode,HashSet会假设对象没有重复出现。但是如果发现有相同hashcode值的对象,这时会调用equals()方法来检查hashcode相等的对象是否真的相同。如果两者相同,HashSet就不会让加入操作成功。TreeSet的底层是TreeMap的keySet(),而TreeMap是基于红黑树实现的,红黑树是一种平衡二叉查找树,它能保证任何一个节点的左右子树的高度差不会超过较矮的那棵的一倍。

TreeMap是按key排序的,元素在插入TreeSet时compareTo()方法要被调用,所以TreeSet中的元素要实现Comparable接口。TreeSet作为一种Set,它不允许出现重复元素。TreeSet是用compareTo()来判断重复元素的。

-

HashSet是有序的吗?HashSet是无序的,因为Hashset的值保存在hashmap的key中。

-

HashSet是否允许null元素?HashSet中允许有一个null元素,因为HashMap允许key为null;

-

HashSet是非线程安全的;

-

HashSet是没有get()方法的;

-

LinkedHashSet的底层使用LinkedHashMap存储元素。

-

LinkedHashSet是有序的吗?怎么个有序法?LinkedHashSet是有序的,它是按照插入的顺序排序的。

-

TreeSet是有序的;

-

TreeSet是非线程安全的;

HashSet无序,Hashmap无序,LinkedHasmap可以按照插入顺序,也可以按照访问顺序,TreeMap的顺序是键的字典序(也可以注自定义),基于红黑树来实现。

-

map:保存相关联的值键对

HashMap HashTable LinkedHashMap ConcurrentHashMap null 键和值都可以为null(只允许一条) 键和值都不允许为null 键和值都不允许为null 线程安全 否 是 否 是 插入顺序 否(插入的时候算hash) 插入有序(也可以按照访问顺序来排序),双向链表 加锁粒度 整个table只加了一把锁 jdk7分段来加锁,Segment默认是16,2的幂;jdk8取消了Segment分段锁,使用synchronized 和 CAS,只锁定当前链表或红黑二叉树的首节点 容量和扩容 初始16,扩容*2 初始11,扩容old*2+1 hash值 重新计算 直接使用对象的hashCode 遍历方式 Iterator Enumeration,Iterator

Segment继承了ReentrantLock,所以它就是一种可重入锁(ReentrantLock)。

(1)HashMap是一种散列表,采用(数组+ 链表 + 红黑树)的存储结构;

(2)HashMap的默认初始容量为16(1«4),默认装载因子为0.75f,容量总是2的n次方;

(3)HashMap扩容时每次容量变为原来的两倍;

(4)当桶的数量小于64时不会进行树化,只会扩容;

(5)当桶的数量大于64且单个桶中元素的数量大于8时,进行树化;

(6)当单个桶中元素数量小于6时,进行反树化;

(7)HashMap数组的查询效率为O(1),链表的查询效率是O(k),红黑树的查询效率是O(log k)

HashMap的核心概念:

- size 和 capacity:size记录了Map中KV对的个数,数组的长度(实际的长度);capacity:最多装的元素

- loadFactor

- 用来衡量HashMap满的程度,loadFactor的默认值为0.75f

- 0.75有一个好处,那就是0.75正好是3/4,而capacity又是2的幂。所以,两个数的乘积都是整数。一个bucket空或者非空,由牛顿二项式可得,负载因子的值为log2,约为0.693,又因为必须是2的倍数,所以是0.75

- threshold:临界值,当实际KV个数超过threshold时,HashMap会将容量扩容,threshold=容量*加载因子。

- 用来衡量HashMap满的程度,loadFactor的默认值为0.75f

HashMap 的长度为什么是2的幂次方

为了能让 HashMap 存取高效,尽量较少碰撞,也就是要尽量把数据分配均匀。Hash 值的范围值-2147483648到2147483647,前后加起来大概40亿的映射空间。但问题是一个40亿长度的数组,内存是放不下的。所以这个散列值是不能直接拿来用的。用之前还要先做对数组的长度取模运算,得到的余数才能用来要存放的位置也就是对应的数组下标。这个数组下标的计算方法是“ (n - 1) & hash”。(n代表数组长度)。这也就解释了 HashMap 的长度为什么是2的幂次方。但是,“取余(%)操作中如果除数是2的幂次则等价于与其除数减一的与(&)操作(也就是说 hash%length==hash&(length-1)的前提是 length 是2的 n 次方;)。” 并且 采用二进制位操作 &,相对于%能够提高运算效率,这就解释了 HashMap 的长度为什么是2的幂次方。

HashMap中的hash算法实现

- hash :该方法主要是将Object转换成一个整型。包含h = key.hashCode()) ^ (h »> 16),hash冲突解决:开放定址法(线性探测在散列,二次探测在散列),再hash法,链地址法,建立公共溢出区。

- indexFor :该方法主要是将hash生成的整型转换成链表数组中的下标。(n-1)&hash

hash冲突的时候,会使用拉链法,对于key的比较,会同时使用==和equals,好处是如果是同一个对象,不需要在进行比较,如果不是,才会比较内容,如果键很复杂,可以节省时间。

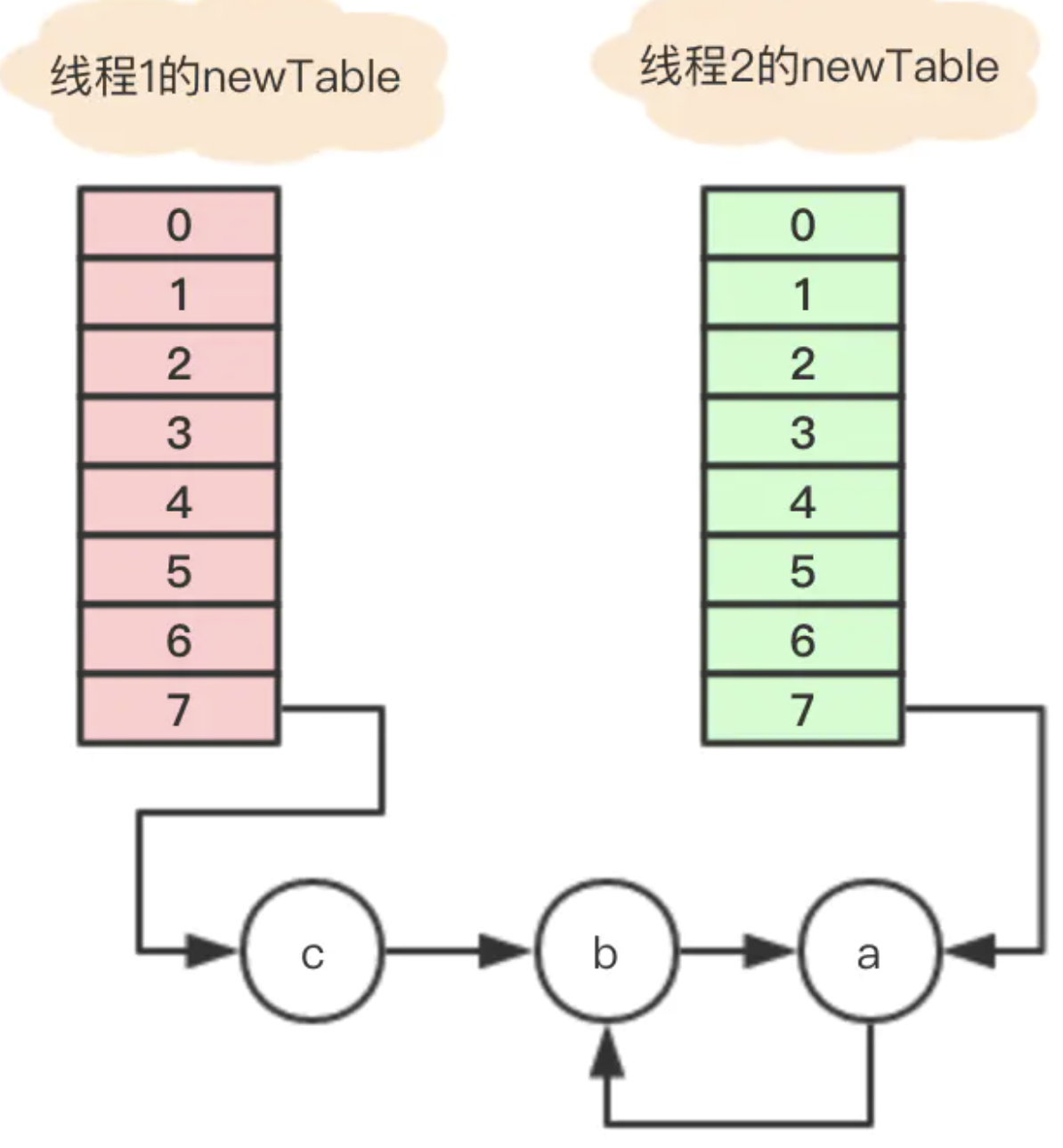

HashMap多线程扩容死循环:

put方法:判断key是否存在,如果存在,就拉链法;如果不存在,则插入新节点,在插入的时候,会判断是否达到阈值,如果达到,会进行扩容,对链表元素进行rehash,插入到新的数组中。

在并发的情况,发生扩容时,多个线程都会创建自己的数组,可能会产生循环链表(链表采用头插法),在执行get的时候,会触发死循环,引起CPU的100%问题。还可能存在数据丢失的问题。

LinkedHashMap:

继承hashmap,用在LRU缓存实现中。hashmap查找方便,但是无序。为了同时满足这两个特性,我们提出了linkedhashmap。

1.1.3.2 Collections和Arrays区别

我们一般使用Comparator,而不是Comparable。如降序,默认是升序:

Arrays.sort(input, new Comparator<Integer>() {

@Override

public int compare(Integer o1, Integer o2) {

return o2.compareTo(o1);

}

});

Collections 工具类常用方法:

void reverse(List list)//反转

void shuffle(List list)//随机排序

void sort(List list)//按自然排序的升序排序

void sort(List list, Comparator c)//定制排序,由Comparator控制排序逻辑

void swap(List list, int i , int j)//交换两个索引位置的元素

void rotate(List list, int distance)//旋转。当distance为正数时,将list后distance个元素整体移到前面。当distance为负数时,将 list的前distance个元素整体移到后面。

int binarySearch(List list, Object key)//对List进行二分查找,返回索引,注意List必须是有序的

int max(Collection coll)//根据元素的自然顺序,返回最大的元素。 类比int min(Collection coll)

int max(Collection coll, Comparator c)//根据定制排序,返回最大元素,排序规则由Comparatator类控制。类比int min(Collection coll, Comparator c)

void fill(List list, Object obj)//用指定的元素代替指定list中的所有元素。

int frequency(Collection c, Object o)//统计元素出现次数

int indexOfSubList(List list, List target)//统计target在list中第一次出现的索引,找不到则返回-1,类比int lastIndexOfSubList(List source, list target).

boolean replaceAll(List list, Object oldVal, Object newVal), 用新元素替换旧元素

Arrays常用方法:

排序 : sort(),Arrays.sort({ 1, 3, 2, 7, 6, 5, 4, 9 });

查找 : binarySearch()

比较: equals()

填充 : fill()

转列表: asList()

转字符串 : toString()

复制: copyOf()

1.1.4 IO BIO NIO AIO @@@

同步异步关注消息通信机制,在发起调用后,前者是指直到有结果产生才返回,后者是指立刻无结果的返回,真正的处理结果通过通知/回调的形式。阻塞,非阻塞,是指调用方线程会不会放弃CPU。同步不一定阻塞,异步也不一定非阻塞。

- BIO (Blocking I/O): 同步阻塞 I/O 模式,数据的读取写入必须阻塞在一个线程内等待其完成。在活动连接数不是特别高的情况下,这种模型是比较不错的,可以让每一个连接专注于自己的 I/O 并且编程模型简单,也不用过多考虑系统的过载、限流等问题。但是,当面对十万甚至百万级连接的时候,传统的 BIO 模型是无能为力的。

- NIO (Non-blocking/New I/O): NIO 是一种同步非阻塞的 I/O 模型。 Channel,类似在Linux之类操作系统上看到的文件描述符,是NIO中被用来支持批量式IO操作的一种抽象。File或者Socket,通常被认为是比较高层次的抽象,而Channel则是更加操作系统底层的一种抽象,这也使得NIO得以充分利用现代操作系统底层机制,获得特定场景的性能优化,例如,DMA(Direct Memory Access)等。不同层次的抽象是相互关联的,我们可以通过Socket获取Channel,反之亦然。Selector,是NIO实现多路复用的基础,它提供了一种高效的机制,可以检测到注册在Selector上的多Channel中,是否有Channel处于就绪状态,进而实现了单线程对 多Channel的高效管理。

- IO都是同步阻塞模式,所以需要多线程以实现多任务处理。

- NIO则是利用了单线程轮询事件的机制,通过高效地定位就绪的Channel,来决定做什 么,仅仅select阶段是阻塞的,可以有效避免大量客户端连接时,频繁线程切换带来的问题,应用的扩展能力有了非常大的提高。

- AIO (Asynchronous I/O): AIO 也就是 NIO 2。在 Java 7 中引入了 NIO 的改进版 NIO 2,它是异步非阻塞的 IO 模型。异步 IO 是基于事件和回调机制实现的,也就是应用操作之后会直接返回,不会堵塞在那里,当后台处理完成,操作系统会通知相应的线程进行后续的操作。AIO 是异步 IO 的缩写,虽然 NIO 在网络操作中,提供了非阻塞的方法,但是 NIO 的 IO 行为还是同步的。

1.1.5 序列化

- 什么是序列化与反序列化?

- 序列化 (Serialization)是将对象的状态信息转换为可以存储或传输的形式的过程。

- 序列化底层原理:writeObject和readObject方法

1.1.6 异常@@@

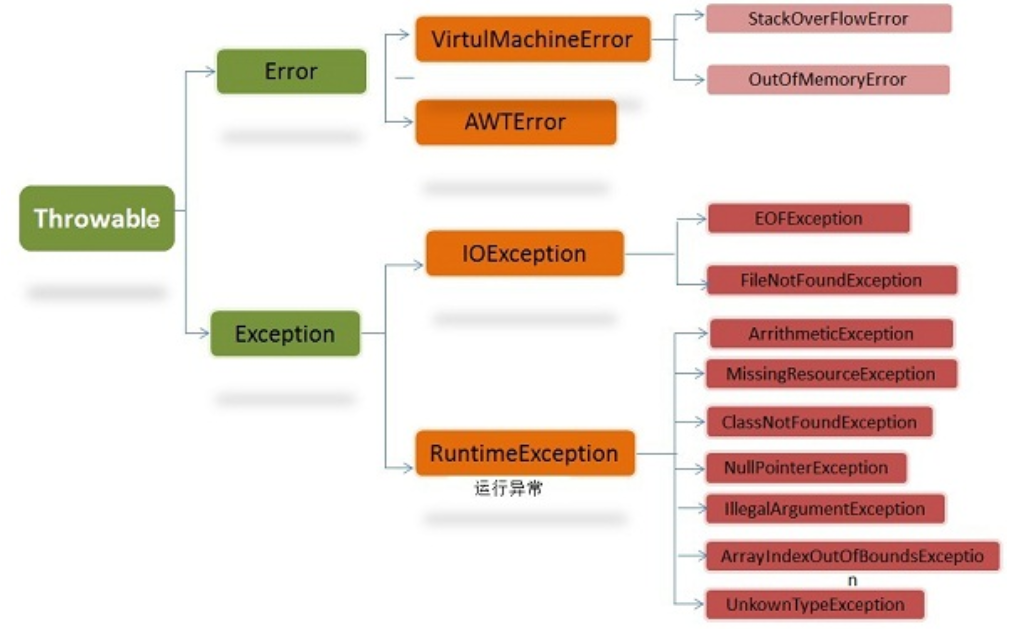

异常和错误的区别:异常能被程序本身可以处理,错误是无法处理。NoClassDefFoundError。

finally和return的执行顺序:在return之前是会保证finally执行的。

1.2 并发编程 @@@@@

单核时代,I/O速度慢,cpu快,提高综合利用率。多核时代:可以同时运行多个线程。服务端可以处理更多的客户端的请求。

但同时设计上更加复杂,增加上下文切换的开销。

1.2.1 线程 @@@@@

1.2.2.1 线程的状态

- 新建(new),runnable(可运行/运行),休眠(BLOCKED阻塞状态,WAITING无时限等待,TIMED_WAITING有时限等待),TERMINATED终止。

- sleep和wait

- sleep不释放锁,wait会释放锁。wait通常被用于线程间交互/通信,sleep 通常被用于暂停执行。wait只能在同步方法和同步块中使用,而sleep任何地方都可以;wait无需捕捉异常,而sleep需要;sleep是Thread的方法,而wait是Object类的方法;

- sleep()方法和yield()

- sleep()方法给其他线程运行机会时不考虑线程的优先级,yield()方法只会给相同优先级或更高优先级的线程以运行的机会;

- 线程执行sleep()方法后转入阻塞(blocked)状态,而执行yield()方法后转入就绪(ready)状态,让出CPU。

- sleep()方法声明抛出InterruptedException,而yield()方法没有声明任何异常;

join方法用于等待其他线程运行终止,如果当前线程调用了另一个线程的join方法,则当前线程进入阻塞状态,当另一个线程结束时当前线程才能从阻塞状态转为就绪态,等待获取CPU时间片。

- notify 和 notifyAll

- notify是随机唤醒一个,notifyAll是唤醒全部

- 为什么调用start,而不是run

- 调用start会使线程进入就绪状态,run只是一个普通的方法调用,还是在主线程去执行。

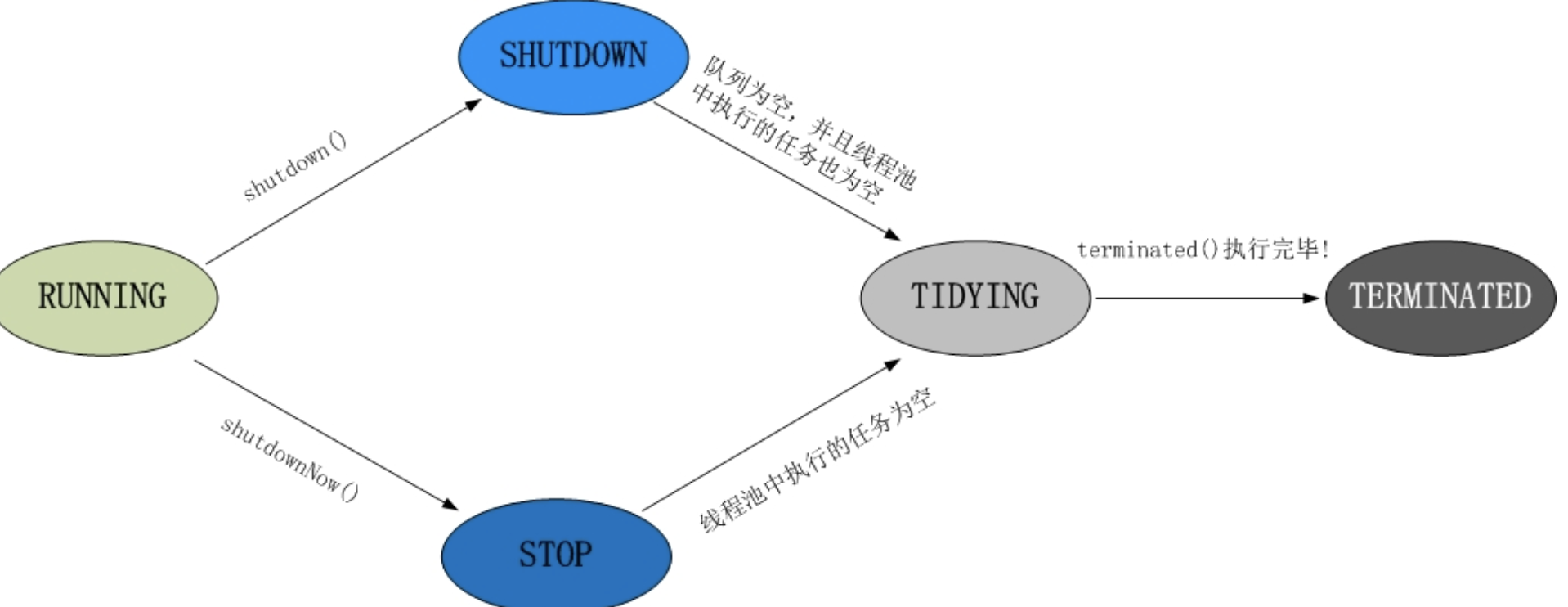

线程池的状态:

RUNNING:初始化为RUNNING,可以接收新任务,并对任务进行处理。

SHUTDOWN:不再接收新任务,可以处理已添加的任务。

stop:不接受新任务,不处理已添加任务。

TIDYING:任务全部执行完,可以重载terminated()函数进行处理。

TERMINATED:彻底终止。

常见问题:

- 三个线程T1,T2和T3,线程T3必须等到T1,T2都结束之后才能开始,应该怎么做?

T3的run方法中调用t1.join,t2.join。

-

线程T1有三个代码段,线程T2有两个代码段,线程T3必须等待T1执行完第二个代码段,T2执行完第一个代码段之后才能开始,应该怎么做?

-

8个运动员,1个发令员,1个裁判员,发令员要在8个运动员都准备好之后才能法令,运动员在发令员法令之后才能跑,裁判员要在8个运动员都跑完之后才能评分,如果每个人看作一个线程(一共10个线程)的话,这个系统该如何设计,可以保证这种顺序关系?

一个变量reday_count: 记录准备好的运动员个数,在运动员线程中,准备好就reday_count++, 发令员线程不断循环查看该变量,当reday_count=8时,发令。reday_count要保证线程安全。

一个发令变量,当发令员线程发令后该变量设置为true。运动员线程查看该变量,当为ture就跑,并run_count++,裁判员查看该run_count变量是否为8,记时。

1.2.2.2 线程调度

- 一个线程想要从就绪状态变成运行状态,这个过程需要系统调度,即给线程分配CPU的使用权,获得CPU使用权的线程才会从就绪状态变成运行状态。

- 协同式调度(自己工作完了,把CPU交给其他的线程)

- 抢占式调度(java默认模型)

- 线程调度的时候保存的上下文是什么:TCB

1.2.2.3 创建线程的多种方式

-

继承Thread类创建线程

SubClassThread subClassThread = new SubClassThread(); subClassThread.start(); class SubClassThread extends Thread { @Override public void run() { System.out.println(); } } - 实现Runnable接口创建线程

-

二者之间的区别是,一旦java是单继承的,所以最好使用Runnable

-

二者共同的缺点是:在执行完任务之后无法获取执行结果。

-

RunnableThread runnableThread = new RunnableThread(); new Thread(runnableThread).start(); class RunnableThread implements Runnable { @Override public void run() { System.out.println(Thread.currentThread().getName()); } }

-

-

通过Callable和FutureTask创建线程,可以在执行完任务之后获取执行结果。

CallableThread callableThread = new CallableThread(); FutureTask futureTask = new FutureTask<>(callableThread); new Thread(futureTask).start(); System.out.println(futureTask.get()); class CallableThread implements Callable { @Override public Object call() throws Exception { System.out.println(Thread.currentThread().getName()); return "Hollis"; } } -

通过线程池创建线程。

ExecutorService executorService = new ThreadPoolExecutor(1, 1, 60L, TimeUnit.SECONDS, new ArrayBlockingQueue<Runnable>(10)); executorService.execute(new Runnable() { @Override public void run() { System.out.println(Thread.currentThread().getName()); } });

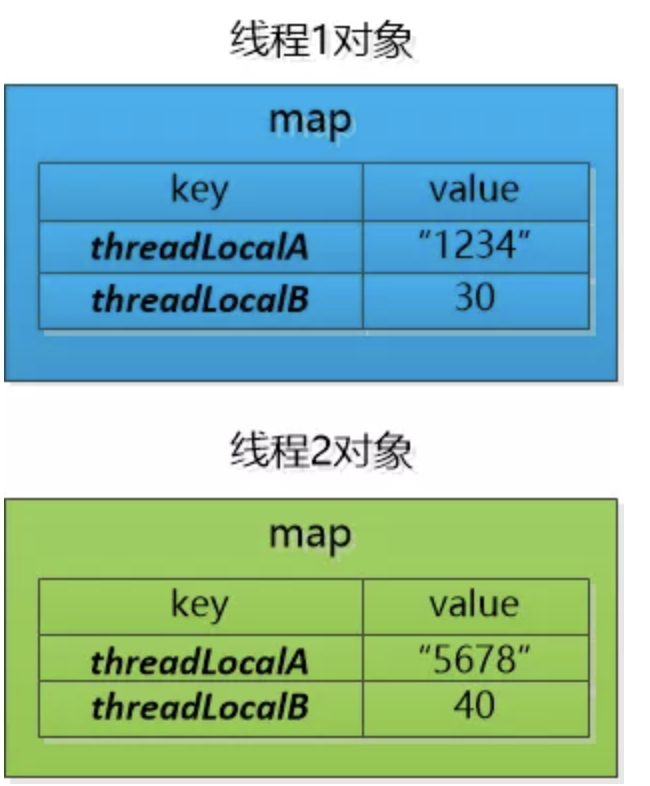

1.1.2.4 ThreadLocal

-

通过为每一个线程创建一份共享变量的副本来保证各个线程之间的变量的访问和修改互相不影响;

-

ThreadLocal 适用于每个线程需要自己独立的实例且该实例需要在多个方法中被使用,也即变量在线程间隔离而在方法或类间共享的场景。局部变量没有此问题。

-

每个线程可能有多个ThreadLocal。每个线程持有一个 Map 并维护了 ThreadLocal 对象与具体实例的映射,该 Map 由于只被持有它的线程访问,故不存在线程安全以及锁的问题。但是可能存在内存泄露的问题。

实例:Spring使用ThreadLocal来实现事务隔离;

1.1.2.5 线程池 @@@@@

- 池化技术:提前保存大量的资源。线程池提供了一种限制和管理资源。

- 线程池、连接池、内存池、对象池等。

- 降低资源消耗。 通过重复利用已创建的线程降低线程创建和销毁造成的消耗。

- 提高响应速度。 当任务到达时,任务可以不需要的等到线程创建就能立即执行。

- 提高线程的可管理性。 线程是稀缺资源,如果无限制的创建,不仅会消耗系统资源,还会降低系统的稳定性, 使用线程池可以进行统一的分配,调优和监控。

- 复用原理:线程池中的线程在死循环中尝试取任务执行,这一步会被阻塞。

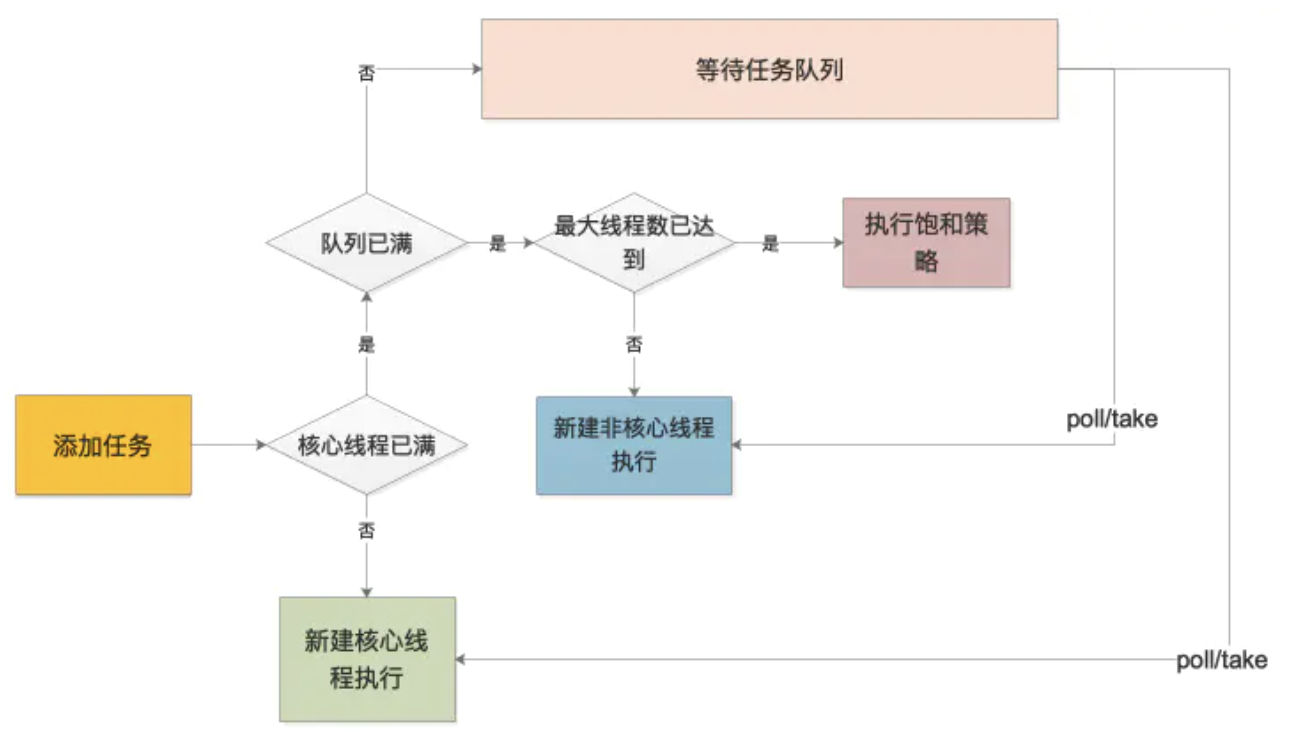

- 线程池原理

- 首先检测线程池运行状态,如果不是RUNNING,则直接拒绝,线程池要保证在RUNNING的状态下执行任务。

- 如果workerCount < corePoolSize,则创建并启动一个线程来执行新提交的任务。addWorker创建线程,workQueue.offer(command)任务添加到阻塞队列

- 如果workerCount >= corePoolSize,且线程池内的阻塞队列未满,则将任务添加到该阻塞队列中。

- 如果workerCount >= corePoolSize && workerCount < maximumPoolSize,且线程池内的阻塞队列已满,则创建并启动一个线程来执行新提交的任务。

- 如果workerCount >= maximumPoolSize,并且线程池内的阻塞队列已满, 则根据拒绝策略来处理该任务, 默认的处理方式是直接抛异常。

- HashSet

workers:维护所有的线程 - ThreadPoolExecutor

- corePoolSize: 核心线程数量,取任务是阻塞的take。普通线程是poll,取不到就退出了。

- cpu密集型(加密):CPU核心数+1。偶尔内存页失效或阻塞时,CPU的时钟周期也不会被浪费;

- IO密集型:CPU核心数 × (1+IO耗时/CPU耗时)

- workQueue:多余任务等待队列;

- maximumPoolSize: 最大的线程数量。

- keepAliveTime:非核心线程空闲时间。

- threadFactory: 创建线程的工厂,在这个地方可以统一处理创建的线程的属性。

- handler:线程池拒绝策略。

- corePoolSize: 核心线程数量,取任务是阻塞的take。普通线程是poll,取不到就退出了。

- 首先检测线程池运行状态,如果不是RUNNING,则直接拒绝,线程池要保证在RUNNING的状态下执行任务。

-

实现Runnable接口和Callable接口的区别:两者的区别在于 Runnable 接口不会返回结果不抛出异常但是 Callable 接口可以返回结果。

- execute和submit的区别:后者可以通过future.get拿到线程的返回值,但该方法是阻塞的。

创建线程池的方式:

- Executors工具类:可以创建FixedThreadPool,SingleThreadExecutor,CachedThreadPool的线程池;前两个允许的队列长度是Integer.MAX_VALUE,导致OOM,后者允许线程的数量是Integer.MAX_VALUE,导致OOM。

- ThreadPoolExecutor:这个是在工程中常见的。

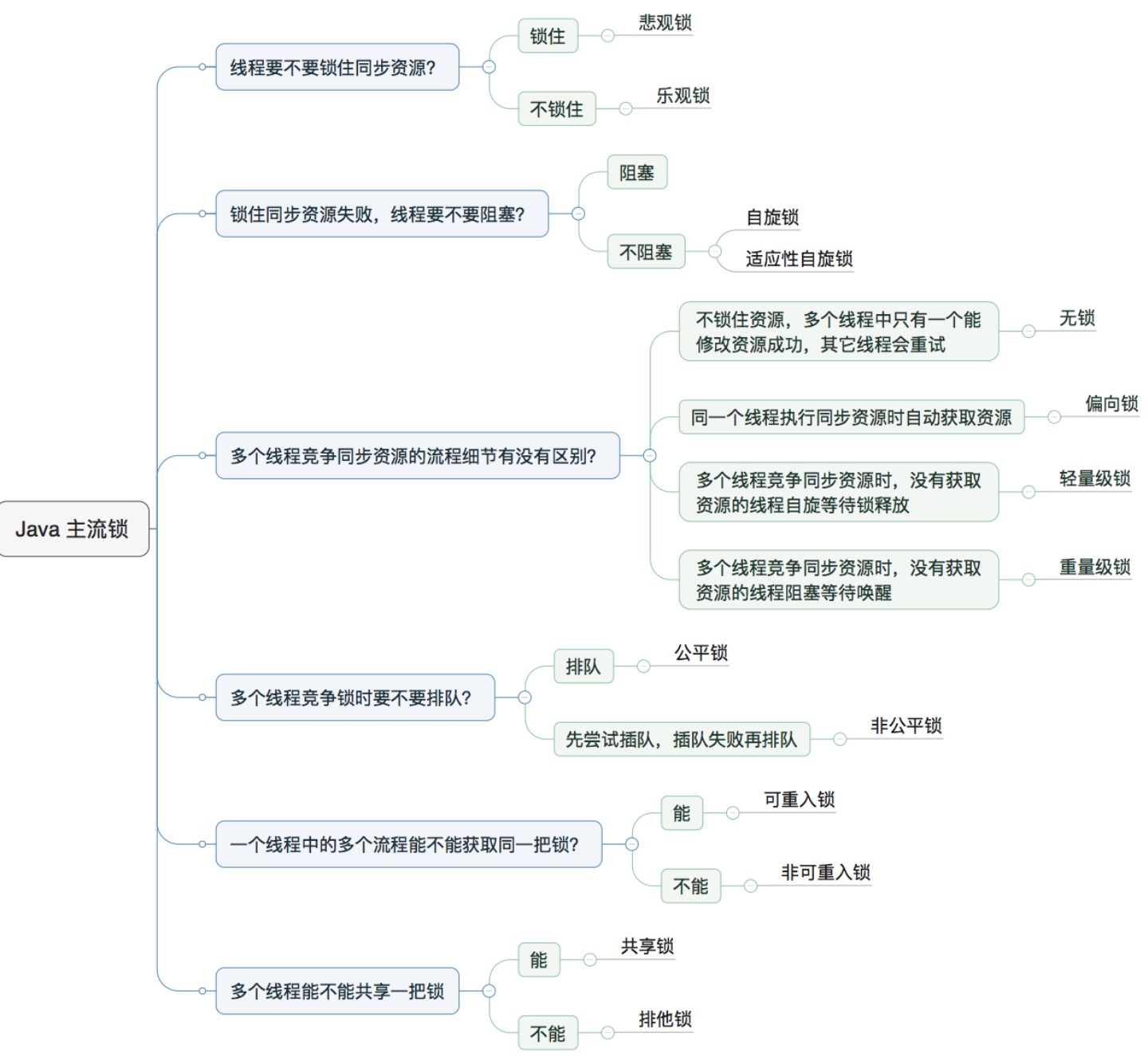

1.1.2.6 锁 @@@@@

-

-

乐观锁与悲观锁:线程要不要锁住同步资源

- 悲观锁是一定使用了锁机制的(适合写操作多),共享资源每次只给一个线程使用,其它线程阻塞,用完后再把资源转让给其它线程。乐观锁则并未真正加锁(适合读操作多)。实现方式有版本号和CAS。

- 版本号

- 一般是在数据表中加上一个数据版本号version字段,表示数据被修改的次数,当数据被修改时,version值会加一。当线程A要更新数据值时,在读取数据的同时也会读取version值,在提交更新时,若刚才读取到的version值为当前数据库中的version值相等时才更新,否则重试更新操作,直到更新成功。

- CAS

- Compare and Swap(

CAS)- 需要读写的内存值 V。进行比较的值 A。要写入的新值 B。

- 当且仅当 V 的值等于 A 时,CAS通过原子方式用新值B来更新V的值(“比较+更新”整体是一个原子操作),否则不会执行任何操作。一般情况下,“更新”是一个不断重试的操作。

- 存在ABA问题,循环时间长开销大,只能保证一个共享变量的原子操作

- 使用版本号来解决

- JDK 1.5 以后的

AtomicStampedReference 类就提供了此种能力,其中的compareAndSet 方法就是首先检查当前引用是否等于预期引用,并且当前标志是否等于预期标志,如果全部相等,则以原子方式将该引用和该标志的值设置为给定的更新值。

- 循环时间长开销大。CAS操作如果长时间不成功,会导致其一直自旋,给CPU带来非常大的开销。

- 只能保证一个共享变量的原子操作。1.5之后,可以使用AtomicReference。

- Compare and Swap(

-

阻塞锁vs非阻塞锁:锁住同步资源失败,线程要不要阻塞

- 到底要不要放弃处理器的执行时间。阻塞锁是放弃了CPU时间,进入了等待区,等待被唤醒。而自旋锁是一直“自旋”在那里,时刻的检查共享资源是否可以被访问(多个CPU),基于CAS,适用锁被占用时间短的情况。

-

无锁vs偏向锁vs轻量级锁vs重量级锁:对性能影响的大小,多个线程竞争同步资源的细节

- 无锁:没有对资源进行锁定,所有的线程都能访问并修改同一个资源,但同时只有一个线程能修改成功。CAS

- 偏向锁:一段同步代码一直被一个线程所访问,那么该线程会自动获取锁,降低获取锁的代价。当一个线程访问同步代码块并获取锁时,会在Mark Word里存储锁偏向的线程ID。在线程进入和退出同步块时不再通过CAS操作来加锁和解锁,而是检测Mark Word里是否存储着指向当前线程的偏向锁。引入偏向锁是为了在无多线程竞争的情况下尽量减少不必要的轻量级锁执行路径,因为轻量级锁的获取及释放依赖多次CAS原子指令,而偏向锁只需要在置换ThreadID的时候依赖一次CAS原子指令即可。

- 轻量级锁:当锁是偏向锁的时候,被另外的线程所访问,偏向锁就会升级为轻量级锁,其他线程会通过自旋的形式尝试获取锁,不会阻塞,从而提高性能。若当前只有一个等待线程,则该线程通过自旋进行等待。但是当自旋超过一定的次数,或者一个线程在持有锁,一个在自旋,又有第三个来访时,轻量级锁升级为重量级锁。

- 重量级锁:使用

Monitor进行加锁,这是一种互斥锁,称做重量级锁。

偏向锁通过对比Mark Word解决加锁问题,避免执行CAS操作。而轻量级锁是通过用CAS操作和自旋来解决加锁问题,避免线程阻塞和唤醒而影响性能。重量级锁是将除了拥有锁的线程以外的线程都阻塞。

-

锁状态 存储内容 存储内容 无锁 对象的hashCode、对象分代年龄、是否是偏向锁(0) 01 偏向锁 偏向线程ID、偏向时间戳、对象分代年龄、是否是偏向锁(1) 01 轻量级锁 指向栈中锁记录的指针 00 重量级锁 指向互斥量(重量级锁)的指针 10

-

- 可重入锁又名递归锁,是指在同一个线程在外层方法获取锁的时候,再进入该线程的内层方法会自动获取锁,不会因为之前已经获取过还没释放而阻塞,可以避免死锁。

-

锁消除:即无锁。

-

锁粗化:锁变大。

-

- 死锁如何排查:jps获取进程id,Jstack获取线程栈:区分线程状态 -> 查看等待目标 -> 对比Monitor等持有状态。

- JConsole工具

- 死锁的原因:资源竞争

- 互斥条件:进程要求对所分配的资源进行排它性控制,即在一段时间内某资源仅为一进程所占用。

- 请求和保持条件:当进程因请求资源而阻塞时,对已获得的资源保持不放。

- 不剥夺条件:进程已获得的资源在未使用完之前,不能剥夺,只能在使用完时由自己释放。

- 环路等待条件:在发生死锁时,必然存在一个进程–资源的环形链。

- 死锁的解决办法

- 确定的顺序获取锁

- 死锁检测与死锁恢复:不不试图阻⽌止死锁,⽽而是检测到死锁发⽣生时,采取措施进恢复。

- 死锁如何排查:jps获取进程id,Jstack获取线程栈:区分线程状态 -> 查看等待目标 -> 对比Monitor等持有状态。

1.1.2.7 synchronized @@@@@

synchronized是悲观锁,在操作同步资源之前需要给同步资源先加锁,这把锁就是存在Java对象头里的,Hotspot的对象头主要包括两部分数据:Mark Word(标记字段)、Klass Pointer(类型指针)。

Mark Word:默认存储对象的HashCode,分代年龄和锁标志位信息。这些信息都是与对象自身定义无关的数据,所以Mark Word被设计成一个非固定的数据结构以便在极小的空间内存存储尽量多的数据。它会根据对象的状态复用自己的存储空间,也就是说在运行期间Mark Word里存储的数据会随着锁标志位的变化而变化。

Klass Point:对象指向它的类元数据的指针,虚拟机通过这个指针来确定这个对象是哪个类的实例。

Monitor可以理解为一个同步工具,通常被描述为一个对象。每一个Java对象就有一把看不见的锁,称为Monitor锁。Monitor是线程私有的数据结构,每一个线程都有一个可用monitor record列表,同时还有一个全局的可用列表。每一个被锁住的对象都会和一个monitor关联,同时monitor中有一个Owner字段存放拥有该锁的线程的唯一标识,表示该锁被这个线程占用。

synchronized通过Monitor来实现线程同步,Monitor是依赖于底层的操作系统的Mutex Lock(互斥锁)来实现的线程同步。如果要挂起或者唤醒一个线程, 都需要操作系统帮忙完成,而操作系统实现线程之间的切换时需要从用户态转换到内核态,这个状态之间的转换需要相对比较长的时间,时间成本相对较高。

synchronized关键字最主要的三种使用方式:

- 修饰方法,(实例方法:给当前对象实例加锁,静态方法:当前类对象加锁) ,通过ACC_SYNCHRONIZED标识,线程需要先获取监视器锁,在执行,执行完成会释放,发生异常也会释放;

- 修饰代码块,(通过monitorenter 和 monitorexit 指令)。 当执行 monitorenter 指令时,线程试图获取 monitor的持有权.当计数器为0则可以成功获取,获取后将锁计数器设 为1也就是加1。相应的在执行 monitorexit 指令后,将锁计数器设为0,表明锁被释放。如果获取对象锁失败,那当前线程就要阻塞等待,直到锁被另外一个线程释放为止。

原子性:通过monitorenter和monitorexit指令,可以保证被synchronized修饰的代码在同一时间只能被一个线程访问;

可见性:对一个变量解锁之前,必须先把此变量同步回主存中。这样解锁后,后续线程就可以访问到被修改后的值;即happens-before原则。

有序性:as-if-serial语义(需要满足happens-before原则)。保证的是多个线程之间的有序性,即被加锁的内容要按照顺序被多个线程执行。但是其内部的同步代码还是会发生重排序,由于编译器和处理器都遵循as-if-serial语义,对于单线程无影响,会影响其他的线程。

java 1.6之后对锁的优化

JDK1.6 对锁的实现引入了大量的优化,如偏向锁、轻量级锁、自旋锁、适应性自旋锁、锁消除、锁粗化等技术来减少锁操作的开销。

锁主要存在四中状态,依次是:无锁状态、偏向锁状态、轻量级锁状态、重量级锁状态,他们会随着竞争的激烈而逐渐升级。注意锁可以升级不可降级,这种策略是为了提高获得锁和释放锁的效率。

-

无锁:没有对资源进行锁定,所有的线程都能访问并修改同一个资源,但同时只有一个线程能修改成功。

-

偏向锁:一段同步代码一直被一个线程所访问,那么该线程会自动获取锁,降低获取锁的代价。在无竞争的情况下会把整个同步都消除掉。

-

轻量级锁:当锁是偏向锁的时候,被另外的线程所访问,偏向锁就会升级为轻量级锁,其他线程会通过自旋的形式尝试获取锁,不会阻塞,从而提高性能。轻量级锁在无竞争的情况下使用 CAS 操作去代替使用互斥量。

-

重量级锁:使用

Monitor进行加锁,这是一种互斥锁,称做重量级锁。

轻量级锁失败后,虚拟机为了避免线程真实地在操作系统层面挂起,还会进行一项称为自旋锁的优化手段。

互斥同步对性能最大的影响就是阻塞的实现,因为挂起线程/恢复线程的操作都需要转入内核态中完成(用户态转换到内核态会耗费时间)。

一般线程持有锁的时间都不是太长,所以仅仅为了这一点时间去挂起线程/恢复线程是得不偿失的。 所以,虚拟机的开发团队就这样去考虑:“我们能不能让后面来的请求获取锁的线程等待一会而不被挂起呢?看看持有锁的线程是否很快就会释放锁”。为了让一个线程等待,我们只需要让线程执行一个忙循环(自旋),这项技术就叫做自旋。

在 JDK1.6 中引入了自适应的自旋锁。自适应的自旋锁带来的改进就是:自旋的时间不在固定了,而是和前一次同一个锁上的自旋时间以及锁的拥有者的状态来决定,虚拟机变得越来越“聪明”了。

锁消除理解起来很简单,它指的就是虚拟机即使编译器在运行时,如果检测到那些共享数据不可能存在竞争,那么就执行锁消除。锁消除可以节省毫无意义的请求锁的时间。我们在编写代码的时候,总是推荐将同步快的作用范围限制得尽量小,但是如果一系列的连续操作都对同一个对象反复加锁和解锁,那么会带来很多不必要的性能消耗。

synchronized和ReenTrantLock 的区别

-

两者都是可重入锁

-

synchronized 依赖于 JVM 而 ReenTrantLock 依赖于 API

synchronized 是依赖于 JVM 实现的。ReenTrantLock 是 JDK 层面实现的(需要 lock() 和 unlock 方法配合 try/finally 语句块来完成)。

- ReenTrantLock 比 synchronized 增加了一些高级功能

- 等待可中断。ReenTrantLock提供了一种能够中断等待锁的线程的机制,通过lock.lockInterruptibly()来实现这个机制。也 就是说正在等待的线程可以选择放弃等待,改为处理其他事情。

- ReenTrantLock可以指定是公平锁还是非公平锁。而synchronized只能是非公平锁。所谓的公平锁就是先等 待的线程先获得锁。 ReenTrantLock默认情况是非公平的,可以通过 ReenTrantLock类的

- 可实现选择性通知。synchronized关键字与wait()和notify/notifyAll()方法相结合可以实现等待/通知机制,ReentrantLock类当然也可以实现,但是需要借助于Condition接口与newCondition() 方法。Condition是JDK1.5之后才有的,它具有很好的灵活性,比如可以实现多路通知功能也就是在一个Lock对象中可以创建多个Condition实例(即对象监视器),线程对象可以注册在指定的Condition中,从而可以有选择性的进行线程通知,在调度线程上更加灵活。 在使用notify/notifyAll()方法进行通知时,被通知的线程是由 JVM 选择的,用ReentrantLock类结合Condition实例可以实现“选择性通知” ,这个功能非常重要,而且是Condition接口默认提供的。而synchronized关键字就相当于整个Lock对象中只有一个Condition实例,所有的线程都注册在它一个身上。如果执行notifyAll()方法的话就会通知所有处于等待状态的线程这样会造成很大的效率问题,而Condition实例的signalAll()方法 只会唤醒注册在该Condition实例中的所有等待线程。

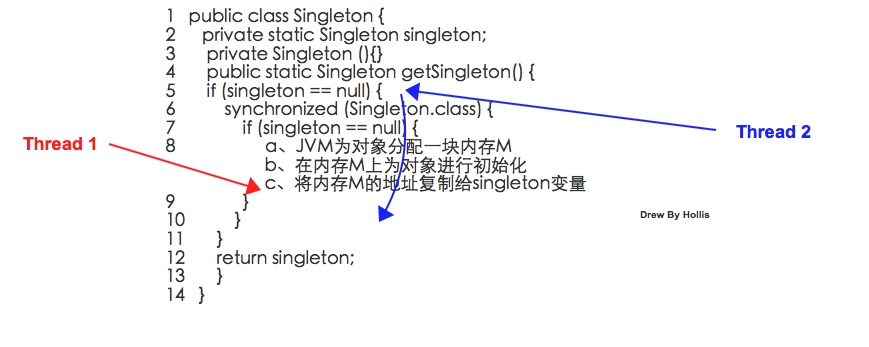

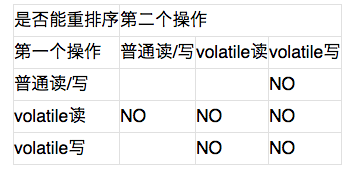

1.1.2.8 volatile

volatile:保证有序性,可见性,无法保证原子性,且只可以修饰变量。

指令重排的例子,双重校验锁实现单例,abc可能会被优化为acb,从而导致NPE的问题:

有序性:禁止指令重排。在编译期生成字节码时,会在指令序列中增加内存屏障来保证。

当第二个操作是volatile写时,不管第一个操作是什么,都不能重排序。这个规则确保volatile写之前的操作不会被编译器重排序到volatile写之后。

当第一个操作是volatile读时,不管第二个操作是什么,都不能重排序。这个规则确保volatile读之后的操作不会被编译器重排序到volatile读之前。

当第一个操作是volatile写,第二个操作是volatile读时,不能重排序。

- 有了symchronized为什么还需要volatile:有性能损耗;产生阻塞;可以禁止指令重排

1.1.2.9 写代码来解决生产者消费者问题(实现线程的顺序打印)@@@@@

// 实现线程的顺序打印

public class Test implements Runnable {

private static final Object LOCK = new Object();

/**

* 当前即将打印的数字

*/

private static int current = 0;

/**

* 当前线程编号,从0开始

*/

private int threadNo;

/**

* 线程数量

*/

private int threadCount;

/**

* 打印的最大数值

*/

private int max;

public Test(int threadNo, int threadCount, int max) {

this.threadNo = threadNo;

this.threadCount = threadCount;

this.max = max;

}

@Override

public void run() {

while (true) {

synchronized (LOCK) {

// 判断是否轮到当前线程执行

while (current % threadCount != threadNo) {

if (current > max) {

break;

}

try {

// 如果不是,则当前线程进入wait

LOCK.wait();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

// 最大值跳出循环

if (current > max) {

break;

}

System.out.println("thread-" + threadNo + " : " + current);

current++;

// 唤醒其他wait线程

LOCK.notifyAll();

}

}

}

public static void main(String[] args) {

int threadCount = 3;

int max = 2;

for (int i = 0; i < threadCount; i++) {

new Thread(new Test(i, threadCount, max)).start();

}

}

}

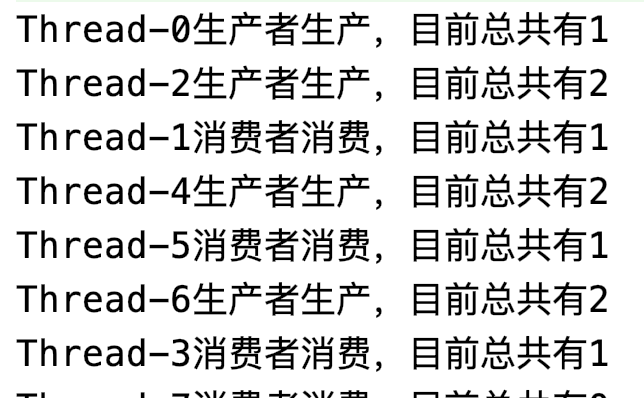

// 生产者和消费者,wait()和notify()的实现

// wait(),暂停线程的执行。注意:sleep方法没有释放锁,而wait方法释放了锁 。timeout是等待时间。

// notify(),唤醒一个在此对象监视器上等待的线程(监视器相当于就是锁的概念)。

// 如果有多个线程在等待只会任意唤醒一个。

// notifyAll(),跟notify一样,唯一的区别就是会唤醒 在此对象监视器上等待的所有线程,而不是一个线程。

public class Test1 {

private static Integer count = 0;

private static final Integer FULL = 10;

private static String LOCK = "lock";

public static void main(String[] args) {

Test1 test1 = new Test1();

new Thread(test1.new Producer()).start();

new Thread(test1.new Consumer()).start();

new Thread(test1.new Producer()).start();

new Thread(test1.new Consumer()).start();

new Thread(test1.new Producer()).start();

new Thread(test1.new Consumer()).start();

new Thread(test1.new Producer()).start();

new Thread(test1.new Consumer()).start();

}

class Producer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (Exception e) {

e.printStackTrace();

}

synchronized (LOCK) {

while (count.equals(FULL)) {

try {

LOCK.wait();

} catch (Exception e) {

e.printStackTrace();

}

}

count++;

System.out.println(Thread.currentThread().getName() + "生产者生产,目前总共有" + count);

LOCK.notifyAll();

}

}

}

}

class Consumer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

synchronized (LOCK) {

while (count == 0) {

try {

LOCK.wait();

} catch (Exception e) {

}

}

count--;

System.out.println(Thread.currentThread().getName() + "消费者消费,目前总共有" + count);

LOCK.notifyAll();

}

}

}

}

}

为什么使用notifyAll() ,不使用notify(),就是随便叫醒一个消费者呢?

使用 notify() 是叫醒 LOCK 阻塞队列里面的任意一个线程,假如此时我们的临界区域已经满了,此时唤醒的是一个生产者线程,就会导致死锁,所以我们在这里采用的是 notifyAll() 这个方法,意思就是唤醒阻塞队列里面的全部线程,这样某一个消费者就可以去取出临界区里面的产品,从而避免死锁的发生。

// 生产者和消费者,可重入锁ReentrantLock的实现

public class Test1 {

private static Integer count = 0;

private static final Integer FULL = 10;

//创建一个锁对象

private Lock lock = new ReentrantLock();

//创建两个条件变量,一个为缓冲区非满,一个为缓冲区非空

private final Condition notFull = lock.newCondition();

private final Condition notEmpty = lock.newCondition();

public static void main(String[] args) {

Test1 test2 = new Test1();

new Thread(test2.new Producer()).start();

new Thread(test2.new Consumer()).start();

new Thread(test2.new Producer()).start();

new Thread(test2.new Consumer()).start();

new Thread(test2.new Producer()).start();

new Thread(test2.new Consumer()).start();

new Thread(test2.new Producer()).start();

new Thread(test2.new Consumer()).start();

}

class Producer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (Exception e) {

e.printStackTrace();

}

//获取锁

lock.lock();

try {

while (count.equals(FULL)) {

try {

notFull.await();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

count++;

System.out.println(Thread.currentThread().getName()

+ "生产者生产,目前总共有" + count);

//唤醒消费者

notEmpty.signal();

} finally {

//释放锁

lock.unlock();

}

}

}

}

class Consumer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (InterruptedException e1) {

e1.printStackTrace();

}

lock.lock();

try {

while (count == 0) {

try {

notEmpty.await();

} catch (Exception e) {

e.printStackTrace();

}

}

count--;

System.out.println(Thread.currentThread().getName()

+ "消费者消费,目前总共有" + count);

notFull.signal();

} finally {

lock.unlock();

}

}

}

}

}

阻塞队列BlockingQueue的实现

BlockingQueue即阻塞队列,被阻塞的情况主要有如下两种:

- 当队列满了的时候进行入队列操作

- 当队列空了的时候进行出队列操作 因此,当一个线程对已经满了的阻塞队列进行入队操作时会阻塞,除非有另外一个线程进行了出队操作,当一个线程对一个空的阻塞队列进行出队操作时也会阻塞,除非有另外一个线程进行了入队操作。从上可知,阻塞队列是线程安全的。

下面来看由阻塞队列实现的生产者消费者模型,这里我们使用take()和put()方法,这里生产者和生产者,消费者和消费者之间不存在同步,所以会出现连续生成和连续消费的现象

// 生产者和消费者,使用BlockingQueue实现生产者消费者模型

public class Test1 {

private static Integer count = 0;

//创建一个阻塞队列

final BlockingQueue blockingQueue = new ArrayBlockingQueue<>(10);

public static void main(String[] args) {

Test1 test3 = new Test1();

new Thread(test3.new Producer()).start();

new Thread(test3.new Consumer()).start();

new Thread(test3.new Producer()).start();

new Thread(test3.new Consumer()).start();

new Thread(test3.new Producer()).start();

new Thread(test3.new Consumer()).start();

new Thread(test3.new Producer()).start();

new Thread(test3.new Consumer()).start();

}

class Producer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (Exception e) {

e.printStackTrace();

}

try {

blockingQueue.put(1);

count++;

System.out.println(Thread.currentThread().getName()

+ "生产者生产,目前总共有" + count);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

class Consumer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (InterruptedException e1) {

e1.printStackTrace();

}

try {

blockingQueue.take();

count--;

System.out.println(Thread.currentThread().getName()

+ "消费者消费,目前总共有" + count);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

}

信号量Semaphore的实现

Semaphore是用来控制同时访问特定资源的线程数量,它通过协调各个线程,以保证合理的使用公共资源,在操作系统中是一个非常重要的问题。Java中的Semaphore维护了一个许可集,一开始先设定这个许可集的数量,可以使用acquire()方法获得一个许可,当许可不足时会被阻塞,release()添加一个许可。在下列代码中,还加入了另外一个mutex信号量,维护生产者消费者之间的同步关系,保证生产者和消费者之间的交替进行。

// 生产者和消费者,使用semaphore信号量实现

public class Test1 {

private static Integer count = 0;

//创建三个信号量

final Semaphore notFull = new Semaphore(10);

final Semaphore notEmpty = new Semaphore(0);

final Semaphore mutex = new Semaphore(1);

public static void main(String[] args) {

Test1 test4 = new Test1();

new Thread(test4.new Producer()).start();

new Thread(test4.new Consumer()).start();

new Thread(test4.new Producer()).start();

new Thread(test4.new Consumer()).start();

new Thread(test4.new Producer()).start();

new Thread(test4.new Consumer()).start();

new Thread(test4.new Producer()).start();

new Thread(test4.new Consumer()).start();

}

class Producer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

try {

notFull.acquire();

mutex.acquire();

count++;

System.out.println(Thread.currentThread().getName()

+ "生产者生产,目前总共有" + count);

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

mutex.release();

notEmpty.release();

}

}

}

}

class Consumer implements Runnable {

@Override

public void run() {

for (int i = 0; i < 10; i++) {

try {

Thread.sleep(3000);

} catch (InterruptedException e1) {

e1.printStackTrace();

}

try {

notEmpty.acquire();

mutex.acquire();

count--;

System.out.println(Thread.currentThread().getName()

+ "消费者消费,目前总共有" + count);

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

mutex.release();

notFull.release();

}

}

}

}

}

消息队列:

public class MessageQueue {

private int capacity = 10;

private Queue<Integer> mq = new LinkedList<>();

public MessageQueue(int cap) {

this.capacity = cap;

}

public synchronized void push(Integer val) {

while (mq.size() == capacity) {

try {

wait();

} catch (InterruptedException e) {

}

}

System.out.println("当前数量: " + mq.size());

mq.offer(val);

notifyAll();

}

public synchronized Integer pop() {

while (mq.size() == 0) {

try {

wait();

} catch (InterruptedException e) {

}

}

Integer val = mq.poll();

notifyAll();

return val;

}

public static void main(String[] args) {

MessageQueue mq = new MessageQueue(15);

Customer c = new Customer(mq);

Producer p = new Producer(mq);

Thread t1 = new Thread(c);

Thread t2 = new Thread(c);

Thread t3 = new Thread(c);

Thread t4 = new Thread(p);

Thread t5 = new Thread(p);

Thread t6 = new Thread(p);

t1.start();

t2.start();

t3.start();

t4.start();

t5.start();

t6.start();

}

}

class Producer implements Runnable {

private MessageQueue mq;

Producer(MessageQueue mq) {

this.mq = mq;

}

public void run() {

for(int i = 0; i <= 100; i++) {

mq.push(i);

System.out.println("生产者 " + Thread.currentThread().getId() + " 加入值: " + i);

try {

Thread.sleep(1000);

} catch (Exception e) {

}

}

}

}

class Customer implements Runnable {

private MessageQueue mq;

Customer(MessageQueue mq) {

this.mq = mq;

}

public void run() {

while(true) {

int val = mq.pop();

System.out.println("消费者 " + Thread.currentThread().getId() + " 消费值: " + val);

try {

Thread.sleep(1000);

} catch (Exception e) {

}

}

}

}

1.2.2 并发包juc

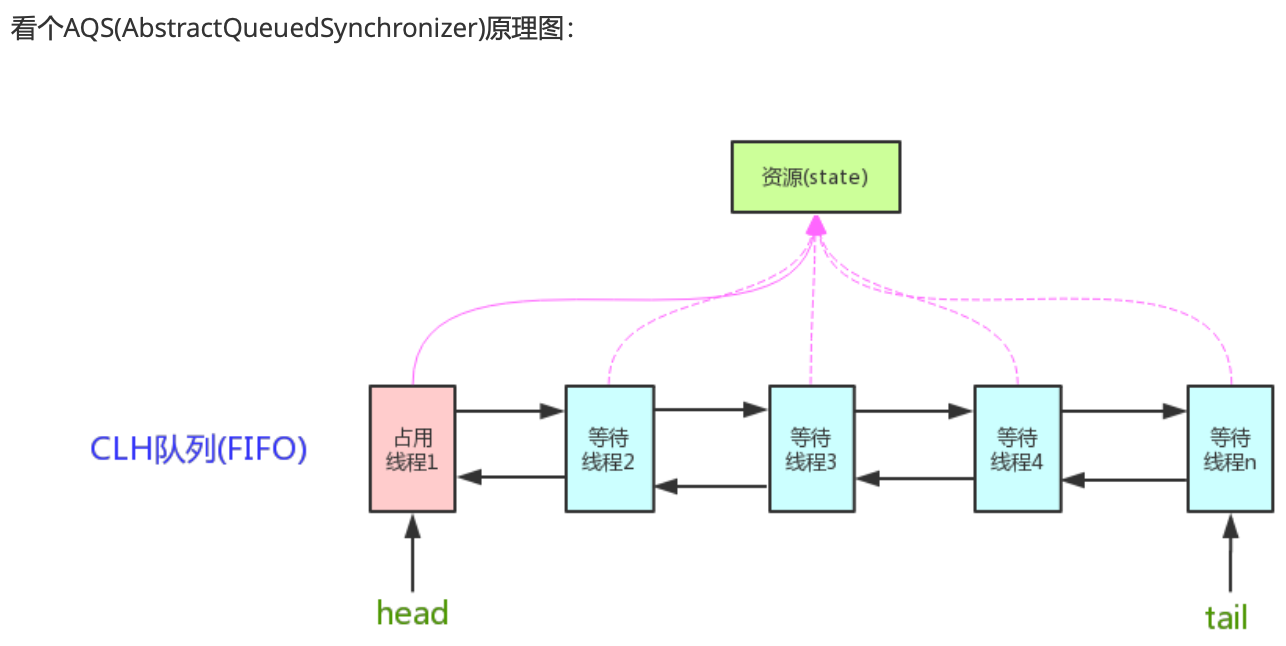

1.2.2.1 AQS @@@@@

AQS的全称为(AbstractQueuedSynchronizer)。AQS是一种提供了原子式管理同步状态、阻塞和唤醒线程功能以及队列模型的简单框架。

AQS核心思想是,如果被请求的共享资源空闲,则将当前请求资源的线程设置为有效的工作线程,并且将共享资源设置为锁定状态。如果被请求的共享资源被占用,那么就需要一套线程阻塞等待以及被唤醒时锁分配的机制,这个机制 AQS是用CLH队列(虚拟双向队列)锁实现的,即将暂时获取不到锁的线程加入到队列中。

AQS使用一个int成员变量来表示同步状态,通过内置的FIFO队列来完成获取资源线程的排队工作。AQS 使用CAS对该同步状态进行原子操作实现对其值的修改(CAS)。

资源共享方式分为:

Exclusive(独占锁):只有一个线程能执行,如ReentrantLock。又可分为公平锁和非公平锁: 公平锁:按照线程在队列中的排队顺序,先到者先拿到锁非公平锁:当线程要获取锁时,无视队列顺序直接去抢锁,谁抢到就是谁的;

独占式获取同步状态:

- 调用 tryAcquire 方法尝试获取同步状态

- 获取成功,直接返回

- 获取失败,将线程封装到节点中,并将节点入队

- 入队节点在 acquireQueued 方法中自旋获取同步状态

- 若节点的前驱节点是头节点,则再次调用 tryAcquire 尝试获取同步状态

- 获取成功,当前节点将自己设为头节点并返回

- 获取失败,可能再次尝试,也可能会被阻塞。这里简单认为会被阻塞。

独占式释放同步状态:

- 调用 tryRelease(arg) 尝试释放同步状态

- 根据条件判断是否应该唤醒后继线程

Share(共享锁):多个线程可同时执行,如Semaphore/CountDownLatch。Semaphore、 CountDownLatch、 CyclicBarrier、ReadWriteLock 我们都会在后面讲到;

共享式获取同步状态:

- 获取共享同步状态

- 若获取失败,则生成节点,并入队

- 如果前驱为头结点,再次尝试获取共享同步状态

- 获取成功则将自己设为头结点,如果后继节点是共享类型的,则唤醒

- 若失败,将节点状态设为 SIGNAL,再次尝试。若再次失败,线程进入等待状态

Condition 实现原理:

ReentrantReadWriteLock 可以看成是组合式,因为ReentrantReadWriteLock也就是读写锁允许多个线 程同时对某一资源进行读。

以ReentrantLock为例,state初始化为0,表示未锁定状态。A线程lock()时,会调用tryAcquire()独占 该锁并将state+1。此后,其他线程再tryAcquire()时就会失败,直到A线程unlock()到state=0(即释 放锁)为止,其它线程才有机会获取该锁。当然,释放锁之前,A线程自己是可以重复获取此锁的 (state会累加),这就是可重入的概念。但要注意,获取多少次就要释放多么次,这样才能保证state 是能回到零态的。

再以CountDownLatch以例,任务分为N个子线程去执行,state也初始化为N(注意N要与线程个数一 致)。这N个子线程是并行执行的,每个子线程执行完后countDown()一次,state会CAS(Compare and Swap)减1。等到所有子线程都执行完后(即state=0),会unpark()主调用线程,然后主调用线程就会从 await()函数返回,继续后余动作。

AQS中的组件:

- Semaphore(信号量)-允许多个线程同时访问: synchronized 和 ReentrantLock 都是一次只允 许一个线程访问某个资源,Semaphore(信号量)可以指定多个线程同时访问某个资源。

- CountDownLatch (倒计时器): CountDownLatch是一个同步工具类,用来协调多个线程之间的 同步。这个工具通常用来控制线程等待,它可以让某一个线程等待直到倒计时结束,再开始执行。

- CyclicBarrier(循环栅栏): CyclicBarrier 和 CountDownLatch 非常类似,它也可以实现线程 间的技术等待,但是它的功能比 CountDownLatch 更加复杂和强大。主要应用场景和 CountDownLatch 类似。CyclicBarrier 的字面意思是可循环使用(Cyclic)的屏障 (Barrier)。它要做的事情是,让一组线程到达一个屏障(也可以叫同步点)时被阻塞,直到 最后一个线程到达屏障时,屏障才会开⻔,所有被屏障拦截的线程才会继续干活。 CyclicBarrier默认的构造方法是 CyclicBarrier(int parties),其参数表示屏障拦截的线程数 量,每个线程调用await()方法告诉 CyclicBarrier 我已经到达了屏障,然后当前线程被阻塞。

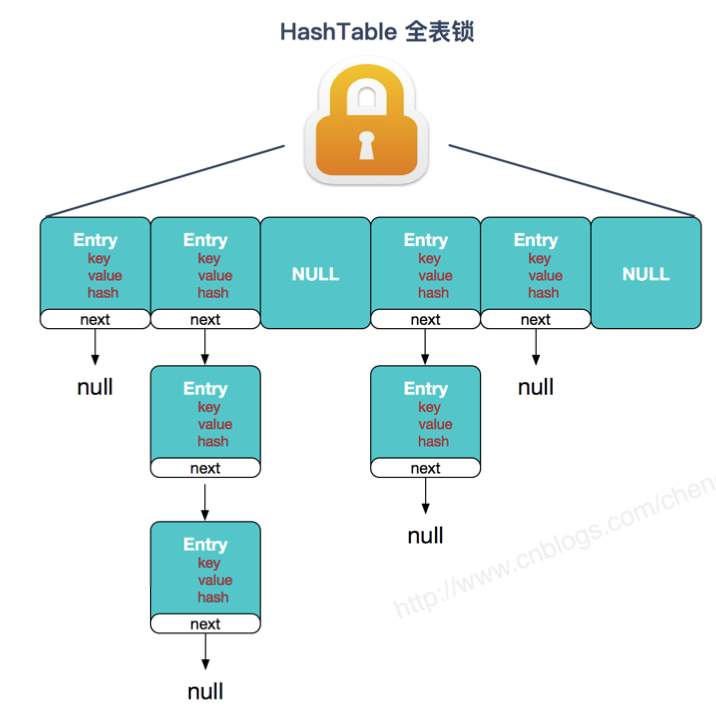

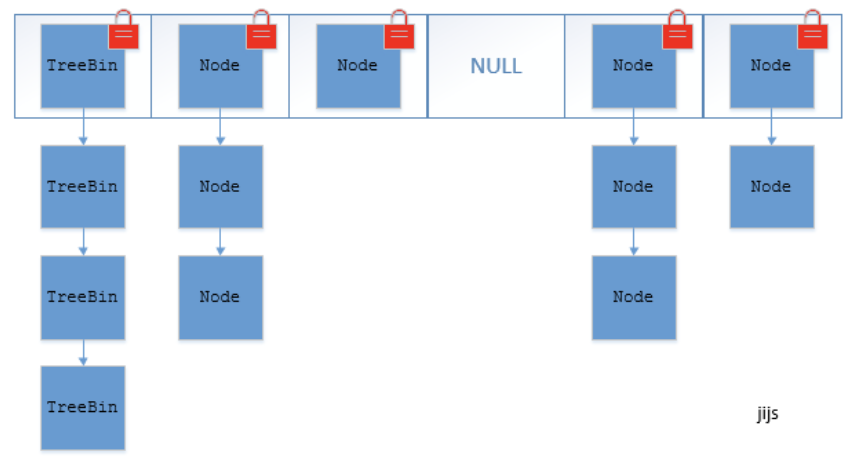

1.2.2.2 ConcurrentHashMap

jdk7分段来加锁,Segment默认是16,2的幂;jdk8取消了Segment分段锁,使用synchronized 和 CAS,只锁定当前链表或红黑二叉树的首节点。

Segment 实现了 ReentrantLock,所以 Segment 是一种可重入锁,扮演锁的⻆色。HashEntry 用于存储键值对数据。一个 ConcurrentHashMap 里包含一个 Segment 数组。Segment 的结构和HashMap类似,是一种数组和 链表结构,一个 Segment 包含一个 HashEntry 数组,每个 HashEntry 是一个链表结构的元素,每个 Segment 守护着一个HashEntry数组里的元素,当对 HashEntry 数组的数据进行修改时,必须首先获得 对应的 Segment的锁。

jdk1.8

1.2.2.3 ConcurrentLinkedQueue

结果的保存用到了ConcurrentLinkedQueue这个集合,是一个非阻塞,无锁,无界,线程安全的集合,采用了CAS。

ConcurrentLinkedQueue 由 head 节点和 tair 节点组成。入队:

- 第一是定位出尾节点。tail 节点并不总是尾节点,所以每次入队都必须先通过 tail 节点来找到尾节点,尾节点可能就是 tail 节点,也可能是 tail 节点的 next 节点。代码中循环体中的第一个 if 就是判断 tail 是否有 next 节点,有则表示 next 节点可能是尾节点。

- 第二是使用 CAS 算法能将入队节点设置成尾节点的 next 节点,如不成功则重试。

为了优化,加入了hops。

出队:首先获取头节点的元素,然后判断头节点元素是否为空,如果为空,表示另外一个线程已经进行了一次出队操作将该节点的元素取走,如果不为空,则使用 CAS 的方式将头节点的引用设置成 null,如果 CAS 成功,则直接返回头节点的元素,如果不成功,表示另外一个线程已经进行了一次出队操作更新了 head 节点,导致元素发生了变化,需要重新获取头节点。

1.2.2.4 LinkedBlockingQueue

使用到了LinkedBlockingQueue,是一个基于双向链表实现的双向并发阻塞队列,默认容量大小等于Integer.MAX_VALUE,也可以指定大小。头、尾操作使用不同的锁。

takeLock 和 notEmpty 怎么搭配:如果要获取(take)一个元素,需要获取 takeLock 锁,但是获取了锁还不够,如果队列此时为空,还需要队列不为空(notEmpty)这个条件(Condition)。会执行notEmpty.await()进行等待。当其它某个线程(线程B)向队列中插入了数据之后,会调用notEmpty.signal()唤醒“notEmpty上的等待线程”。此时,线程A会被唤醒从而得以继续运行。 此外,线程A在执行取操作前,会获取takeLock,在取操作执行完毕再释放takeLock。

putLock 需要和 notFull 搭配:如果要插入(put)一个元素,需要获取 putLock 锁,但是获取了锁还不够,如果队列此时已满,还需要队列不是满的(notFull)这个条件(Condition)。则该线程会它执行notFull.await()进行等待;当其它某个线程(线程I)取出数据之后,会调用notFull.signal()唤醒“notFull上的等待线程”。此时,线程H就会被唤醒从而得以继续运行。 此外,线程H在执行插入操作前,会获取putLock,在插入操作执行完毕才释放putLock。

使用到了可重入互斥锁ReentrantLock,Condition,Condition中的await()方法相当于Object的wait()方法,signal()方法相当于notify()方法,signalAll()相当于notifyAll()方法。

1.2.2.5 Atomic 原子类

Atomic 翻译成中文是原子的意思。即使是在多个线程一起执行的时候,一个操作一旦开始,就不会被其他线程干扰。所以,所谓原子类说简单点就是具有原子/原子操作特征的类。

-

JUC 包中的原子类是哪4类?

基本类型:使用原子的方式更新基本类型

AtomicInteger:整形原子类

AtomicLong:长整型原子类

AtomicBoolean :布尔型原子类

数组类型:使用原子的方式更新数组里的某个元素

- AtomicIntegerArray:整形数组原子类

- AtomicLongArray:长整形数组原子类

- AtomicReferenceArray :引用类型数组原子类

引用类型

- AtomicReference:引用类型原子类

- AtomicStampedRerence:原子更新引用类型里的字段原子类

- AtomicMarkableReference :原子更新带有标记位的引用类型

对象的属性修改类型

- AtomicIntegerFieldUpdater:原子更新整形字段的更新器

- AtomicLongFieldUpdater:原子更新长整形字段的更新器

- AtomicStampedReference :原子更新带有版本号的引用类型。该类将整数值与引用关联起来,可用于解决原 子的更新数据和数据的版本号,可以解决使用 CAS 进行原子更新时可能出现的 ABA 问题。

-

讲讲 AtomicInteger 的使用

AtomicInteger 类常用方法

public final int get() //获取当前的值 public final int getAndSet(int newValue)//获取当前的值,并设置新的值 public final int getAndIncrement()//获取当前的值,并自增 public final int getAndDecrement() //获取当前的值,并自减 public final int getAndAdd(int delta) //获取当前的值,并加上预期的值 boolean compareAndSet(int expect, int update) //如果输入的数值等于预期值,则以原子方式将该值设置为输 入值(update) public final void lazySet(int newValue)//最终设置为newValue,使用 lazySet 设置之后可能导致其他线程 在之后的一小段时间内还是可以读到旧的值。AtomicInteger 类的使用示例 使用 AtomicInteger 之后,不用对 increment() 方法加锁也可以保证线程安全。

class AtomicIntegerTest { private AtomicInteger count = new AtomicInteger(); //使用AtomicInteger之后,不需要对该方法加锁,也可以实现线程安全。 public void increment() { count.incrementAndGet(); } public int getCount() { return count.get(); } } -

能不能给我简单介绍一下 AtomicInteger 类的原理

AtomicInteger 线程安全原理简单分析 AtomicInteger 类的部分源码:

// setup to use Unsafe.compareAndSwapInt for updates(更新操作时提供“比较并替换”的作用) private static final Unsafe unsafe = Unsafe.getUnsafe(); private static final long valueOffset; static { try { valueOffset = unsafe.objectFieldOffset (AtomicInteger.class.getDeclaredField("value")); } catch (Exception ex) { throw new Error(ex); } } private volatile int value;AtomicInteger 类主要利用 CAS (compare and swap) + volatile 和 native 方法来保证原子操作,从而避免 synchronized 的高开销,执行效率大为提升。

CAS的原理是拿期望的值和原本的一个值作比较,如果相同则更新成新的值。UnSafe 类的 objectFieldOffset() 方法 是一个本地方法,这个方法是用来拿到“原来的值”的内存地址,返回值是 valueOffset。另外 value 是一个volatile变 量,在内存中可见,因此 JVM 可以保证任何时刻任何线程总能拿到该变量的最新值。

- executor部分:散落在java.util.concurrent包中,提供线程池相关的功能;

- collections部分:散落在java.util.concurrent包中,提供并发容器相关功能;

- tools部分:散落在java.util.concurrent包中,提供同步工具类,如信号量、闭锁、栅栏等功能;

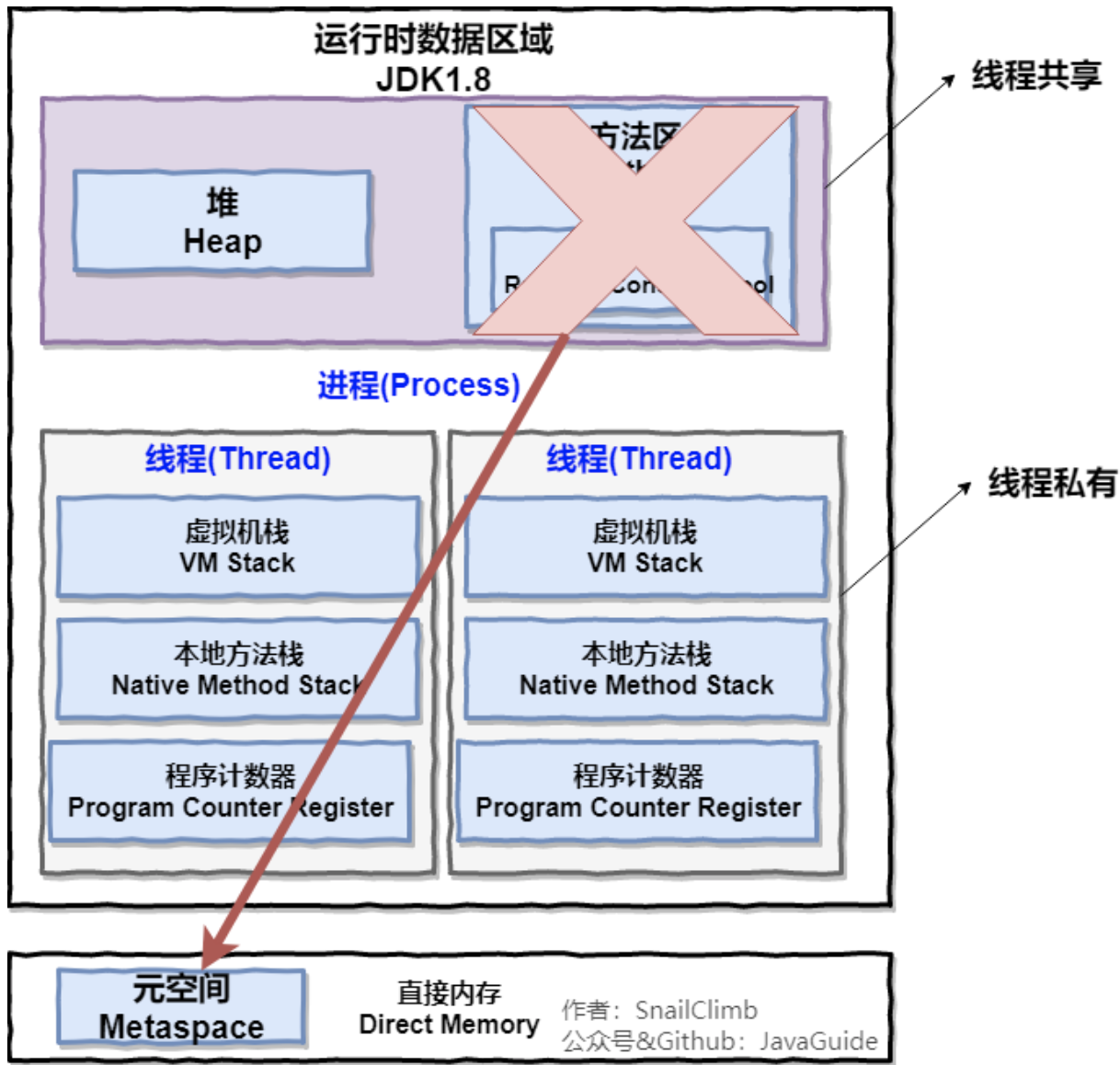

1.3 jvm @@@@@

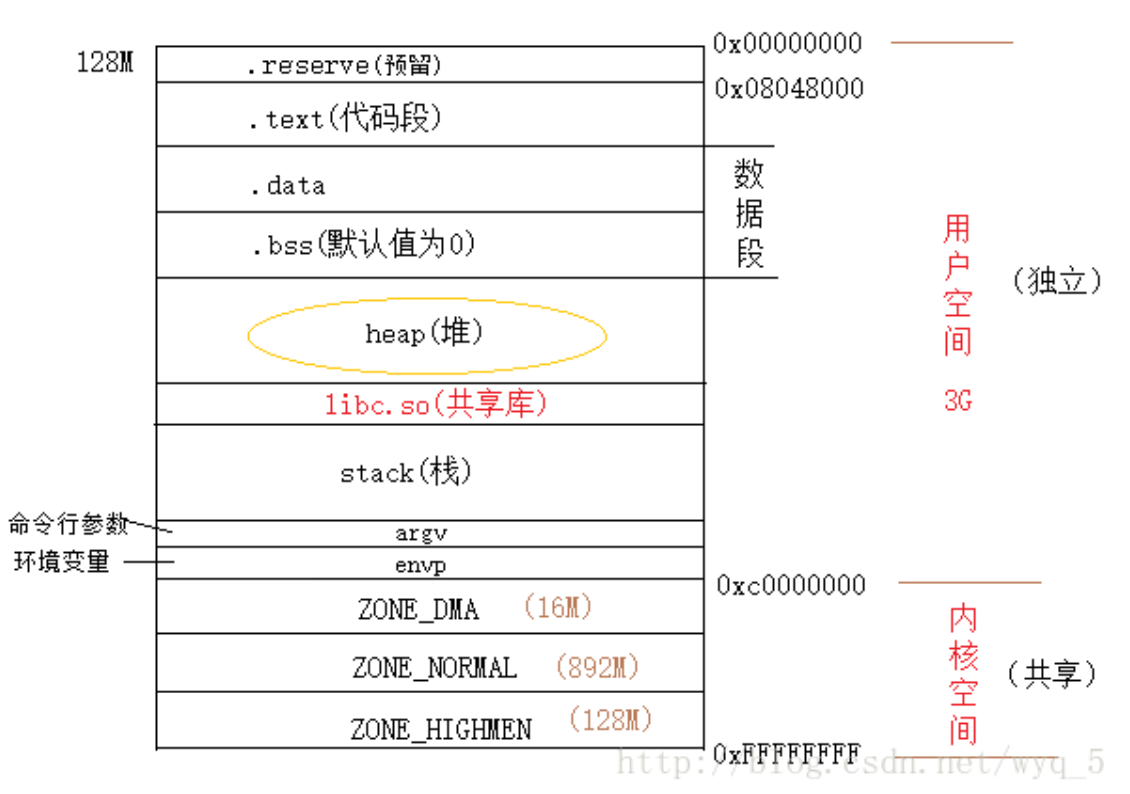

1.3.1 jvm内存结构 @@@@@

- 程序计数器

在JVM规范中,每个线程都有它自己的程序计数器,并且任何时间一个线程都只有一个方法在执行,也就是所谓的当前方法。程序计数器会存储当前线程正在执行的Java方法的JVM指令地址;

为了线程切换后能恢复到正确的执行位置,每条线程都需要有一个独立的程序计数器,各线程之间计数器互不影响,独立存储,我们称这类内存区域为“线程私有”的内存。

从上面的介绍中我们知道程序计数器主要有两个作用:

- 字节码解释器通过改变程序计数器来依次读取指令,从而实现代码的流程控制,如:顺序执行、选择、循环、异常处理。

- 在多线程的情况下,程序计数器用于记录当前线程执行的位置,从而当线程被切换回来的时候能够知道该线程上次运行到哪儿了。

注意:程序计数器是唯一一个不会出现 OutOfMemoryError 的内存区域,它的生命周期随着线程的创建而创建,随着线程的结束而死亡。

- 虚拟机栈

与程序计数器一样,Java 虚拟机栈也是线程私有的,它的生命周期和线程相同,描述的是 Java 方法执行的内存模型,每次方法调用的数据都是通过栈传递的。

Java 内存可以粗糙的区分为堆内存和栈内存,其中栈就是现在说的虚拟机栈。

局部变量表主要存放了编译器可知的各种数据类型、对象引用。

Java 虚拟机栈会出现两种错误:StackOverFlowError 和 OutOfMemoryError。

- StackOverFlowError: 若 Java 虚拟机栈的内存大小不允许动态扩展,那么当线程请求栈的深度超过当前 Java 虚拟机栈的最大深度的时候,就抛出 StackOverFlowError 错误。

- OutOfMemoryError: 若 Java 虚拟机栈的内存大小允许动态扩展,且当线程请求栈时内存用完了,无法再动态扩展了,此时抛出 OutOfMemoryError 错误。

Java 方法有两种返回方式:return 语句;抛出异常。

- 堆

Java 虚拟机所管理的内存中最大的一块,Java 堆是所有线程共享的一块内存区域,在虚拟机启动时创建。此内存区域的唯一目的就是存放对象实例,几乎所有的对象实例以及数组都在这里分配内存。

堆这里最容易出现的就是 OutOfMemoryError 错误,并且出现这种错误之后的表现形式还会有几种,比如:

OutOfMemoryError: GC Overhead Limit Exceeded: 当JVM花太多时间执行垃圾回收并且只能回收很少的堆空间时,就会发生此错误。java.lang.OutOfMemoryError: Java heap space:假如在创建新的对象时, 堆内存中的空间不足以存放新创建的对象, 就会引发java.lang.OutOfMemoryError: Java heap space错误。(和本机物理内存无关,和你配置的内存大小有关!)

- 方法区

所有线程共享的一块内存区域,用于存储所谓的元(Meta)数据,例如类结构信息,以及对应的运行时常量池、字段、方法代码等。

方法区与 Java 堆一样,是各个线程共享的内存区域,它用于存储已被虚拟机加载的类信息、常量、静态变量、即时编译器编译后的代码等数据。虽然 Java 虚拟机规范把方法区描述为堆的一个逻辑部分,但是它却有一个别名叫做 Non-Heap(非堆),目的应该是与 Java 堆区分开来。所以我们把类的信息,以及一些实例无关的信息(即编译器被确定的值)放到了方法区。

在来看堆与栈,栈是用来存储局部变量和计算的过程,堆用来存储实例。这些的区分一定是为了效率。需要考虑变量的生命周期,访问的速度,空间大小,使用过程中是否保持有序。

方法区的一部分。Java的常量池可以存放各种常量信息,不管是编译期生成的各种字面量,还是需要在运行时决定的符号引用,所以它比一般语言的符号表存储的信息更加宽泛。

常量池分为class常量池,运行时常量池,字符串常量池。

class常量池中的字面量和符号引用(符号引用主要是用来重定位的)的概念很重要,需要掌握。这两个玩意都是编译原理里面的。常量是怎么存储的,也很重要,和数据类型是息息相关的。

运行时常量池里保存了符号引用,进而解析为直接引用。

字符串常量池则比较复杂,在不同版本的虚拟机中是不同的,最开始在方法区中,后来移入到了堆中,在后来移动到了本地内存中。其中,方法区在1.8之后移动到本地内存中。

运行时常量池是方法区的一部分。Class 文件中除了有类的版本、字段、方法、接口等描述信息外,还有常量池信息(用于存放编译期生成的各种字面量和符号引用)。既然运行时常量池是方法区的一部分,自然受到方法区内存的限制,当常量池无法再申请到内存时会抛出 OutOfMemoryError 错误。

JDK1.7 及之后版本的 JVM 已经将运行时常量池从方法区中移了出来,在 Java 堆(Heap)中开辟了一块区域存放运行时常量池。

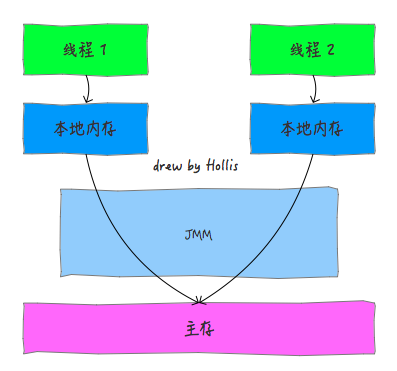

1.3.2 Java内存模型 @@@@@

由于我们抽象了计算机的硬件,在多线程的情况下,会带来缓存一致性问题。为了使处理器内部的运算单元能够尽量的被充分利用,处理器可能会对输入代码进行乱序执行处理。这就是处理器优化,会进一步带来指令重排的问题。

这三个问题对应了我们讲的原子性,可见性和有序性问题。

原子性是指在一个操作中就是cpu不可以在中途暂停然后再调度,既不被中断操作,要不执行完成,要不就不执行。

可见性是指当多个线程访问同一个变量时,一个线程修改了这个变量的值,其他线程能够立即看得到修改的值。

有序性即程序执行的顺序按照代码的先后顺序执行。

我们对此进行对应,缓存一致性问题其实就是可见性问题,而处理器优化是可以导致原子性问题的,指令重排即会导致有序性问题。

所以我们定义了内存模型,来解决上面的问题,主要是限制处理器优化和使用内存屏障。

我们好奇的是java的内存模型解决了缓存一致性问题,那么到底是怎么解决的呢?在最开始,我们是通过在总线上加锁来实现的,但是导致效率低下的问题,后来我们采用缓存一致性协议来解决。

其中,最著名的协议是Intel 的MESI协议。MESI协议保证了每个缓存中使用的共享变量的副本是一致的。核心思想是:当CPU写数据时,如果发现操作的变量是共享变量,即在其他CPU中也存在该变量的副本,会发出信号通知其他CPU将该变量的缓存行置为无效状态,因此当其他CPU需要读取这个变量时,发现自己缓存中缓存该变量的缓存行是无效的,那么它就会从内存重新读取。

1.3.3 Java对象模型@@@@

java的对象模型主要包含对象头,实例数据和对齐填充,主要是研究java的对象是怎么存储的。其中对象头是很重要的,因为对象头中包含锁状态标志、线程持有的锁等标志。

对象头主要包括两部分数据:Mark Word(标记字段)、Klass Pointer(类型指针)。

Mark Word:默认存储对象的HashCode,分代年龄和锁标志位信息。这些信息都是与对象自身定义无关的数据,所以Mark Word被设计成一个非固定的数据结构以便在极小的空间内存存储尽量多的数据。它会根据对象的状态复用自己的存储空间,也就是说在运行期间Mark Word里存储的数据会随着锁标志位的变化而变化。

Klass Point:对象指向它的类元数据的指针,虚拟机通过这个指针来确定这个对象是哪个类的实例。

设计了一个OOP-Klass Model。OOP(Ordinary Object Pointer)指的是普通对象指针,而Klass用来描述对象实例的具体类型。

因为对象头中有和锁相关的运行时数据,这些运行时数据是synchronized以及其他类型的锁实现的重要基础,而关于锁标记、GC分代等信息均保存在_mark中。每一个Java类,在被JVM加载的时候,JVM会给这个类创建一个instanceKlass,保存在方法区,用来在JVM层表示该Java类。当我们在Java代码中,使用new创建一个对象的时候,JVM会创建一个instanceOopDesc对象,这个对象中包含了对象头以及实例数据。

在 Hotspot 虚拟机中,对象在内存中的布局可以分为 3 块区域:对象头、实例数据和对齐填充。

Hotspot 虚拟机的对象头包括两部分信息,第一部分用于存储对象自身的运行时数据(哈希码、GC 分代年龄、锁状态标志等等),另一部分是类型指针,即对象指向它的类元数据的指针,虚拟机通过这个指针来确定这个对象是那个类的实例。

实例数据部分是对象真正存储的有效信息,也是在程序中所定义的各种类型的字段内容。

对齐填充部分不是必然存在的,也没有什么特别的含义,仅仅起占位作用。 因为 Hotspot 虚拟机的自动内存管理系统要求对象起始地址必须是 8 字节的整数倍,换句话说就是对象的大小必须是 8 字节的整数倍。而对象头部分正好是 8 字节的倍数(1 倍或 2 倍),因此,当对象实例数据部分没有对齐时,就需要通过对齐填充来补全。

对象的访问定位的两种方式(句柄和直接指针两种方式)。这两种对象访问方式各有优势。使用句柄来访问的最大好处是 reference 中存储的是稳定的句柄地址,在对象被移动时只会改变句柄中的实例数据指针,而 reference 本身不需要修改。使用直接指针访问方式最大的好处就是速度快,它节省了一次指针定位的时间开销。

-

句柄: 如果使用句柄的话,那么 Java 堆中将会划分出一块内存来作为句柄池,reference 中存储的就是对象的句柄地址,而句柄中包含了对象实例数据与类型数据各自的具体地址信息;

-

直接指针: 如果使用直接指针访问,那么Java堆对象的布局中就必须考虑如何放置访问类型数据的相关信息,而 reference 中存储的直接就是对象的地址。

内存结构讲的是java内存的划分,和运行时区域有关系;内存模型用来解决java的并发编程问题的,和原子性,有序性,可见性有关。

1.3.4 Java的垃圾回收机制 @@@@

内存泄露:程序在申请内存后,无法释放已申请的内存空间;如jdk7的substring方法,解决办法:

- 用jmap生成head dump; 2. 用分析工具MAT找出内存占用超出预期的嫌疑对象;3.根据情况,分析嫌疑对象和其他对象的引用关系;4. 分析程序的源代码,找出嫌疑对象数量过多的原因;

内存溢出:无法申请足够的内存;

-

- 主要回收堆内存,方法区或者堆中的永久代也有可能回收。

- 什么时候回收:

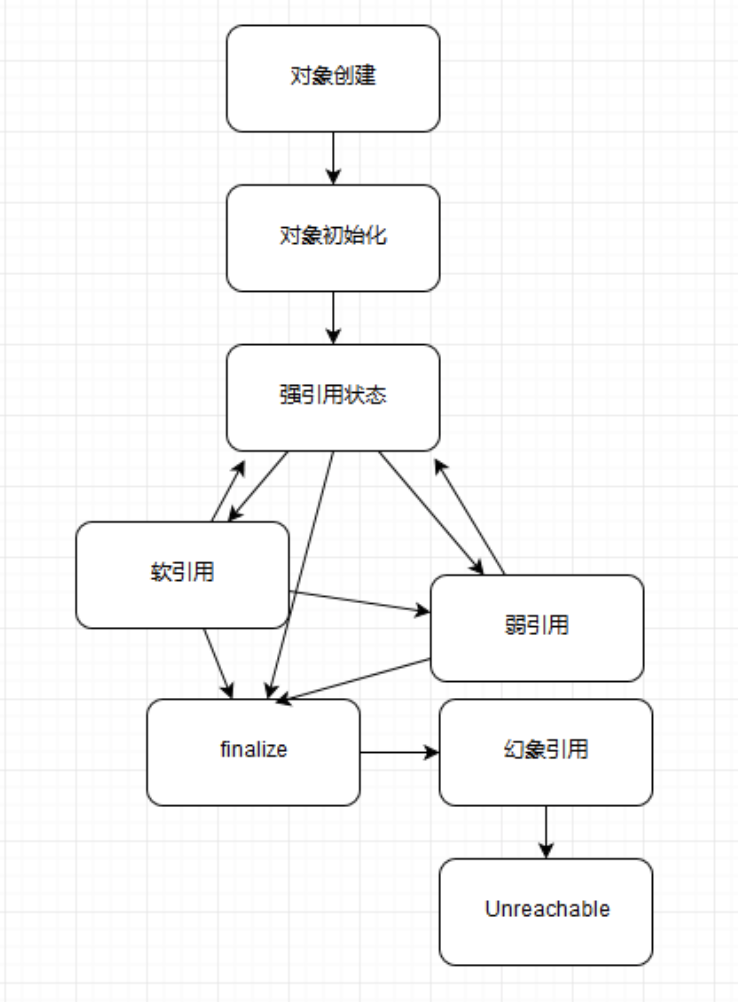

- 我们需要先判断一个对象有没有存活?

- 引用计数法:当两个对象相互引用,但是二者已经没有作用时,应该对其进行垃圾回收,但是其相互引用,又不符合垃圾回收的条件。

- 可达性分析算法:从一个叫GC Roots的对象开始,向下搜索,如果一个对象不能到达GC Roots对象的时候,说明它已经不再被引用,即可被进行垃圾回收。(当一个对象不再被引用时,如果类重写了finalize()方法,且没有被系统调用过,那么系统会调用一次finalize()方法。带来的问题是垃圾回收变慢,拖累jvm的性能)

- 虚拟机栈中引用的对象;方法区中静态属性引用的对象;方法区中常量引用的对象;native方法引用的对象;

- 多线程环境下其他线程可能会更新已经访问过的对象中的引用,从而造成误报(将引用设置为 null)或者漏报(将引用设置为未被访问过的对象,导致回收还在使用的对象,可能导致虚拟机崩溃)。所以引入了Stop-the-world技术,是通过安全点(safepoint)机制来实现的,会等待所有的线程都到达安全点,才允许请求 Stop-the-world 的线程进行独占的工作。对于解释执行来说,字节码与字节码之间皆可作为安全点。Java 虚拟机采取的做法是,当有安全点请求时,执行一条字节码便进行一次安全点检测。

- 四种引用:主要体现的是对象不同的可达性(reachable)状态和对垃圾收集的影响。

-

强引用:刚被new出来的对象所加的引用,表明对象还活着。

-

软引用:可被回收的对象(如缓存的对象),内存不足时会去回收。

-

弱引用:弱引用的对象就是一定需要进行垃圾回收的

-

虚引用:唯一作用就是做一些跟踪记录,辅助finalize函数的使用。

-

- 我们需要先判断一个对象有没有存活?

-

Minor GC:年轻代;Major GC:老年代;Full GC:整个堆。

- 如何回收

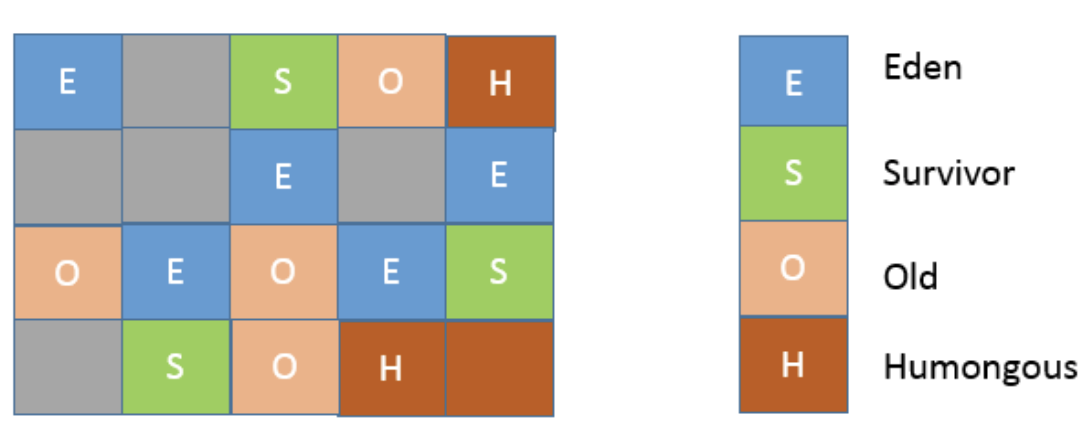

- 堆内存分块,jdk7之前,7之后移除了永久代

- 新生代

- 一个Eden区,两个Survivor区。

- 大部分对象在Eden区中生成。当Eden区满时,还存活的对象将被复制到两个Survivor区(中的一个)。当这个Survivor区满时,此区的存活且不满足“晋升”条件的对象将被复制到另外一个Survivor区。对象每经历一次Minor GC,年龄加1,达到“晋升年龄阈值”后,被放到老年代,这个过程也称为“晋升”。

- 老年代:放置长生命周期的对象,通常都是从Survivor区域拷贝过来的对象大对象会直接进入老年代。需要大量连续内存空间的对象(比如:字符串、数组)

- 永久代:早期Hotspot JVM的方法区实现方式了,储存Java类元数据、常量池、Intern字符串缓存。

- 最大堆:-Xmx value;最小堆:-Xms value;老年代和新生代比例-XX:NewRatio=value。默认是3。新生代是堆大小的1/4。

- 新生代

- 垃圾回收算法

- 标记清除算法:首先标记出所有需要回收的对象,在标记完成后统一回收所有被标记的对象。标记和清除的效率都不高;存在大量的空间碎片。

- 标记复制算法:解决了内存碎片的问题,缺陷是可以使用的内存变成了原来的一半。将现有的内存空间分为两快,每次只使用其中一块,在垃圾回收时将正在使用的内存中的存活对象复制到未被使用的内存块中,之后,清除正在使用的内存块中的所有对象。(用在新生代,因为存活的对象比较少,需要复制的不多)

- 标记-整理算法:解决了内存碎片化的问题。针对老年代(需要回收的对象不多)。首先对或者的对象做标记,但之后,它并不简单地清理未标记的对象,而是将所有的存活对象压缩到内存的一端。之后,清理边界外所有的空间。

- 分代收集算法:根据对象的存活特性。比如在新生代中,每次收集都会有大量对象死去,所以可以选择复制算法,只需要付出少量对象的复制成本就可以完成每次垃圾收集。而老年代的对象存活几率是比较高的,而且没有额外的空间对它进行分配担保,所以我们必须选择“标记-清除”或“标记-整理”算法进行垃圾收集。

- 垃圾回收器(评价垃圾处理器的指标:吞吐量(应用程序和系统总运行时间(应用程序+垃圾回收的时间)的比值),停顿时间(应用程序的暂停时间,并行的GC停顿时间变短,吞吐量降低),垃圾回收频率

-

Serial收集器:单线程回收,stop the world,用在客户端。新生代采用复制算法,老年代采用标记-压缩算法。

-

ParNew:Serial收集器的多线程版本。充分的利用CPU资源,减少回收的时间。stw。

- Concurrent Mark Sweep:cms,基于标记-清除算法,主要关注于系统停顿时间(减少无响应的时间)。

- 初始标记STW:标记GC ROOT能直接关联到的对象,所以很快。

- 并发标记:由前阶段标记过的对象出发,所有可到达的对象都在本阶段中标记。耗时最长。

- 重新标记STW: 修正并发标记期间因用户程序继续运作导致标记产生变动的那一部分对象的标记记录。因为并发标记阶段是和用户线程并发执行的过程,所以该过程中可能有用户线程修改某些活跃对象的字段,指向了一个未标记过的对象,在并发标记开始时不可达,但是并行期间引用发生变化,变为对象可达,这个阶段需要重新标记出此类对象,防止在下一阶段被清理掉。

- 并发清除和并发重置:进行并发的垃圾清理。

- 缺点:占用CPU资源(并发标记),无法处理浮动垃圾(Concurrent Mode Failure,导致产生full gc),它使用的回收算法-“标记-清除”算法会导致收集结束时会有大量空间碎片产生。

-

G1:Garbage First,兼顾吞吐量和停顿时间。新生代采用并行的复制算法,发生stop the world。老年代采用并发标记-整理算法。过程和CMS差不多,内存划分上不同。

- 初始标记STW:标记 GC Roots 能直接关联到的对象,让下一阶段用户线程并发运行时能正确地在可用 Region 中分配新对象。

- 并发标记:从 GC Roots 开始对堆中对象进行可达性分析,递归扫描整个堆的对象图。耗时长但可与用户线程并发,扫描完成后要重新处理 SATB 记录的在并发时有变动的对象。

- 最终标记STW:对用户线程做短暂暂停,处理并发阶段结束后仍遗留下来的少量 SATB 记录。

- 筛选回收:对各 Region 的回收价值排序,根据用户期望停顿时间制定回收计划。必须暂停用户线程,由多条收集线程并行完成。

核心概念:

region:传统GC收集器的内存空间是连续的,G1各代存储地址是不连续的,每一代都使用了n个不连续的大小相同的Region,每个Region占有一块连续的虚拟内存地址。其中Humongous是指大对象。

SATB:Snapshot-At-The-Beginning。是GC开始时活着的对象的一个快照。它是通过Root Tracing得到的,作用是维持并发GC的正确性。

Rset:Remembered Set,是辅助GC过程的一种结构,典型的空间换时间工具。

Pause Prediction Model :停顿预测模型。G1 GC是一个响应时间优先的GC算法,它与CMS最大的不同是,用户可以设定整个GC过程的期望停顿时间。

- 并行与并发:G1 能充分利用 CPU、多核环境下的硬件优势,使用多个 CPU来缩短 Stop-The-World 停顿时间。

- 分代收集:虽然 G1 可以不需要其他收集器配合就能独立管理整个 GC 堆,但是还是保留了分代的概念。

- 空间整合:与 CMS 的“标记–清理”算法不同,G1 从整体来看是基于“标记整理”算法实现的收集器;

- G1 收集器在后台维护了一个优先列表,每次根据允许的收集时间,优先选择回收价值最大的 Region(这也就是它的名字 Garbage-First 的由来)。这种使用 Region 划分内存空间以及有优先级的区域回收方式,保证了 G1 收集器在有限时间内可以尽可能高的收集效率。

-

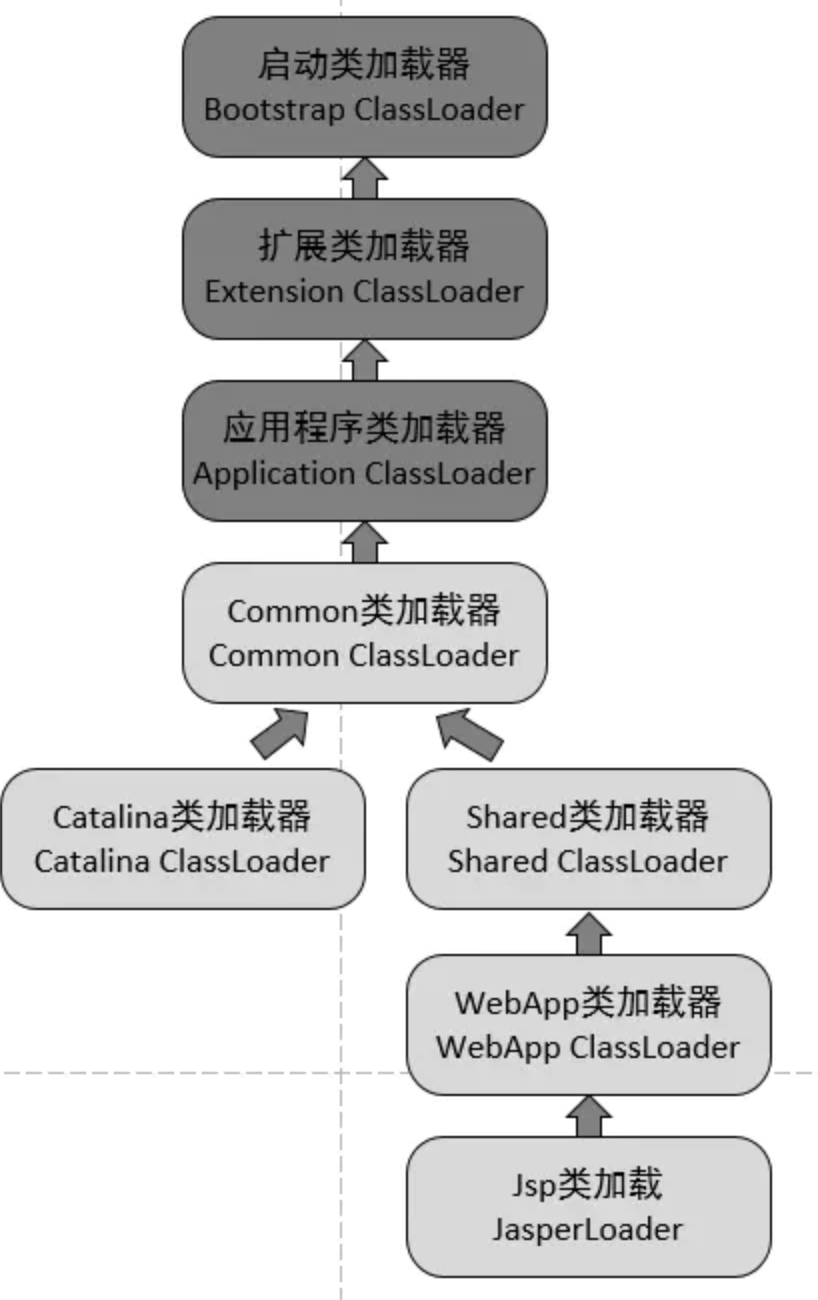

1.3.5 类加载机制 @@@@@

java类装载器有三个,分别是BootStrap(加载核心类, jre/lib下面的jar文件),ExtClassLoader(加载扩展类jre/lib/ext/),AppClassLoader(加载classpath)。

双亲加载模型指的不是2个父亲,而是指父类和bootstrap classloader。加载过程,先是启动类加载器,然后父类,最后自己来处理。

双亲加载模型的好处:同一个类被不同类加载器加载会产生两个实例,所以该模型可以避免重复加载(JVM 区分不同类的方式不仅仅根据 类名,相同的类文件被不同的类加载器加载产生的是两个不同的类);保证了 Java 的核心 API 不被篡改。

类加载器简言之,就是用于把.class文件中的字节码信息转化为具体的java.lang.Class对象的过程的工具。

加载,连接(验证,准备和解析),初始化。

- 加载:查找并加载类的二进制数据的过程。

- 通过类的全限定名定位

.class文件,并获取其二进制字节流。 - 把字节流所代表的静态存储结构转换为方法区的运行时数据结构。

- 在

Java堆中生成一个此类的java.lang.Class对象,作为方法区中这些数据的访问入口。

- 通过类的全限定名定位

- 连接

- 验证:保证字节流符合虚拟机的要求,并且不会危害虚拟机自身的安全。

- 准备:为类的静态变量分配内存,并将其初始化为默认值。准备过程通常分配一个结构用来存储类信息,这个结构中包含了类中定义的成员变量,方法和接口信息等。

- 解析:把类中对常量池内的符号引用转换为直接引用。

- 初始化

- 对类静态变量赋予正确的初始值 (注意和连接时的解析过程区分开)。

对象的初始化顺序:

静态变量/静态代码块 -> 普通代码块 -> 构造函数

-

父类静态变量和静态代码块(先声明的先执行);

- 子类静态变量和静态代码块(先声明的先执行);

-

父类普通成员变量和普通代码块(先声明的先执行);

-

父类的构造函数;

-

子类普通成员变量和普通代码块(先声明的先执行);

- 子类的构造函数。

tomcat类加载有什么不同,说加载顺序并不是双亲模型,具体顺序说一下

我们来看下为什么要破坏双亲模型?

- 隔离性。一个web容器可能需要部署两个应用程序,不同的应用程序可能会依赖同一个第三方类库的不同版本,不能要求同一个类库在同一个服务器只有一份,因此要保证每个应用程序的类库都是独立的,保证相互隔离。

- 灵活性:Web应用之间的类加载器相互独立,那么就能针对一个Web应用进行重新部署,此时Web应用的类加载器会被重建,而且不会影响其他的Web应用。如果采用一个类加载器,类之间的依赖是杂乱复杂的,无法完全移出某个应用的类。

- 性能:部署在同一个Web容器上的两个Web应用程序所使用的Java类库可以互相共享。这个需求也很常见,例如,用户可能有10个使用Spring组织的应用程序部署在同一台服务器上,如果把10份Spring分别存放在各个应用程序的隔离目录中,将会是很大的资源浪费。

所以tomcat重新定义了类加载器。

Common:以应用类加载器为父类,是tomcat顶层的公用类加载器,其路径由conf/catalina.properties中的common.loader指定,默认指向${catalina.home}/lib下的包。

Catalina:以Common类加载器为父类,是用于加载Tomcat应用服务器的类加载器,其路径由server.loader指定,默认为空,此时tomcat使用Common类加载器加载应用服务器。

Shared:以Common类加载器为父类,是所有Web应用的父类加载器,其路径由shared.loader指定,默认为空,此时tomcat使用Common类加载器作为Web应用的父加载器。

Web应用:以Shared类加载器为父类,加载/WEB-INF/classes目录下的未压缩的Class和资源文件以及/WEB-INF/lib目录下的jar包,该类加载器只对当前Web应用可见,对其他Web应用均不可见。

Web应用类加载器默认的加载顺序是:

(1).先从缓存中加载; (2).如果没有,则从JVM的Bootstrap类加载器加载; (3).如果没有,则从当前类加载器加载(按照WEB-INF/classes、WEB-INF/lib的顺序); (4).如果没有,则从父类加载器加载,由于父类加载器采用默认的委派模式,所以加载顺序是AppClassLoader、Common、Shared。

1.3.6 GC调优@@@

javac 、javap 、jps、jstack,jinfo、jstat 、jmap 、jhat

jps:查看本机的Java中进程信息。jps -q :只输出进程的本地虚拟机唯一 ID。jps -l:输出主类的全名,如果进程执行的是 Jar 包,输出 Jar 路径。jps -v:输出虚拟机进程启动时 JVM 参数。jps -m:输出传递给 Java 进程 main() 函数的参数。

jstack:打印线程的栈信息,制作线程Dump。线程快照就是当前虚拟机内每一条线程正在执行的方法堆栈的集合.生成线程快照的目的主要是定位线程长时间出现停顿的原因,如线程间死锁、死循环、请求外部资源导致的长时间等待等都是导致线程长时间停顿的原因。线程出现停顿的时候通过jstack来查看各个线程的调用堆栈,就可以知道没有响应的线程到底在后台做些什么事情,或者在等待些什么资源。可以检查死锁。

jinfo:Java 配置信息工具。查看虚拟机各项参数,使用 jps -v 可查看虚拟机启动时显式指定的参数,但如果想知道未显式指定的参数只能使用 jinfo -flag。

jmap:打印内存映射,制作堆Dump。其中主要包括系统信息、虚拟机属性、完整的线程Dump、所有类和对象的状态等。jmap 的作用并不仅仅是为了获取 dump 文件,它还可以查询 finalizer 执行队列、Java 堆和永久代的详细信息,如空间使用率、当前使用的是哪种收集器等。eclipse一般用MAT插件进行分析jmap文件,idea一般用JProfiler来分析jmap文件。

jhat:内存分析工具。jhat 用于分析 heapdump 文件,它会建立一个 HTTP/HTML 服务器,让用户可以在浏览器上查看分析结果。

jstat:性能监控工具。( JVM Statistics Monitoring Tool): 用于收集 HotSpot 虚拟机各方面的运行数据。比如 jstat -gc -h3 31736 1000 10表示分析进程 id 为 31736 的 gc 情况,每隔 1000ms 打印一次记录,打印 10 次停止,每 3 行后打印指标头部。

排查内存问题:

top,vmstat,pidstat。

- 排查实例(OOM),CPU占用过高

1) top命令看进程的内存使用情况;

2) top -Hp pid查看线程占用资源的情况,tid,用printf ‘%x/n’ tid 把线程id转化为十六进制;

| 3)jstack pid查看线程的堆栈信息(看看是否是死锁或IO阻塞,CPU使用率会很高);jstack **pid | grep tid -A 30**,定位线程堆栈信息; |

4)jmap查看堆内存使用情况。

- jvm old占用过高

1) top查看占用cpu高的进程

2)jstat -gcutil pid 时间间隔 查看gc状况

3)jmap -dump:format=b,file=name.dump pid 导出dump文件

4)用visualVM分析dump文件

GC优化一般步骤可以概括为:确定目标、优化参数、验收结果。

明确应用程序的系统需求是性能优化的基础,系统的需求是指应用程序运行时某方面的要求,譬如: - 高可用,可用性达到几个9。 - 低延迟,请求必须多少毫秒内完成响应。 - 高吞吐,每秒完成多少次事务。

- Major GC和Minor GC频繁

首先优化Minor GC频繁问题。通常情况下,由于新生代空间较小,Eden区很快被填满,就会导致频繁Minor GC,因此可以通过增大新生代空间来降低Minor GC的频率。例如在相同的内存分配率的前提下,新生代中的Eden区增加一倍,Minor GC的次数就会减少一半。

扩容后,Minor GC时增加了T1(扫描时间),但省去T2(复制对象)的时间,更重要的是对于虚拟机来说,复制对象的成本要远高于扫描成本,所以,单次Minor GC时间更多取决于GC后存活对象的数量,而非Eden区的大小。因此如果堆中短期对象很多,那么扩容新生代,单次Minor GC时间不会显著增加。

如何选择各分区大小应该依赖应用程序中对象生命周期的分布情况:如果应用存在大量的短期对象,应该选择较大的年轻代;如果存在相对较多的持久对象,老年代应该适当增大。

- 提高服务可用性

GC日志显示,高峰期CMS在重标记(Remark)阶段耗时1.39s。Remark阶段是Stop-The-World(以下简称为STW)的,即在执行垃圾回收时,Java应用程序中除了垃圾回收器线程之外其他所有线程都被挂起,意味着在此期间,用户正常工作的线程全部被暂停下来,这是低延时服务不能接受的。本次优化目标是降低Remark时间。

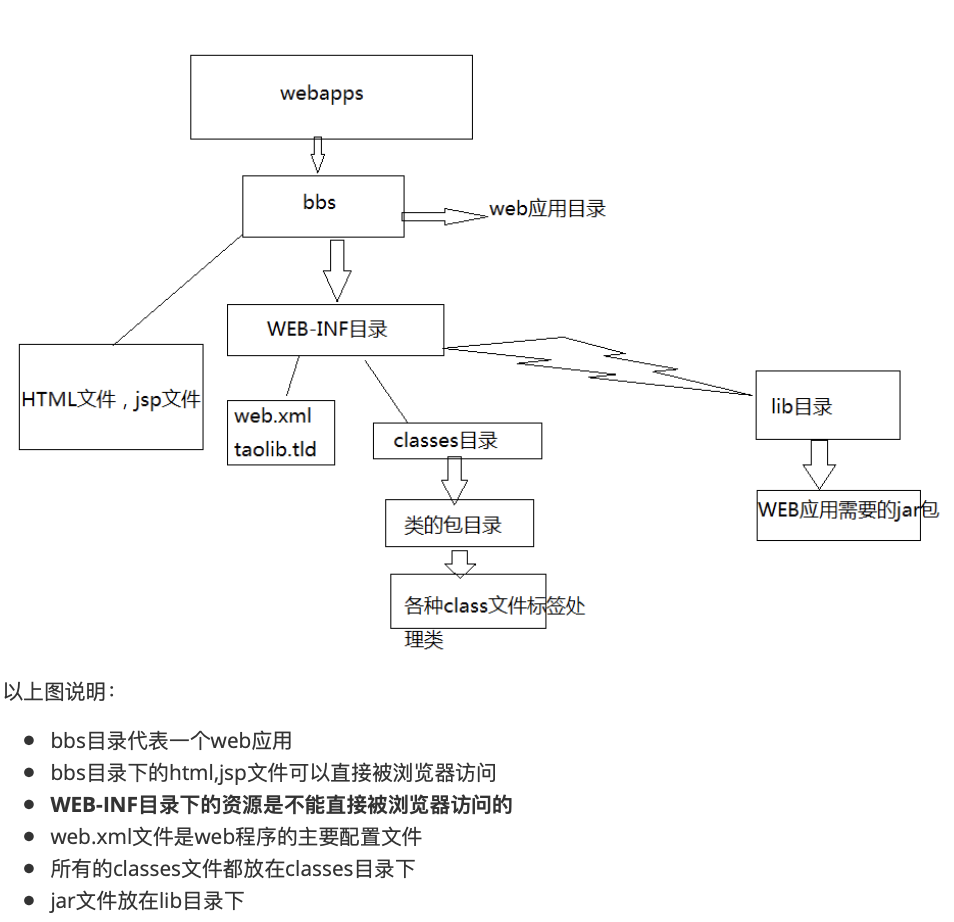

1.4 Java EE @@@@@

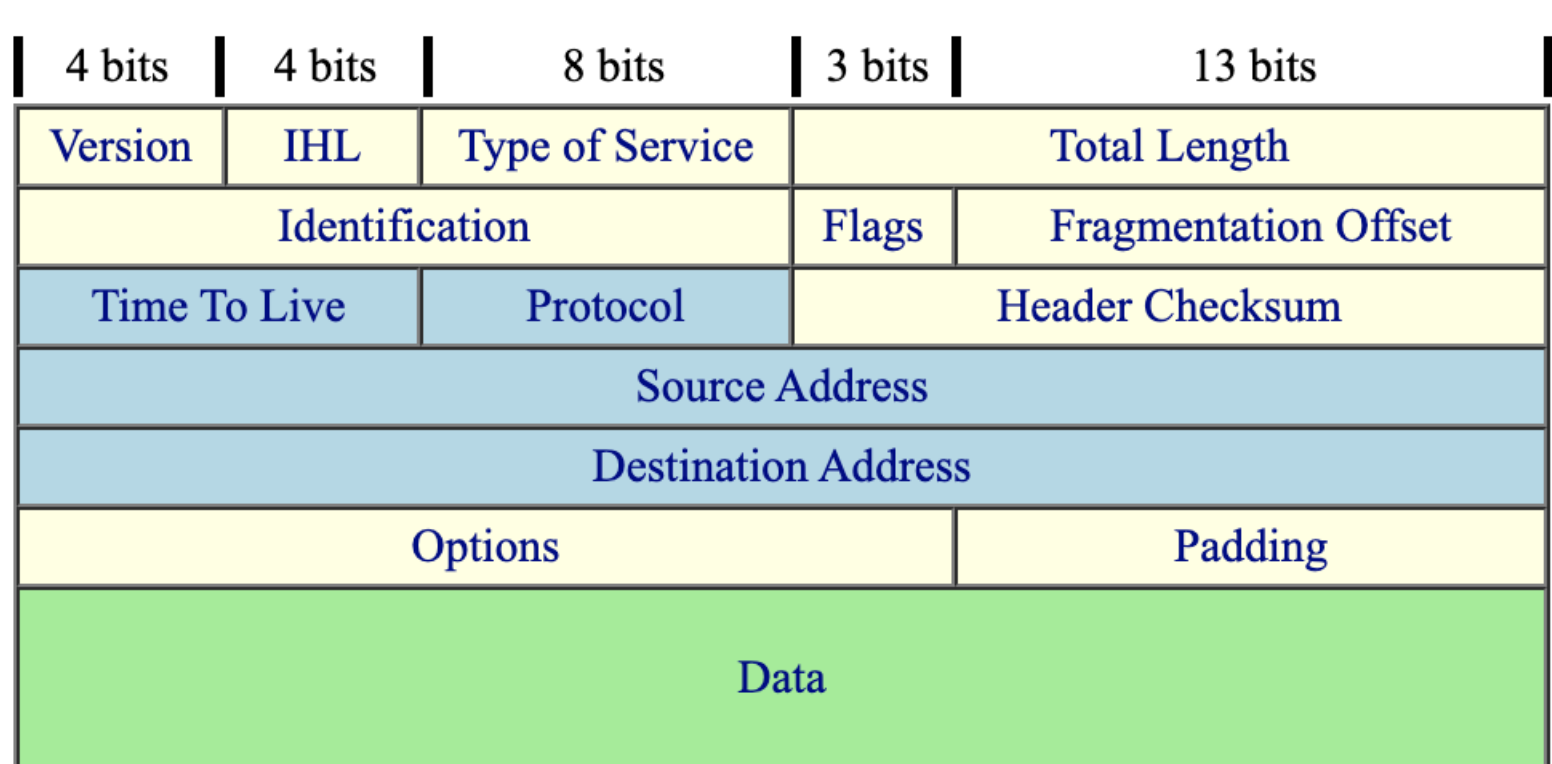

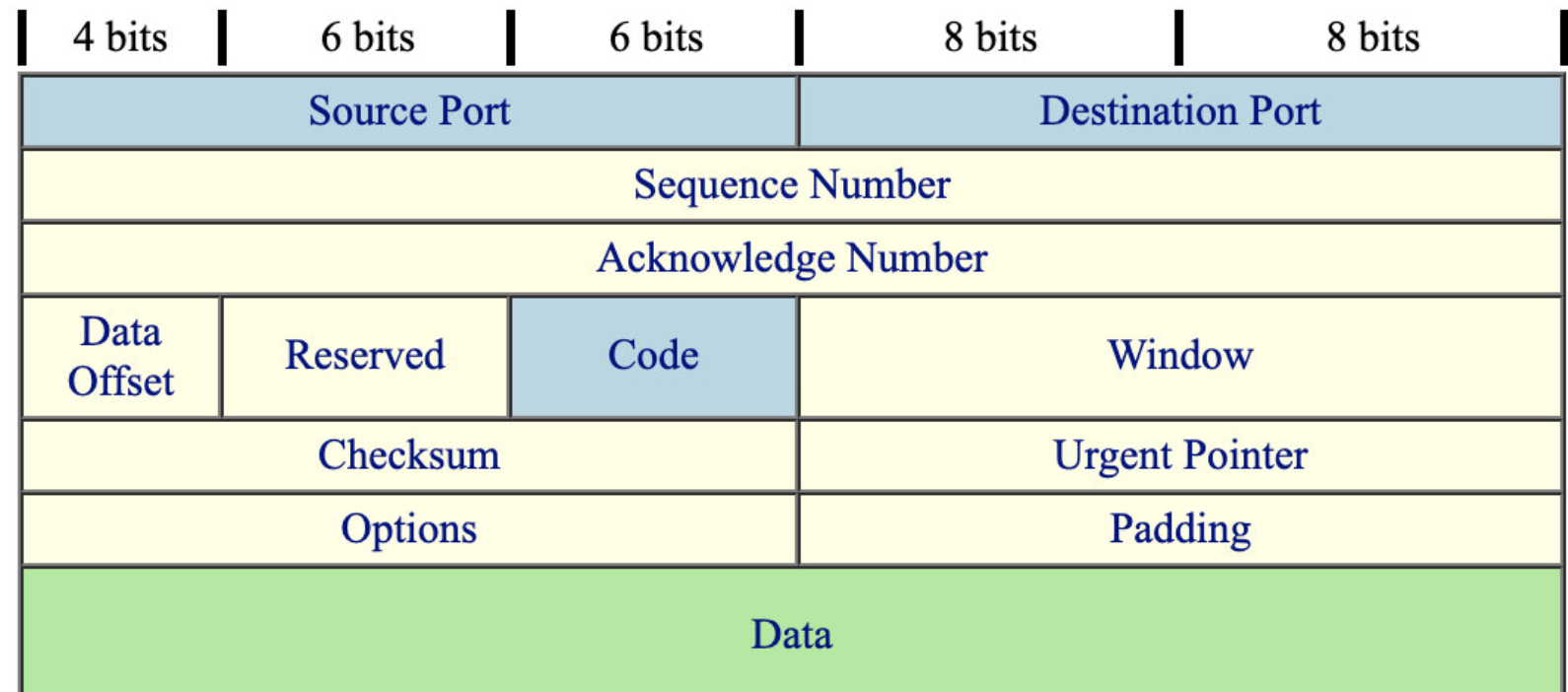

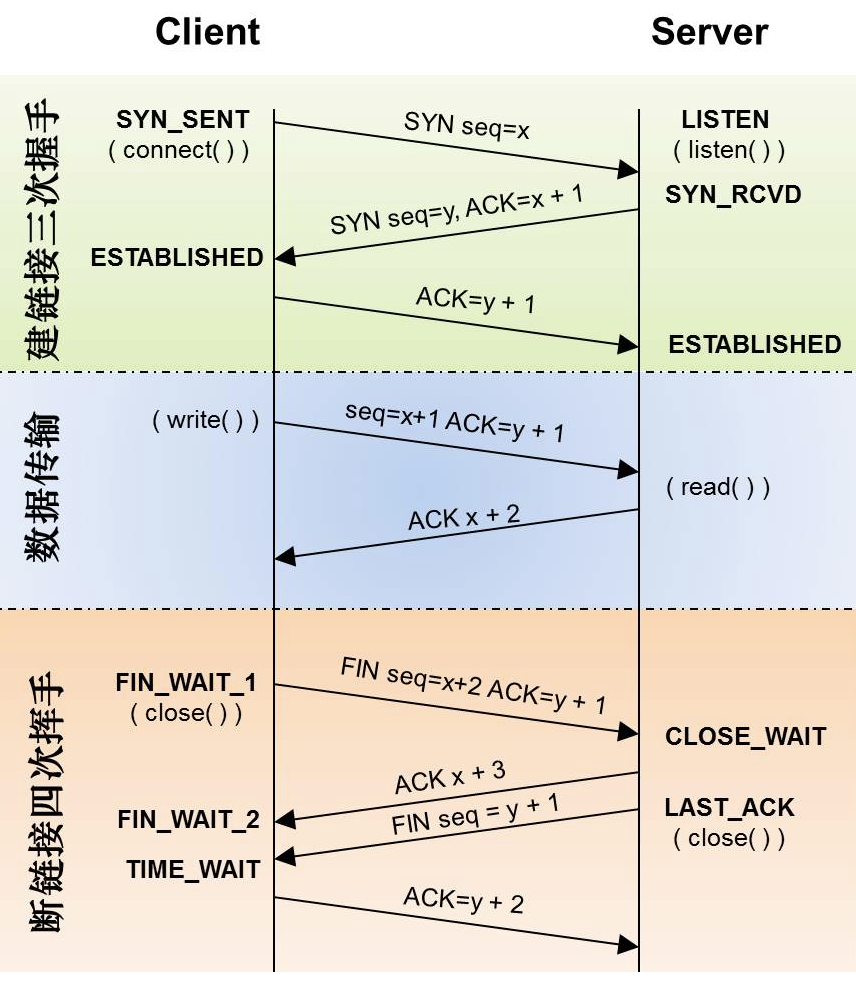

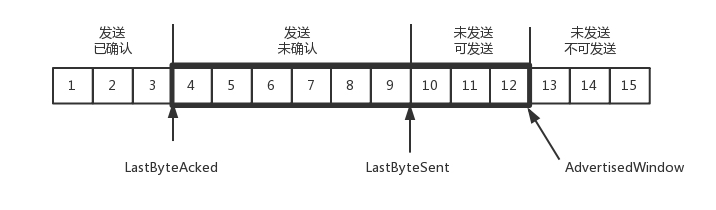

最开始我们想让2台电脑进行通信,需要借助于TCP/UDP的通信规范,要处理像是3次握手,累积确认等,我们于是抽象出来了socket的概念。大概是这样的:(客户端IP, 客户端Port, 服务器端IP, 服务器端Port)

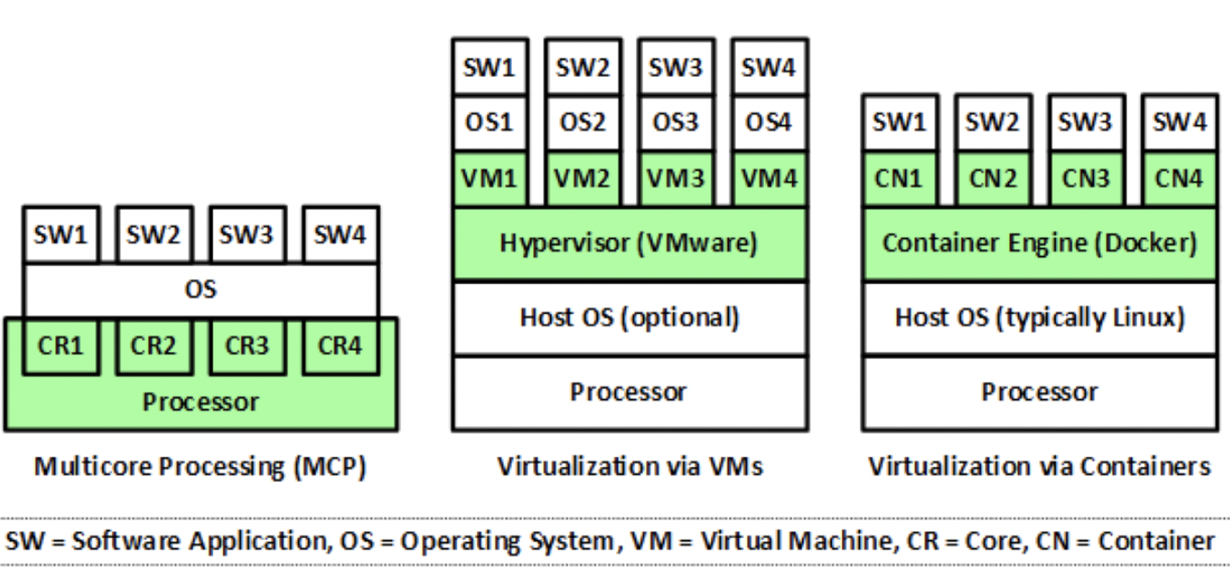

我们来看下Http Server的演化,第一个阶段是借助socket来传输文件,但是进程会阻塞在socket的receive上。我们引入了多进程编程:当accept连接以后,对于这个新的socket , 不在主进程里处理, 而是新创建子进程来接管。 这样主进程就不会阻塞在receive 上, 可以继续接受新的连接了。

问题没有得到完美的解决,当请求数量多的时候,我们需要耗费大量的资源。一个进程处理一个socket是不可能的。

我们需要改变服务器的工作方式,当接受了客户端连接以后, 不能那么着急的去读, 把每个socket fd告诉内核,然后阻塞。操作系统会在后台检查这些编号的socket, 如果发现这些socket 可以读写, 会把对应的socket 做个标记, 把服务器唤醒去处理这些socket 的数据, 处理完了,再把socket fd 告诉内核, 再次进入阻塞,如此循环往复。进程告诉操作系统要等待什么东西, 然后阻塞, 如果事件发生了, 操作系统就把进程唤醒, 让进程做事情。关键点是进程等操作系统的通知, 操作系统把内核从阻塞状态唤醒后, 内核一定要去遍历一遍所有的socket fd,看看谁有标记, 有标记的做相应处理。 把这种方式叫做 select。

用select的方式改写了Http server, 抛弃了一个socket请求对于一个进程的模式, 现在用一个进程就可以处理所有的socket了。到这里似乎完美的解决了问题,但是还是存在着问题,第一个问题是一个进程最多有1024个socket fd,另一个问题是每次从阻塞中恢复以后,需要遍历这1000多个socket fd, 看看有没有标志位需要处理。

事实上, 很多socket 并不活跃,每次可能只有几十个需要处理的socket,但是不得不查看所有的socket fd。所以引入了epoll模型。

静态服务器vs动态服务器

然后最开始服务器是静态的,工作很简单,在80端口上监听,解析客户端发过来的HTTP的请求, 然后把相对应的HTML文件、Image等返回给客户端就可以了。

但是如果想再往前走一步,让Web服务器能产生动态内容,那就难了。我们为了让进程间通信,引入了CGI通用网关接口(Common Gateway Interface),(一个CGI程序将他的动态内容发送到标准输出,在子进程加载并运行CGI程序之前,他使用Unix dup2函数将标准输出到重定向到客户端相关联的已连接描述符。注意,父进程不知道子进程生成的内容的类型和大小,所以子进程负责生成Content-type和Content-length响应报头,终止报头的空行。)但是CGI过于复杂(需要为每个请求启动一个操作CGI程序的系统进程。如果请求频繁,这将会带来很大的开销;需要为每个请求加载和运行一个CGI程序,这将带来很大的开销;需要重复编写处理网络协议的代码以及编码,这些工作都是非常耗时的。),我们抽象出了Servlet(1,只需要启动一个操作系统进程以及加载一个JVM,大大降低了系统的开销;2,如果多个请求需要做同样处理的时候,这时候只需要加载一个类,这也大大降低了开销;3,所有动态加载的类可以实现对网络协议以及请求解码的共享,大大降低了工作量。4,Servlet能直接和Web服务器交互,而普通的CGI程序不能。Servlet还能在各个程序之间共享数据,使数据库连接池之类的功能很容易实现。),为了管理Servlet,我们又抽象出了tomcat。但问题是Servlet是java的规范,于是定义了通用的WSGI,这样任何语言都可以了。

1.4.1 Servlet

Servlet抽象了CGI。其实质就是运行在 Web 应用服务器上的 Java 程序,可以对 Web 浏览器或其他 HTTP 客户端程序发送的请求进行处理。

- Servlet的生命周期。

-

加载Servlet。当Tomcat第一次访问Servlet的时候,Tomcat会负责创建Servlet的实例

-

初始化。当Servlet被实例化后,Tomcat会调用init()方法初始化这个对象

-

处理服务。当浏览器访问Servlet的时候,Servlet 会调用service()方法处理请求

-

销毁。当Tomcat关闭时或者检测到Servlet要从Tomcat删除的时候会自动调用destroy()方法,让该

实例释放掉所占的资源。一个Servlet如果⻓时间不被使用的话,也会被Tomcat自动销毁

-

卸载。当Servlet调用完destroy()方法后,等待垃圾回收。如果有需要再次使用这个Servlet,会重

新调用init()方法进行初始化操作。

- 为什么Servlet是单例的?

浏览器多次对Servlet的请求,一般情况下,服务器只创建一个Servlet对象,也就是说,Servlet对象一旦创建了,就会驻留在内存中,为后续的请求做服务,直到服务器关闭。

对于每次访问请求,Servlet引擎都会创建一个新的HttpServletRequest请求对象和一个新的HttpServletResponse响应对象,然后将这两个对象作为参数传递给它调用的Servlet的service()方法,service方法再根据请求方式分别调用doXXX方法。

当多个用户访问Servlet的时候,服务器会为每个用户创建一个线程。当多个用户并发访问Servlet共享资源的时候就会出现线程安全问题。

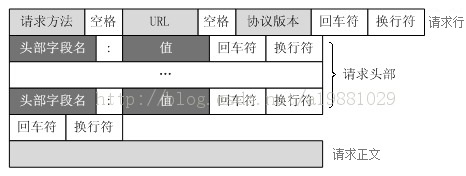

1.4.2 web基础

1.4.2.1 get vs post

| Get | Post | |

|---|---|---|

| 数据携带 | 在URL地址后附带的参数是有限制的,其数据容量通常不能超过1K | 可以在请求的实体内容中向服务器发送数据,传送的数据量无限制 |

| 请求参数的位置 | 请求参数放在URL地址后面,以?的方式来进行拼接 | 请求参数放在HTTP请求包中 |

| 用途 | 用来获取数据 | 用来提交数据 |

1.4.2.2 Cookie和Session有什么区别?

我们知道http是无状态的,请求和响应都没有序列化,所以我们引入了cookie技术。Cookie 技术通过在请求和响应报文中写入Cookie信息来控制客户端的状态。

- Name:就是cookieName

- value:cookieName对应的值。

- domain:域,表示当前cookie所属于哪个域或子域下面

- path:表示cookie的所属路径,一般设为“/”,表示同一个站点的所有页面都可以访问这个cookie。

- expiration:表示了cookie的有效期。

- secure:表示该cookie只能用https传输。

| cookie | session | |

|---|---|---|

| 存储方式 | 只能存储String,非ASCII字符串需要编码 | 存储任何类型的数据 |

| 隐私 | 客户端 | 服务器 |

| 有效期 | 序列化了 | 关闭浏览器即失效 |

| 负担 | 不占用服务器资源 | 占用服务器资源 |

| 浏览器支持 | 会被禁掉 | 不会 |

| 大小限制 | 3k | 无 |

| 跨域名 | 不可跨域名(子域名也不行) | 不可跨域名 |

| 有效期 | MaxAge为正数:写到硬盘;maxage为零:删除cookie;maxage为负数:关闭浏览器无效。 |

服务器不需要保存session,对session进行加密,然后把session和签名发送客户端,客户端无法伪造签名。

1.4.2.3 转发和重定向

转发是服务器行为,重定向是客户端行为。

- 从地址栏显示来说: forward是服务器请求资源,服务器直接访问目标地址的URL,把那个URL的响应内容读取过来, 然后把这些内容再发给浏览器.浏览器根本不知道服务器发送的内容从哪里来的,所以它的地址栏还是原来的地址. redirect是服务端根据逻辑,发送一个状态码,告诉浏览器重新去请求那个地址.所以地址栏显示的是新的URL.

- 从数据共享来说: forward:转发页面和转发到的页面可以共享request里面的数据. redirect:不能共享数据.

- 从运用地方来说: forward:一般用于用户登陆的时候,根据角色转发到相应的模块. redirect:一般用于用户注销登陆时返回主页面和跳转到其它的网站等

- 从效率来说: forward:高. redirect:低.

1.4.2.4 监听器有哪些作用和用法

Java Web开发中的监听器(listener)就是application、session、request三个对象创建、销毁或者往 其中添加修改删除属性时自动执行代码的功能组件,如下所示:

- ServletContextListener:对Servlet上下文的创建和销毁进行监听。

- ServletContextAttributeListener:监听Servlet上下文属性的添加、删除和替换。

- HttpSessionListener:对Session的创建和销毁进行监听。

- HttpSessionAttributeListener:对Session对象中属性的添加、删除和替换进行监听。

- ServletRequestListener:对请求对象的初始化和销毁进行监听。

- ServletRequestAttributeListener:对请求对象属性的添加、删除和替换进行监听。

常⻅的监听器用途主要包括:网站在线人数技术、监听用户的行为(管理员踢人)。

1.4.2.5 过滤器

过滤器是一个驻留在服务器端的Web组件,它可以截取客户端和服务器之间的请 求与响应信息,并对这些信息进行过 滤。当Web容器接受到一个对资源的请求时,它将判断是否有过滤 器与这个资源相关联。如果有,那么容器将把请求交给过滤器进行处理。在过滤器中,你可以改 变请求 的内容,或者重新设置请求的报头信息,然后再将请求发送给目标资源。当目标资源对请求作出响应时 候,容器同样会将响应先转发给过滤器,再过滤器中, 你可以对响应的内容进行转换,然后再将响应发送到客户端。

常⻅的过滤器用途主要包括:对用户请求进行统一认证、对用户的访问请求进行记录和审核、对用户发 送的数据进行过滤或替换、转换图象格式、对响应内容进行压缩以减少传输量、对请求或响应进行加解 密处理、触发资源访问事件、对XML的输出应用XSLT等。

和过滤器相关的接口主要有:Filter、FilterConfig、FilterChain。

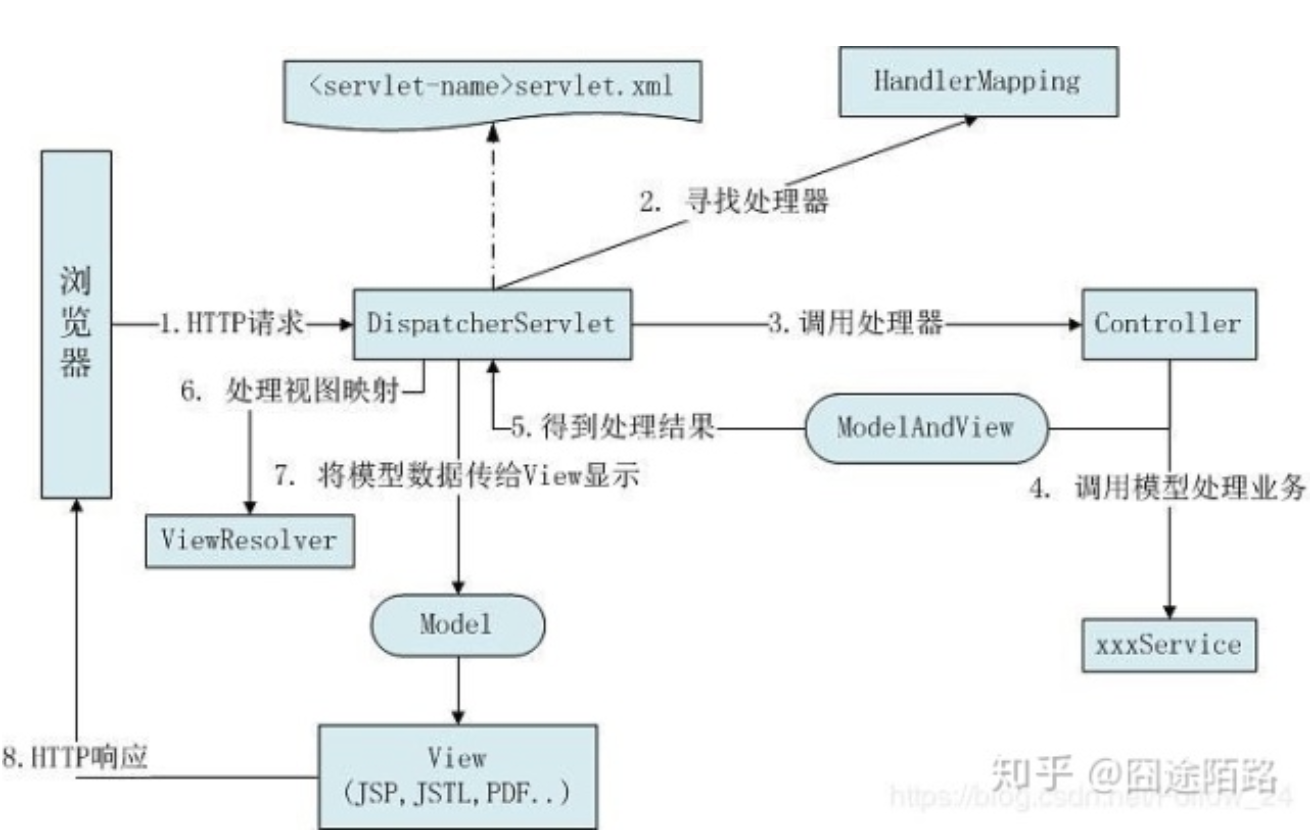

1.4.3 Spring

- spring:Spring是一个开源容器框架,可以接管web层,业务层,dao层,持久层的组件,并且可以配置各种bean,和维护bean与bean之间的关系。其核心就是控制反转(IOC),和面向切面(AOP),简单的说就是一个分层的轻量级开源框架。

-

spring mvc:使用mvc框架来开发代码。SpringMVC是一种web层mvc框架,用于替代servlet(处理 响应请求,获取表单参数,表单校验等。SpringMVC是一个MVC的开源框架,SpringMVC=struts2+spring,springMVC就相当于是Struts2加上Spring的整合。

- spring boot:约定大于配置,自动的配置和依赖管理。Spring Boot是为了简化Spring应用的创建、运行、调试、部署等而出现的,使用它可以做到专注于Spring应用的开发,而无需过多关注XML的配置。提供了一堆依赖打包,并已经按照使用习惯解决了依赖问题—>习惯大于约定。

@RestController vs @Controller

单独使用 @Controller 不加 @ResponseBody 的话一般使用在要返回一个视图的情况,这种情况属于比传统的Spring MVC 的应用,对应于前后端不分离的情况。

@RestController 返回JSON 或 XML 形式数据。

@Controller +@ResponseBody 返回JSON 或 XML 形式数据

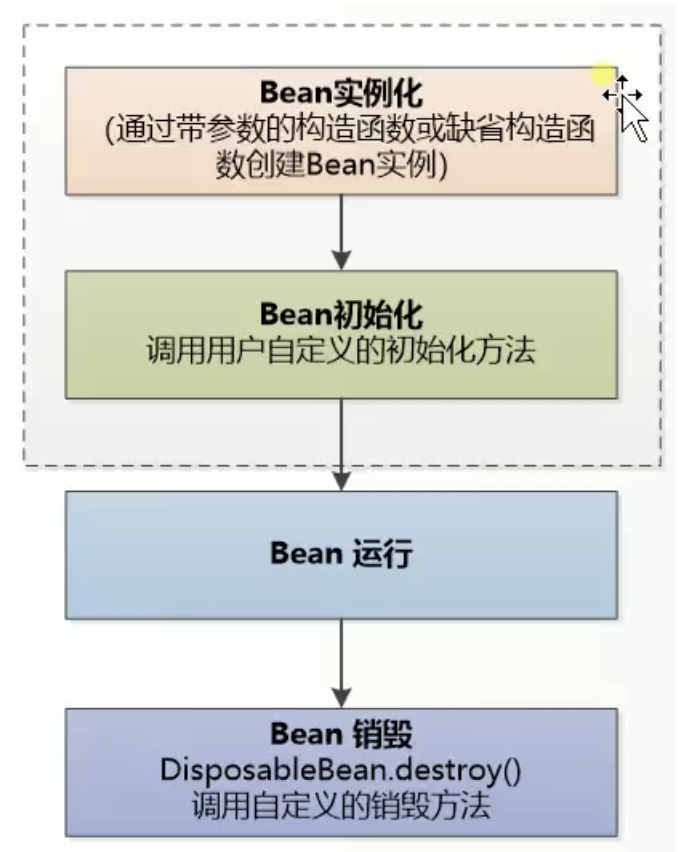

1.4.3.1 Spring Bean的生命周期

实例化,初始化,运行和销毁。

在 IoC 容器的初始化时会对 Bean 定义完成资源定位,加载读取配置并解析,最后将解析的 Bean 信息放在一个 HashMap 集合中。当 IoC 容器初始化后,会创建 Bean 实例并完成依赖注入,注入对象依赖的各种属性值,在初始化时可以指定自定义的初始化方法。经过一系列初始化操作后 Bean 达到可用状态,当使用完成后会调用 destroy 方法进行销毁,此时也可以指定自定义的销毁方法,最终 Bean 被销毁且从容器中移除。通过配置 bean 标签或注解中的 init-Method 和 destory-Method 属性指定自定义初始化和销毁方法。

BeanFactory、FactoryBean 和 ApplicationContext 的区别

BeanFactory 是一个 Bean 工厂,使用简单工厂模式,是 Spring IoC 容器顶级接口,作用是管理 Bean,包括实例化、定位、配置对象及维护对象间的依赖。BeanFactory 属于延迟加载,适合多例模式。

FactoryBean 是一个工厂 Bean,使用工厂方法模式,作用是生产其他 Bean 实例,可以通过实现该接口来自定义实例 Bean 的逻辑。如果一个 Bean 实现了这个接口,那么它就是创建对象的工厂 Bean,而不是 Bean 实例本身。

ApplicationConext是BeanFactory 的子接口,扩展了 BeanFactory 的功能,提供了支持国际化文本消息,统一的资源文件读取方式等功能。Bean 的依赖注入在容器初始化时就已经完成,属于立即加载,适合单例模式。

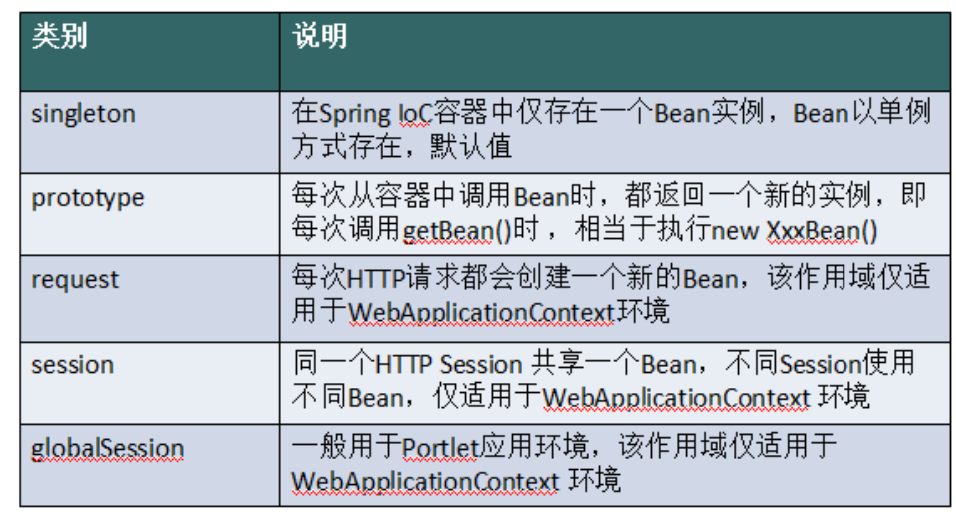

1.4.3.1 Spring Bean 的作用域

简单地讲,bean 就 是由 IOC 容器初始化、装配及管理的对象,除此之外,bean 就与应用程序中的其他对象没有什么区别了。而 bean 的定义以及 bean 相互间的依赖关系将通过配置元数据来描述。

Spring中的bean默认都是单例的,这些单例Bean在多线程程序下如何保证线程安全呢? 例如对于Web应用来说, Web容器对于每个用户请求都创建一个单独的Sevlet线程来处理请求,引入Spring框架之后,每个Action都是单例 的,那么对于Spring托管的单例Service Bean,如何保证其安全呢? Spring的单例是基于BeanFactory也就是Spring 容器的,单例Bean在此容器内只有一个,Java的单例是基于 JVM,每个 JVM 内只有一个实例。

1.4.3.2 Spring 事务中的隔离级别

TransactionDefinition 接口中定义了五个表示隔离级别的常量:

- TransactionDefinition.ISOLATION_DEFAULT: 使用后端数据库默认的隔离级别,Mysql 默认采用的 REPEATABLE_READ隔离级别。

- TransactionDefinition.ISOLATION_READ_UNCOMMITTED: 最低的隔离级别,允许读取尚未提交的数据变 更,可能会导致脏读、幻读或不可重复读

- TransactionDefinition.ISOLATION_READ_COMMITTED: 允许读取并发事务已经提交的数据,可以阻止脏读,但是幻读或不可重复读仍有可能发生

- TransactionDefinition.ISOLATION_REPEATABLE_READ: 可重复读,除非数据是被本身事务自己所修改,可以阻止脏读和不可重复读,但幻读仍有可能发生.

- TransactionDefinition.ISOLATION_SERIALIZABLE: 串行化。该级别可以防止脏读、不可重复读以及幻 读。但是这将严重影响程序的性能。

1.4.3.3 Spring事务传播行为

事务传播行为(为了解决业务层方法之间互相调用的事务问题): 当事务方法被另一个事务方法调用时,必须指定事务应该如何传播。

- propagation_requierd:如果当前没有事务,就新建一个事务,如果已存在一个事务中,加入到这个事务中,这是最常见的选择。

- propagation_supports:支持当前事务,如果没有当前事务,就以非事务方法执行。

- propagation_mandatory:使用当前事务,如果没有当前事务,就抛出异常。

- propagation_required_new:新建事务,如果当前存在事务,把当前事务挂起。

- propagation_not_supported:以非事务方式执行操作,如果当前存在事务,就把当前事务挂起。

- propagation_never:以非事务方式执行操作,如果当前事务存在则抛出异常。

- propagation_nested:如果当前存在事务,则在嵌套事务内执行。如果当前没有事务,则执行与propagation_required类似的操作;

1.4.4 Mybatis

Mybatis、Hibernate都是ORM的一种实现框架,都是对JDBC的一种封装。

| Hibernate | Mybatis |

|---|---|

| 无需sql代码 | |

| 处理复杂业务时,灵活度差, 复杂的HQL难写难理解,例如多表查询的HQL语句 | 处理复杂逻辑 |

#和$的区别?

二者都是占位符。

| # | $ |

|---|---|

| 当做一个字符串,对传入的数据加一个双引号 | 直接显示生成SQL中 |

| 预编译,防止sql注入 | 无法防止sql注入 |

| 优先使用 |

- 实体类中的属性名和表中的字段名不一样 ,怎么办

在查询的sql语句中定义字段名的别名,让字段名的别名和实体类的属性名一致;

通过resultmap来映射字段名和实体类属性名的一一对应的关系;

- Mybatis动态sql是做什么的?都有哪些动态sql?能简述一下动态sql的执行原理不?

- Mybatis动态sql可以让我们在Xml映射文件内,以标签的形式编写动态sql,完成逻辑判断和动态 拼接sql的功能。

-

Mybatis提供了9种动态sql标签:trim where set foreach if choose when otherwise bind。 - 其执行原理为,使用OGNL从sql参数对象中计算表达式的值,根据表达式的值动态拼接sql,以此 来完成动态sql的功能。

- 为什么说Mybatis是半自动ORM映射工具?它与全自动的区别在哪里?

Hibernate属于全自动ORM映射工具,使用Hibernate查询关联对象或者关联集合对象时,可以根 据对象关系模型直接获取,所以它是全自动的。

而Mybatis在查询关联对象或关联集合对象时,需要手动编写sql来完成,所以,称之为半自动 ORM映射工具。

- MyBatis中命名空间(namespace)的作用。

在大型项目中,可能存在大量的SQL语句,这时候为每个SQL语句起一个唯一的标识(ID)就变得并不容易了。为了解决这个问题,在MyBatis中,可以为每个映射文件起一个唯一的命名空间,这样定义在这个映射文件中的每个SQL语句就成了定义在这个命名空间中的一个ID。只要我们能够保证每个命名空间中这个ID是唯一的,即使在不同映射文件中的语句ID相同,也不会再产生冲突了。

1.4.5 nginx

Nginx是一款轻量级的Web 服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器。 Nginx 主要提供反向代

理、负载均衡、动静分离(静态资源服务)等服务。下面我简单地介绍一下这些名词。

反向代理

谈到反向代理,就不得不提一下正向代理。无论是正向代理,还是反向代理。

- 正向代理:代理客户端

- 反向代理: 是用来代理服务器的,代理我们要访问的目标服务器

负载均衡

在高并发情况下需要使用,其原理就是将并发请求分摊到多个服务器执行,减轻每台服务器的压力,多台服务器(集群)共同完成工作任务,从而提高了数据的吞吐量。 Nginx支持的weight轮询(默认)、ip_hash、fair、url_hash这四种负载均衡调度算法。负载均衡相比于反向代理更侧重的时将请求分担到多台服务器上去,所以谈论负载均衡只有在提供某服务的服务器大 于两台时才有意义。

动静分离

动静分离是让动态网站里的动态网页根据一定规则把不变的资源和经常变的资源区分开来,动静资源做好了拆分以 后,我们就可以根据静态资源的特点将其做缓存操作,这就是网站静态化处理的核心思路。

Nginx 有以下5个优点:

- 高并发、高性能(这是其他web服务器不具有的)

- 可扩展性好(模块化设计,第三方插件生态圈丰富)

- 高可靠性(可以在服务器行持续不间断的运行数年)

- 热部署(这个功能对于 Nginx 来说特别重要,热部署指可以在不停止 Nginx服务的情况下升级 Nginx)

- BSD许可证(意味着我们可以将源代码下载下来进行修改然后使用自己的版本)

Nginx 的四个主要组成部分了解吗

- Nginx 二进制可执行文件:由各模块源码编译出一个文件

- Nginx.conf 配置文件:控制Nginx 行为

- acess.log 访问日志: 记录每一条HTTP请求信息

- error.log 错误日志:定位问题

1.4.6 redis

1.4.6.1 为什么要用redis

高性能:假如用户第一次访问数据库中的某些数据。这个过程会比较慢,因为是从硬盘上读取的。将该用户访问的数据存在数缓存中,这样下一次再访问这些数据的时候就可以直接从缓存中获取了。

高并发:直接操作缓存能够承受的请求是远远大于直接访问数据库的。

1.4.6.2 redis为什么快

1、完全基于内存,绝大部分请求是纯粹的内存操作,非常快速。

2、数据结构简单,对数据操作也简单,Redis 中的数据结构是专门进行设计的;

3、采用单线程,避免了不必要的上下文切换和竞争条件,也不存在多进程或者多线程导致的切换而消耗 CPU,不用去考虑各种锁的问题,不存在加锁释放锁操作,没有因为可能出现死锁而导致的性能消耗;

4、使用多路 I/O 复用模型,非阻塞 IO;

1.4.6.3 为什么要用 redis 而不用 map/guava 做缓存

缓存分为本地缓存和分布式缓存。以 Java 为例,使用自带的 map 或者 guava 实现的是本地缓存,最主要的特点是 轻量以及快速,生命周期随着 jvm 的销毁而结束,并且在多实例的情况下,每个实例都需要各自保存一份缓存,缓 存不具有一致性。使用 redis 或 memcached 之类的称为分布式缓存,在多实例的情况下,各实例共用一份缓存数据,缓存具有一致性。

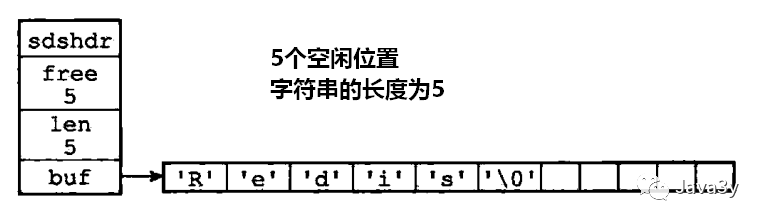

1.4.6.4 redis 常见数据结构

1.4.6.4.1 SDS (Simple Dynamic String)字符串

常用命令:set,get,decr,incr,mget。用在常规计数:微博数,粉丝数等。

简单动态字符串(Simple dynamic string,SDS),Redis使用sdshdr结构来表示一个SDS值:

struct sdshdr{

// 字节数组,用于保存字符串

char buf[];

// 记录buf数组中已使用的字节数量,也是字符串的长度

int len;

// 记录buf数组未使用的字节数量

int free;

}

- sdshdr数据结构中用len属性记录了字符串的长度。那么获取字符串的长度时,时间复杂度只需要O(1)。

- SDS不会发生溢出的问题,如果修改SDS时,空间不足。先会扩展空间,再进行修改!(内部实现了动态扩展机制)。

- SDS可以减少内存分配的次数(空间预分配机制)。在扩展空间时,除了分配修改时所必要的空间,还会分配额外的空闲空间(free 属性)。

- SDS是二进制安全的,所有SDS API都会以处理二进制的方式来处理SDS存放在buf数组里的数据。

1.4.6.4.2 链表list

双向链表。

常用命令: lpush,rpush,lpop,rpop,lrange等。可以通过 lrange 命令,就是从某个元素开始读取多少个元素,可以基于 list 实现分⻚查询,这 个很棒的一个功能,基于 redis 实现简单的高性能分⻚,可以做类似微博那种下拉不断分⻚的东⻄ (一⻚一⻚的往下走)。比如微博的关注列表,粉丝列表,消息列表。

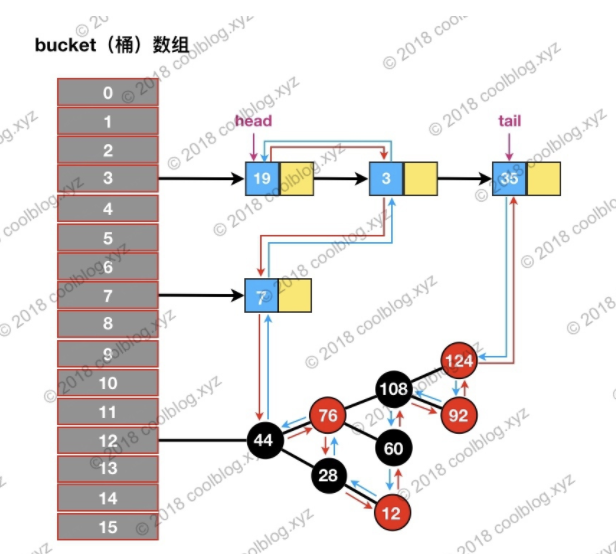

1.4.6.4.3 hash

常用命令:hget,hset。存储用户信息,商品信息等等。

Redis是专门使用一个哈希表来做rehash的。Redis在rehash时采取渐进式的原因:数据量如果过大的话,一次性rehash会有庞大的计算量,这很可能导致服务器一段时间内停止服务。

- 在字典中维持一个索引计数器变量rehashidx,并将设置为0,表示rehash开始。

- 在rehash期间每次对字典进行增加、查询、删除和更新操作时,除了执行指定命令外;还会将ht[0]中rehashidx索引上的值rehash到ht[1],操作完成后rehashidx+1。

- 字典操作不断执行,最终在某个时间点,所有的键值对完成rehash,这时将rehashidx设置为-1,表示rehash完成

- 在渐进式rehash过程中,字典会同时使用两个哈希表ht[0]和ht[1],所有的更新、删除、查找操作也会在两个哈希表进行。例如要查找一个键的话,服务器会优先查找ht[0],如果不存在,再查找ht[1],诸如此类。此外当执行新增操作时,新的键值对一律保存到ht[1],不再对ht[0]进行任何操作,以保证ht[0]的键值对数量只减不增,直至变为空表。

1.4.6.4.4 set

常用命令sadd,spop,smembers,sunion。在微博应用中,可以将一个用户所有的关注人存在一个集合中,将其所有粉丝存在一个集合。 Redis可以非常方便的实现如共同关注、共同粉丝、共同喜好等功能。

hashtable或者intset(只包含整数)。

1.4.6.4.5 sortedset(zset)

常用命令: zadd,zrange,zrem,zcard等。在直播系统中,实时排行信息包含直播间在线用户列表,各种礼物排行榜,弹幕消息(可以理 解为按消息维度的消息排行榜)等信息。还可以用来处理带权重的任务。

可以按照权重进行排序。底层的数据结构是ziplist或者skiplist,当元素的数量小于128且每个元素的长度都小于64字节的时候,数据结构是ziplist。skiplist,基于有序链表的扩展,可以快速查找有序链表的某个节点。利用索引的思想,提取出链表中的部分关键节点,比如提取所有的奇数节点,这样可以减少一半的比较次数。当节点数比较多的时候,可以在提取一半,这样又可以减少一半的比较。这样的多层链表结构,就是跳表。需要注意的是,新节点也可能成为索引节点,每个节点被选的标准是50%。这样做的原因是删除和增加节点的概率是不可预测的。

1.4.6.5 redis 设置过期时间

Redis中有个设置时间过期的功能,即对存储在 redis 中的值可以设置一个过期时间。如我们一般项目中的短信验证码都是有时间限制的,按照传统的数据库处理方式,一般都是自己判断过期。我们 set key 的时候,都可以给一个 expire time,即过期时间。

如果假设你设置了一批 key 只能存活1个小时,redis是怎么对这批key进行删除的? 定期删除+惰性删除。

- 定期删除:redis默认是每隔 100ms 就随机抽取一些设置了过期时间的key,检查其是否过期,如果过期就删 除。注意这里是随机抽取的。为什么要随机呢?你想一想假如 redis 存了几十万个 key ,每隔100ms就遍历所 有的设置过期时间的 key 的话,就会给 CPU 带来很大的负载!

- 惰性删除 :定期删除可能会导致很多过期 key 到了时间并没有被删除掉。所以就有了惰性删除。假如你的过期 key,靠定期删除没有被删除掉,还停留在内存里。

但是仅仅通过设置过期时间还是有问题的。我们想一下:如果定期删除漏掉了很多过期 key,然后你也没及时去查, 也就没走惰性删除,此时会怎么样?如果大量过期key堆积在内存里,导致redis内存块耗尽了。怎么解决这个问题呢?redis 内存淘汰机制。

1.4.6.6 redis 内存淘汰机制

MySQL里有2000w数据,Redis中只存20w的数据,如何保证Redis中的数据都是热点数据?和内存淘汰类似。

- volatile-lru:从已设置过期时间的数据集(server.db[i].expires)中挑选最近最少使用的数据淘汰

- volatile-ttl:从已设置过期时间的数据集(server.db[i].expires)中挑选将要过期的数据淘汰

- volatile-random:从已设置过期时间的数据集(server.db[i].expires)中任意选择数据淘汰

- allkeys-lru:当内存不足以容纳新写入数据时,在键空间中,移除最近最少使用的key(这个是最常用的).

- allkeys-random:从数据集(server.db[i].dict)中任意选择数据淘汰

- no-eviction:禁止驱逐数据,也就是说当内存不足以容纳新写入数据时,新写入操作会报错。这个应该没人使 用吧!

1.4.6.7 redis 持久化机制

很多时候我们需要持久化数据也就是将内存中的数据写入到硬盘里面,大部分原因是为了之后重用数据(比如重启机 器、机器故障之后回复数据),或者是为了防止系统故障而将数据备份到一个远程位置。

- 快照(snapshotting)持久化(RDB)

Redis可以通过创建快照来获得存储在内存里面的数据在某个时间点上的副本。Redis创建快照之后,可以对快照进行 备份,可以将快照复制到其他服务器从而创建具有相同数据的服务器副本(Redis主从结构,主要用来提高Redis性 能),还可以将快照留在原地以便重启服务器的时候使用。快照持久化是Redis默认采用的持久化方式。

- AOF(append-only file)持久化

与快照持久化相比,AOF持久化 的实时性更好,因此已成为主流的持久化方案。

1.4.6.8 redis 事务

Redis 通过 MULTI、EXEC、WATCH 等命令来实现事务(transaction)功能。事务提供了一种将多个命令请求打包,然 后一次性、按顺序地执行多个命令的机制,并且在事务执行期间,服务器不会中断事务而改去执行其他客户端的命令 请求,它会将事务中的所有命令都执行完毕,然后才去处理其他客户端的命令请求。

MULTI:用于开启一个事务,它总是返回OK。MULTI执行之后,客户端可以继续向服务器发送任意多条命令,这些命令不会立即被执行,而是被放到一个队列中,当EXEC命令被调用时,所有队列中的命令才会被执行。

Exec:执行所有事务块内的命令。返回事务块内所有命令的返回值,按命令执行的先后顺序排列。

Watch:是一个乐观锁。

1.4.6.9 pipeline

由于IO请求的耗时远大于命令的耗时,pipline可以将多次操作进行合并,减少IO请求。

1.4.6.10 缓存雪崩和缓存穿透问题解决方案

缓存雪崩

缓存同一时间大面积的失效,后面的请求都会落到数据库上,造成数据库短时间内承受大量请求而崩掉。

解决办法:

- 加锁/队列:来避免同时读写。减轻数据库的压力,并没有提高系统吞吐量。还要解决分布式锁的问题。

- 缓存随机失效:

- 设置过期标志更新缓存:缓存标记:记录缓存数据是否过期,如果过期会触发通知另外的线程在后台去更新实际key的缓存;缓存数据:它的过期时间比缓存标记的时间延长1倍。

缓存穿透

一般是黑客故意去请求缓存中不存在的数据,导致所有的请求都落到数据库上,造成数据库短时间内承受大量请求而崩掉。

- 将查询出来的数据放到缓存中。比如当id=-1的请求发送到数据库,数据库查询出来为(-1,null),将这个数值对存放到缓存中,之后的请求到达缓存后,直接返回null值。但它的过期时间会很短,最长不超过五分钟。

- 布隆过滤器:将所有可能存在的数据哈 希到一个足够大的bitmap中,一个一定不存在的数据会被 这个bitmap拦截掉,从而避免了对底层存储系统的查询压 力。布隆过滤器hash三次,减少了内存空间的占用。

1.4.6.11 如何解决 Redis 的并发竞争 Key 问题

所谓 Redis 的并发竞争 Key 的问题也就是多个系统同时对一个 key 进行操作,但是最后执行的顺序和我们期望的顺 序不同,这样也就导致了结果的不同,这就是脏读。

解决方案:分布式锁。

- zookeeper

利用Zookeeper的临时顺序节点(在创建节点时,Zookeeper根据创建的时间顺序给该节点名称进行编号;当创建节点的客户端与zookeeper断开连接后,临时节点会被删除)。

- 获取锁

在Zookeeper当中创建一个持久节点ParentLock。当第一个客户端想要获得锁时,需要在ParentLock这个节点下面创建一个临时顺序节点Lock1。之后,Client1查找ParentLock下面所有的临时顺序节点并排序,判断自己所创建的节点Lock1是不是顺序最靠前的一个。如果是第一个节点,则成功获得锁。Client2查找ParentLock下面所有的临时顺序节点并排序,判断自己所创建的节点Lock2是不是顺序最靠前的一个,结果发现节点Lock2并不是最小的。于是,Client2向排序仅比它靠前的节点Lock1注册Watcher,用于监听Lock1节点是否存在。这意味着Client2抢锁失败,进入了等待状态。类似与AQS。

- 释放锁

客户端显示释放。客户端崩溃,自动释放。

- redis

加锁:setnx(key,1)当一个线程执行setnx返回1,说明key原本不存在,该线程成功得到了锁;当一个线程执行setnx返回0,说明key已经存在,该线程抢锁失败。

释放锁:del(key)

锁超时时间:expire,解决锁无法释放的问题。

问题1:setnx和expire不是原子指令,如果在setnx之后执行expire之前进程意外crash或者要重启维护了, 锁无法释放。在高版本可以使用set(key,1,30,NX)指令来代替。

问题2:del误删。线程1设置了30s自动删除,但是30s没有执行完,被其他线程获取到锁,又执行了del。我们可以在删除的时候,判断是不是自己的锁。新的问题,判断和删除不是原子操作。使用lua脚本。

问题3:出现并发的可能性。场景同上。增加守护进程,如果29s没有执行完,则执行expire续命。

1.4.6.12 redis集群

Redis Cluster至少6个节点,3主3从。

节点的扩展与收缩:

主从复制:解决单点故障,容量瓶颈的问题。

1.4.6.13 其他

1. 假如Redis里面有1亿个key,其中有10w个key是以某个固定的已知的前缀开头的,如果将它们全部找出来?

使用keys指令可以扫出指定模式的key列表。

对方接着追问:如果这个redis正在给线上的业务提供服务,那使用keys指令会有什么问题?

这个时候你要回答redis关键的一个特性:redis的单线程的。keys指令会导致线程阻塞一段时间,线上服务会停顿,直到指令执行完毕,服务才能恢复。这个时候可以使用scan指令,scan指令可以无阻塞的提取出指定模式的key列表,但是会有一定的重复概率,在客户端做一次去重就可以了,但是整体所花费的时间会比直接用keys指令长。

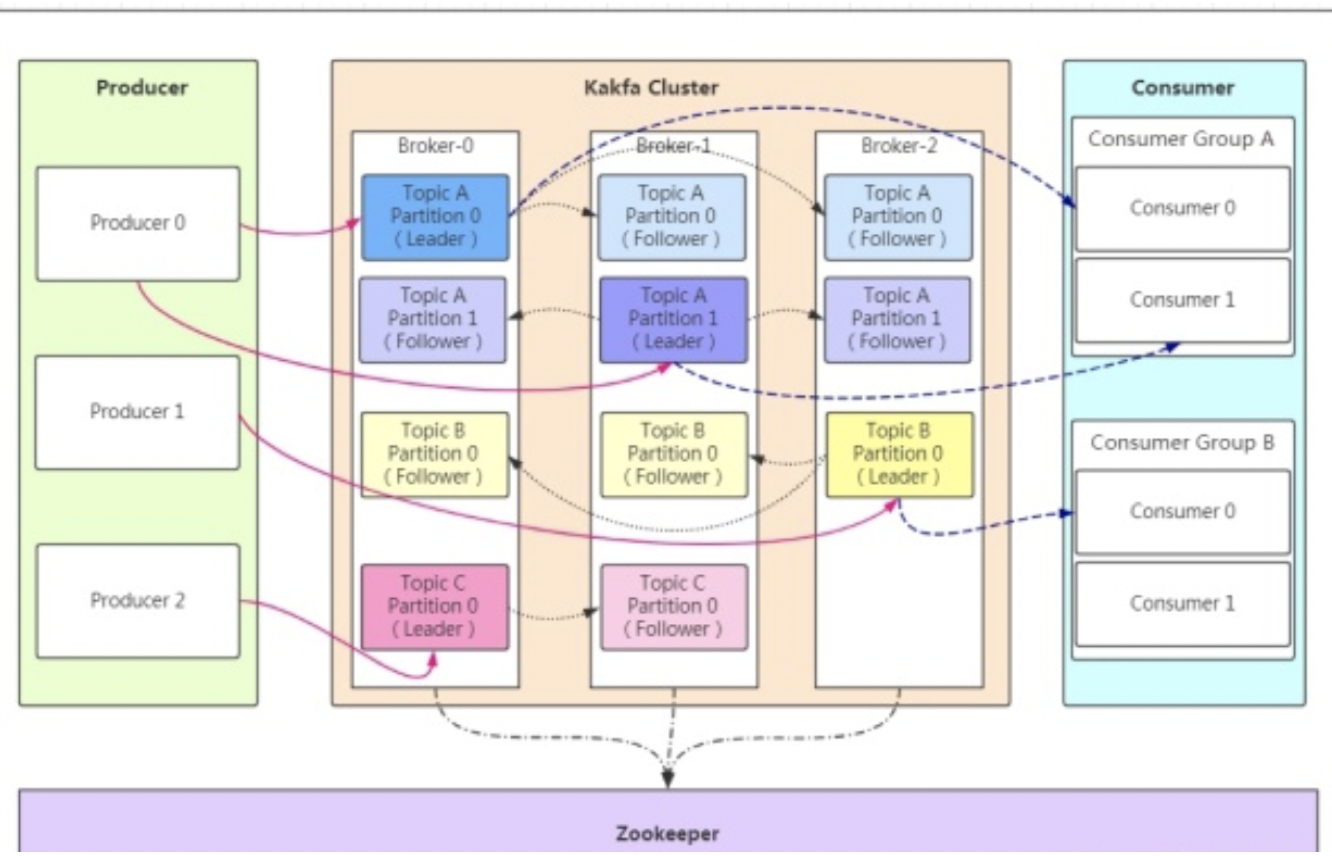

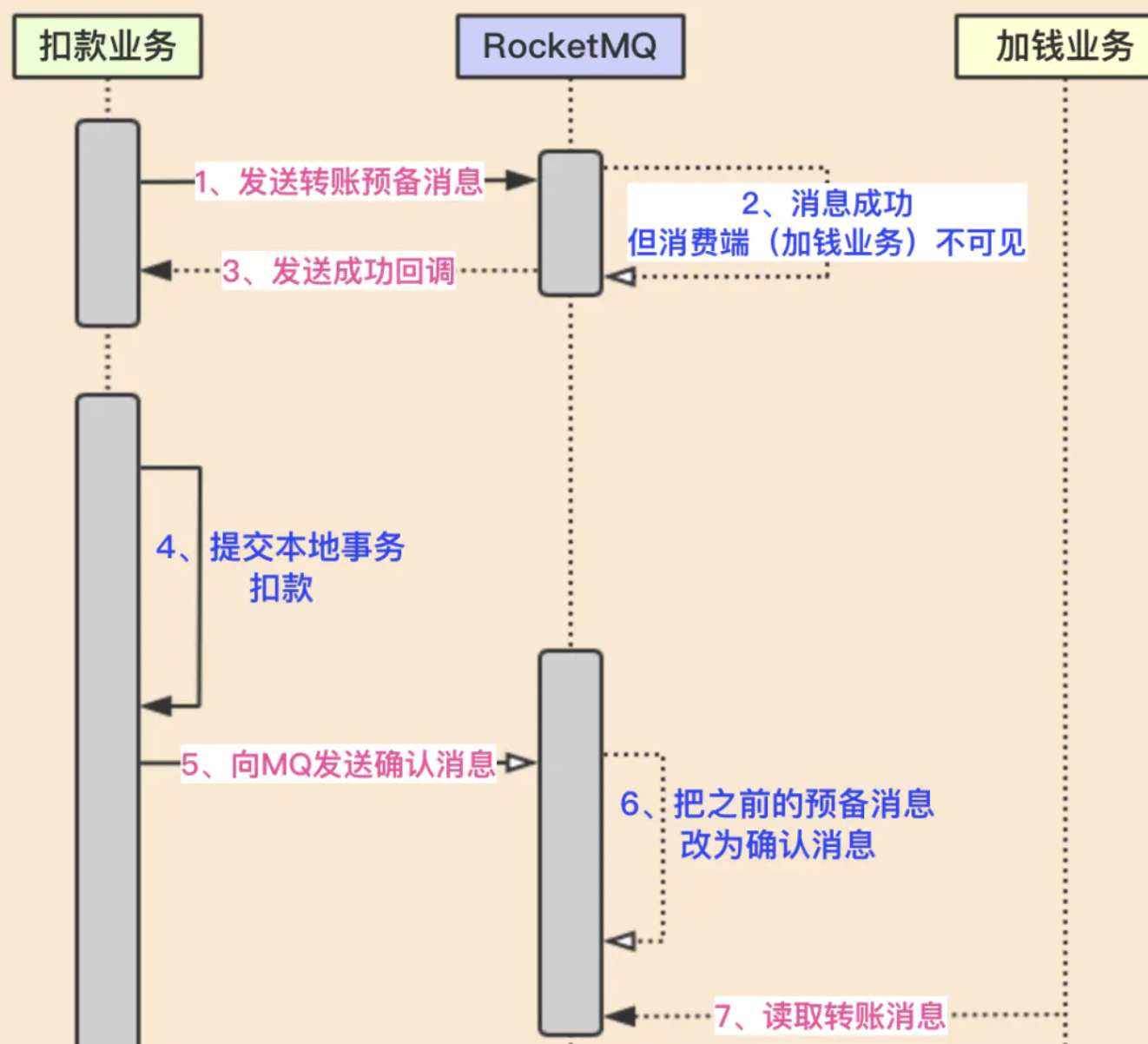

1.4.8 消息队列

1.4.8.1 介绍一下消息队列MQ的应用场景/使用消息队列的好处

在不使用消息队列服务器的时候,用户的请求数据直接写入数据库,在高并发的情况下数据库压力剧增,使 得响应速度变慢。但是在使用消息队列之后,用户的请求数据发送给消息队列之后立即返回,再由消息队列的消费者进程从消息队列中获取数据,异步写入数据库。由于消息队列服务器处理速度快于数据库(消息队列也比数据库有更好的伸缩性),因此响应速度得到大幅改善。

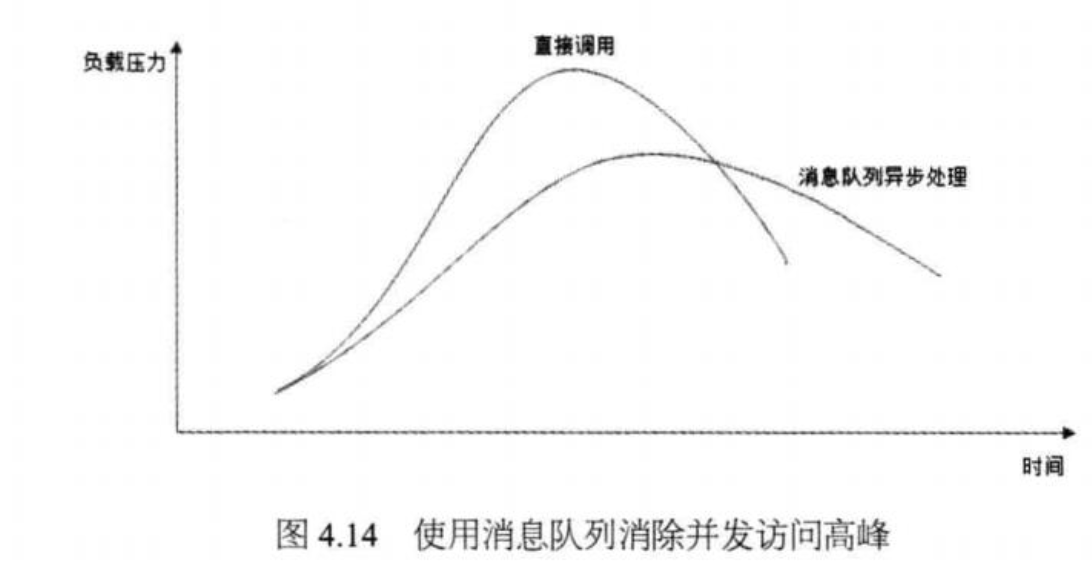

通过以上分析我们可以得出消息队列具有很好的削峰作用的功能——即通过异步处理,将短时间高并发产生的事务消息存储在消息队列中,从而削平高峰期的并发事务。 举例:在电子商务一些秒杀、促销活动中,合理使用消息队列 可以有效抵御促销活动刚开始大量订单涌入对系统的冲击。如下图所示:

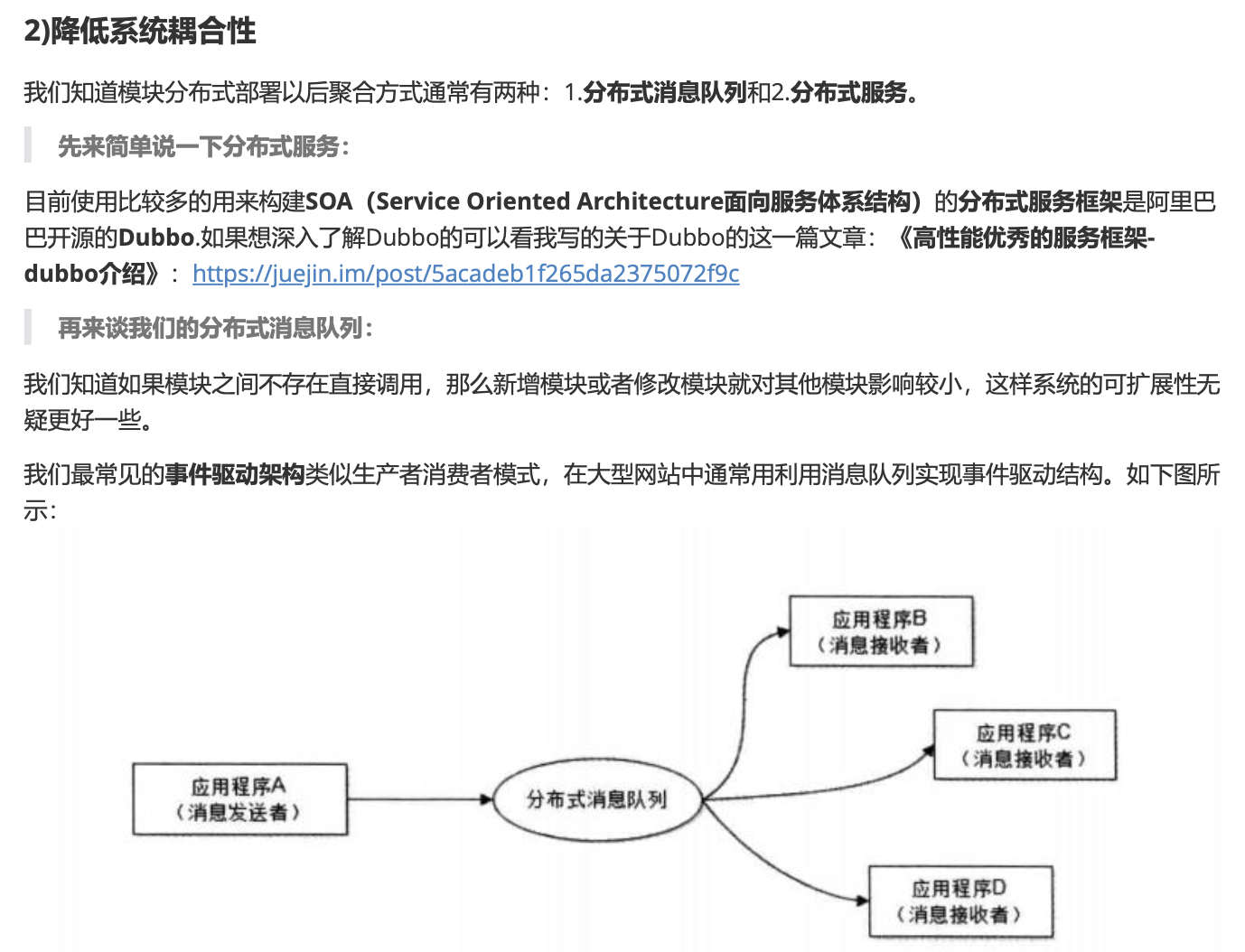

解耦。因为用户请求数据写入消息队列之后就立即返回给用户了,但是请求数据在后续的业务校验、写数据库等操作中可能 失败。因此使用消息队列进行异步处理之后,需要适当修改业务流程进行配合,比如用户在提交订单之后,订单数据写入消息队列,不能立即返回用户订单提交成功,需要在消息队列的订单消费者进程真正处理完该订单之后,甚至出库后,再通过电子邮件或短信通知用户订单成功,以免交易纠纷。这就类似我们平时手机订火车票和电影票。

消息队列使利用发布-订阅模式工作,生产者发布消息,消费者订阅消息。 从上图可以看到生产者和消费者之间没有直接耦合,消息发送者将消息发送至分布式消息队列即结束对消息的处理,消息接受者从分布式消息队列获取该消息后进行后续处理,并不需要知道该消息从何而来。对新增业务,只要对该类消息感兴趣,即可订阅该消息,对原有系统和业务没有任何影响。

消息接受者对消息进行过滤、处理、包装后,构造成一个新的消息类型,将消息继续发送出去,等待其他消息接受者订阅该消息。因此基于事件驱动的业务架构可以是一系列流程。为了避免消息队列服务器宕机造成消息丢失,会将成功发送到消息队列的消息存储在消息生产者服务器上,等消息真正被消费者服务器处理后才删除消息。

1.4.8.2 使用消息队列会带来什么问题?考虑过这些问题吗?

- 系统可用性降低: 系统可用性在某种程度上降低,为什么这样说呢?在加入MQ之前,你不用考虑消息丢失或 者说MQ挂掉等等的情况,但是,引入MQ之后你就需要去考虑了!

- 系统复杂性提高: 加入MQ之后,你需要保证消息没有被重复消费、处理消息丢失的情况、保证消息传递的顺序性等等问题!

- 一致性问题: 我上面讲了消息队列可以实现异步,消息队列带来的异步确实可以提高系统响应速度。但是,万 一消息的真正消费者并没有正确消费消息怎么办?这样就会导致数据不一致的情况了!

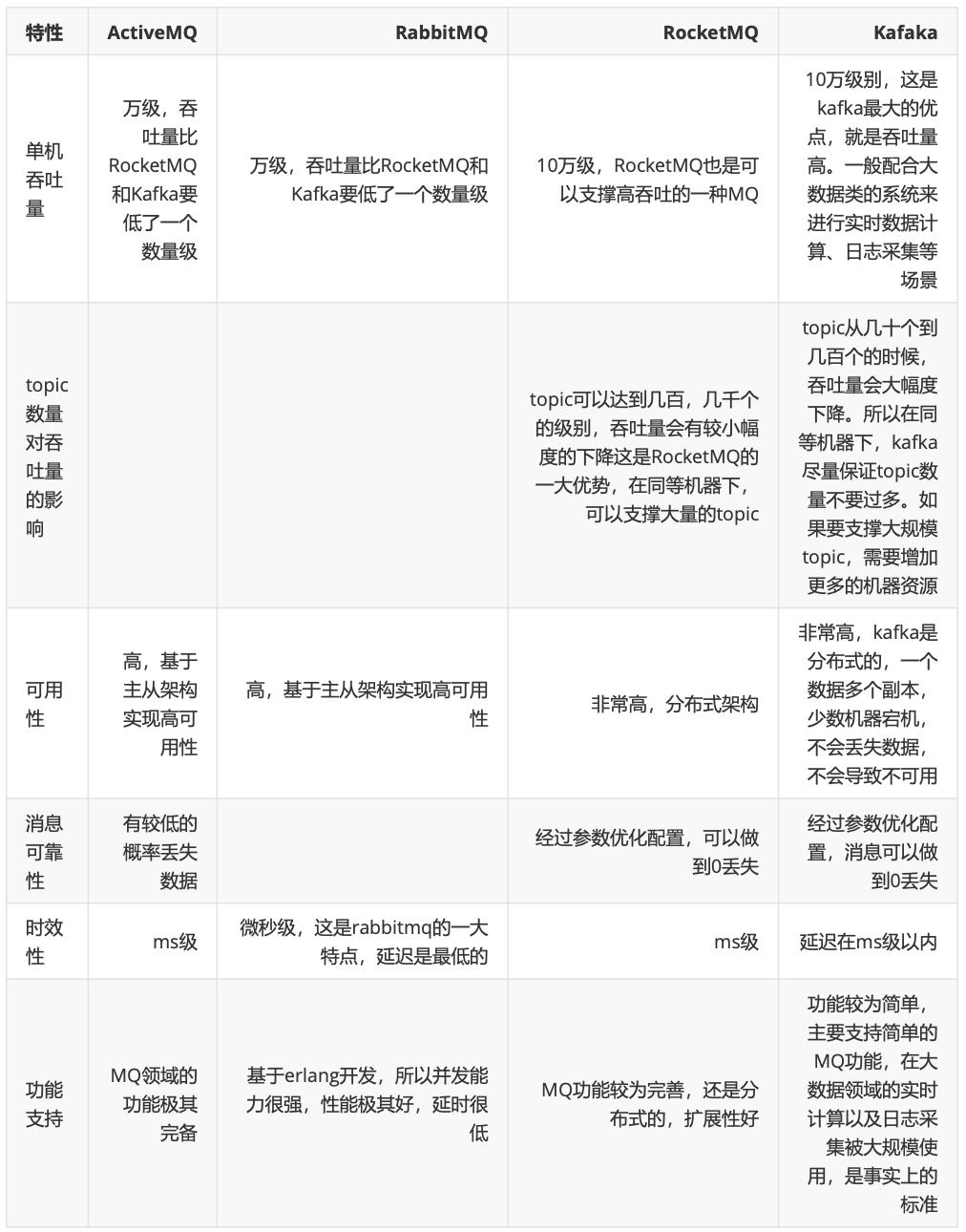

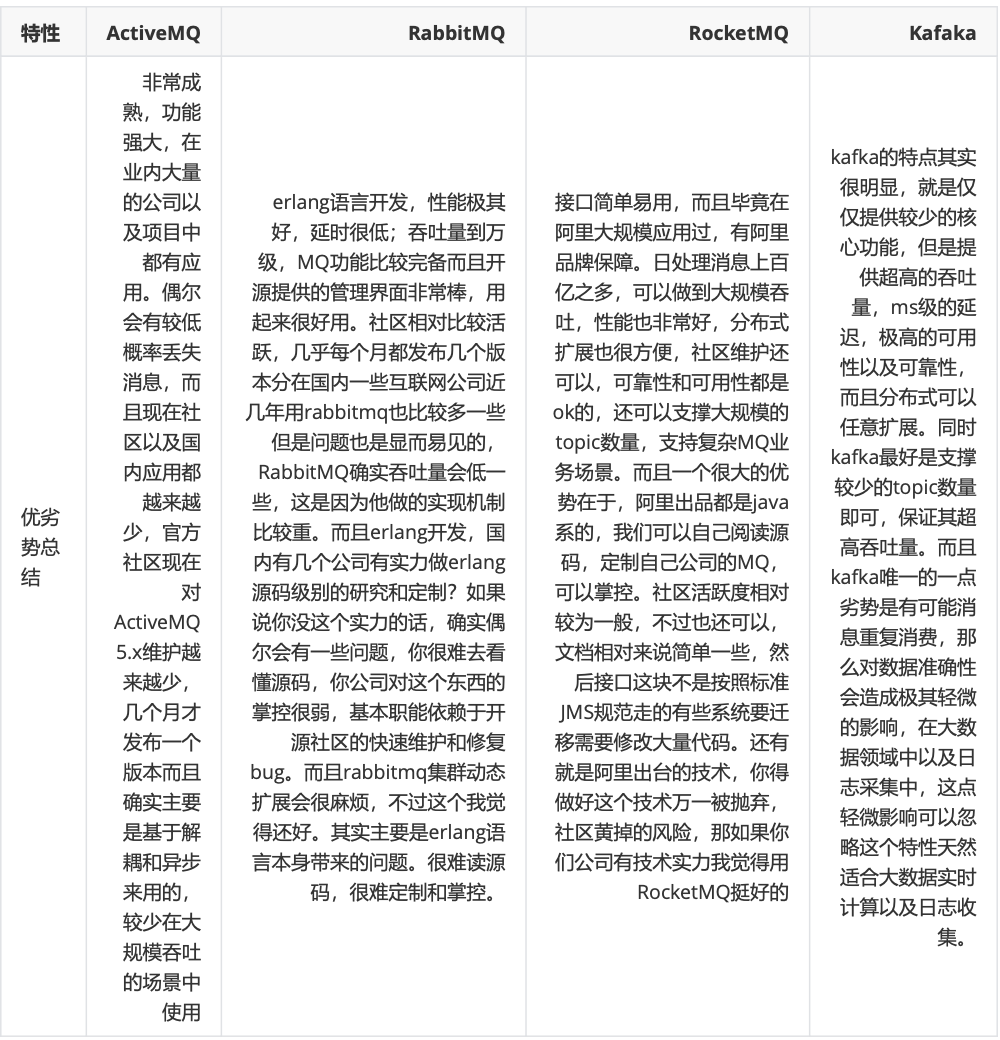

1.4.8.3 介绍一下你知道哪几种消息队列,该如何选择呢?

1.4.9 dubbo

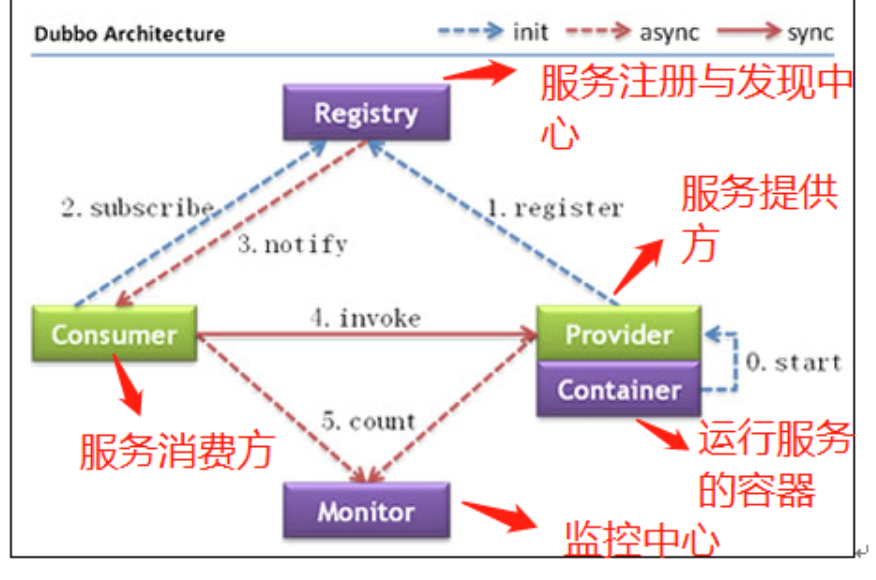

Provider: 暴露服务的服务提供方 Consumer: 调用远程服务的服务消费方 Registry: 服务注册与发现的注册中心 Monitor: 统计服务的调用次数和调用时间的监控中心

Container: 服务运行容器

调用关系说明:

-

服务容器负责启动,加载,运行服务提供者。

-

服务提供者在启动时,向注册中心注册自己提供的服务。

-

服务消费者在启动时,向注册中心订阅自己所需的服务。

-

注册中心返回服务提供者地址列表给消费者,如果有变更,注册中心将基于长连接推送变更数据给消费者。

-

服务消费者,从提供者地址列表中,基于软负载均衡算法,选一台提供者进行调用,如果调用失败,再选另一

台调用。

-

服务消费者和提供者,在内存中累计调用次数和调用时间,定时每分钟发送一次统计数据到监控中心。

重要知识点总结:

- 注册中心负责服务地址的注册与查找,相当于目录服务,服务提供者和消费者只在启动时与注册中心交互,注 册中心不转发请求,压力较小

- 监控中心负责统计各服务调用次数,调用时间等,统计先在内存汇总后每分钟一次发送到监控中心服务器,并 以报表展示

- 注册中心,服务提供者,服务消费者三者之间均为长连接,监控中心除外

- 注册中心通过长连接感知服务提供者的存在,服务提供者宕机,注册中心将立即推送事件通知消费者

- 注册中心和监控中心全部宕机,不影响已运行的提供者和消费者,消费者在本地缓存了提供者列表

- 注册中心和监控中心都是可选的,服务消费者可以直连服务提供者 服务提供者无状态,任意一台宕掉后,不影响使用

- 服务提供者全部宕掉后,服务消费者应用将无法使用,并无限次重连等待服务提供者恢复

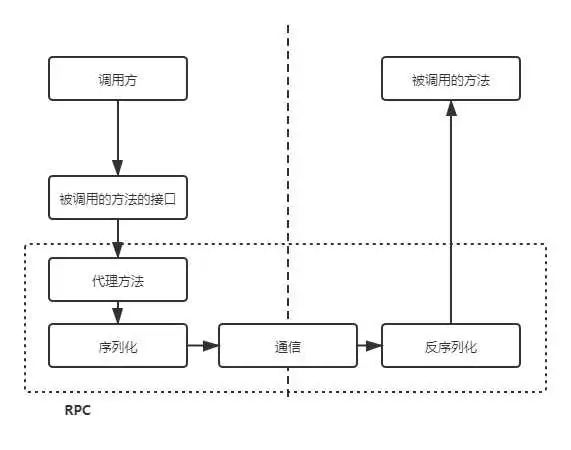

RPC 只是一种概念、一种设计,就是为了解决 不同服务之间的调用问题, 它一般会包含有 传输协议 和 序列化协议 这两个。但是,HTTP 是一种协议,RPC框架可以使用 HTTP协议作为传输协议或者直接使用TCP作为传输协议,使用不同的协议一般也是为了适应不同的场景。

http是面向资源的,rpc是面向函数的。

http存在大量无用的信息,浪费资源,rpc可以自定义头,节省资源。

HTTP协议,以其中的Restful规范为代表,其优势很大。它可读性好,且可以得到防火墙的支持、跨语言的支持。

HTTP也有其缺点,这是与其优点相对应的。首先是有用信息占比少,毕竟HTTP工作在第七层,包含了大量的HTTP头等信息。其次是效率低,还是因为第七层的缘故。还有,其可读性似乎没有必要,因为我们可以引入网关增加可读性。此外,使用HTTP协议调用远程方法比较复杂,要封装各种参数名和参数值。

成熟的 RPC框架还提供好了“服务自动注册与发现”、”智能负载均衡”、“可视化的服务治理和运维”、“运行期流量调度”等等功能,这些也算是选择 RPC 进行服务注册和发现的一方面原因吧!

基于Restful的远程过程调用有着明显的缺点,主要是效率低、封装调用复杂。当存在大量的服务间调用时,这些缺点变得更为突出。服务A调用服务B的过程是应用间的内部过程,牺牲可读性提升效率、易用性是可取的。基于这种思路,RPC产生了。通常,RPC要求在调用方中放置被调用的方法的接口。调用方只要调用了这些接口,就相当于调用了被调用方的实际方法,十分易用。于是,调用方可以像调用内部接口一样调用远程的方法,而不用封装参数名和参数值等操作。

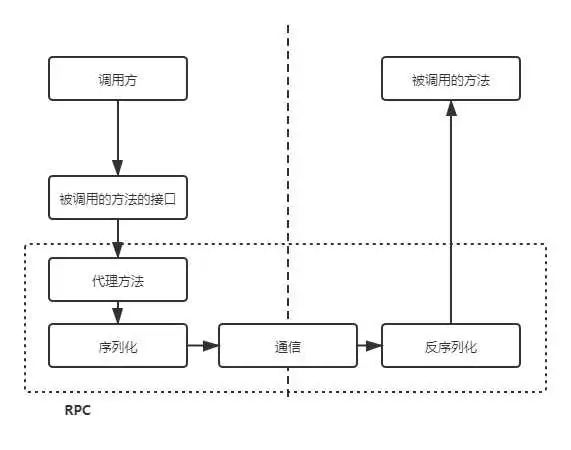

首先,调用方调用的是接口,必须得为接口构造一个假的实现。显然,要使用动态代理。这样,调用方的调用就被动态代理接收到了。

第二,动态代理接收到调用后,应该想办法调用远程的实际实现。这包括下面几步:

- 识别具体要调用的远程方法的IP、端口

- 将调用方法的入参进行序列化

- 通过通信将请求发送到远程的方法中

这样,远程的服务就接收到了调用方的请求。它应该:

- 反序列化各个调用参数

- 定位到实际要调用的方法,然后输入参数,执行方法

- 按照调用的路径返回调用的结果

整个过程如下所示。

1.4.10 git

git init新建代码库;

git status,查看仓库是否修改;

git commit –amend -m ‘xxx’,合并上一次提交;

git rm删除,git rm –cached停止追踪但不删除;

git blame查看谁提交的;

git cherry-pick ff44785404a8e,合并提交ff44785404a8e的修改;

stash:暂存; stash pop:弹出;stash apply,应用但不弹出;

rebase:提交历史会成一条线;merge:提交历史会变成交织的网状(保留详细的merge的信息);

在rebase的时候,如果遇到冲突,可以手动解决(也可以使用git checkout –theirs .,git add . / git checkout –ours . , git add .),解决好之后,可以git rebase –continue继续合并;